MultiTalk 升级了 - 新工作流程带来比以前更好的动画效果 - 图像到视频

MultiTalk 大幅升级。在使用 8 块 A6000 48GB GPU 对 MultiTalk 进行了一天多的研究后,我显著改进了 MultiTalk 的工作流程,现在我将分享 4 种不同类别的工作流程。VRAM 使用量和速度保持不变,但质量和动画效果更好。此外,我还推出了一款新的图像和视频对比滑块应用。它超快、轻量,作为 HTML 应用运行,无需 GPU。

🔗 最新教程 ⤵️

▶️ https://youtu.be/wgCtUeog41g

🔗 您必须观看的主要教程 ⤵️

▶️ https://youtu.be/8cMIwS9qo4M

🔗 请点击以下链接下载包含 MultiTalk 捆绑下载器 Gradio App 的 zip 文件——教程中使用的就是它 ⤵️

▶️ https://www.patreon.com/posts/SwarmUI-Installer-AI-Videos-Downloader-114517862

🔗 请点击以下链接下载包含 ComfyUI 一键安装程序和教程中显示的工作流程的 zip 文件,该工作流程支持 Flash Attention, Sage Attention, xFormers, Triton, DeepSpeed, RTX 5000 系列 ⤵️

▶️ https://www.patreon.com/posts/Advanced-ComfyUI-1-Click-Installer-105023709

🔗 请点击以下链接下载包含图像和视频对比滑块应用的 zip 文件 ⤵️

▶️ https://www.patreon.com/posts/Image-Video-Comparison-Slider-App-133935178

🔗 Python、Git、CUDA、C++、FFMPEG、MSVC安装教程——ComfyUI所需 ⤵️

▶️ https://youtu.be/DrhUHnYfwC0

🔗 SECourses 官方 Discord 10500+ 会员 ⤵️

▶️ https://discord.com/servers/software-engineering-courses-secourses-772774097734074388

🔗 Stable Diffusion、FLUX、生成式 AI 教程和资源 GitHub ⤵️

▶️ https://github.com/FurkanGozukara/Stable-Diffusion

🔗 SECourses 官方 Reddit — 保持订阅以了解所有新闻及更多信息 ⤵️

▶️ https://www.reddit.com/r/SECourses/

我目前正在寻找使用 MultiTalk 实现视频到视频的唇形同步工作流程。

更新的工作流程

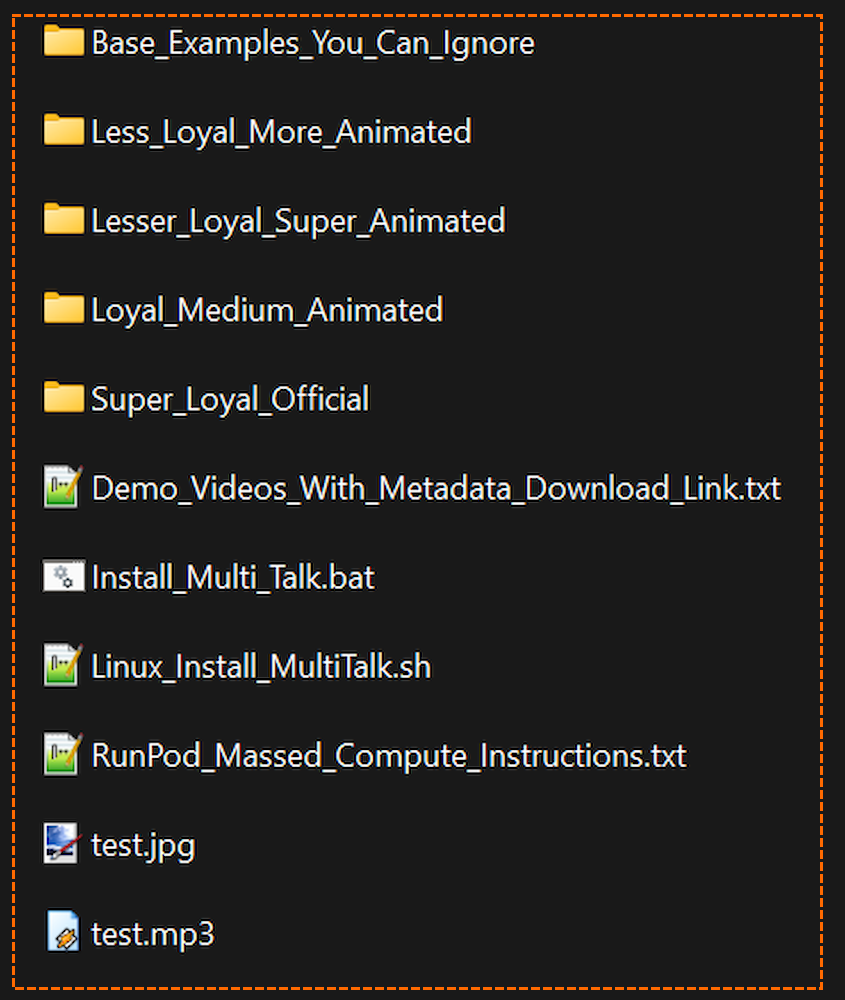

我们有 4 种不同级别的动画和忠实度

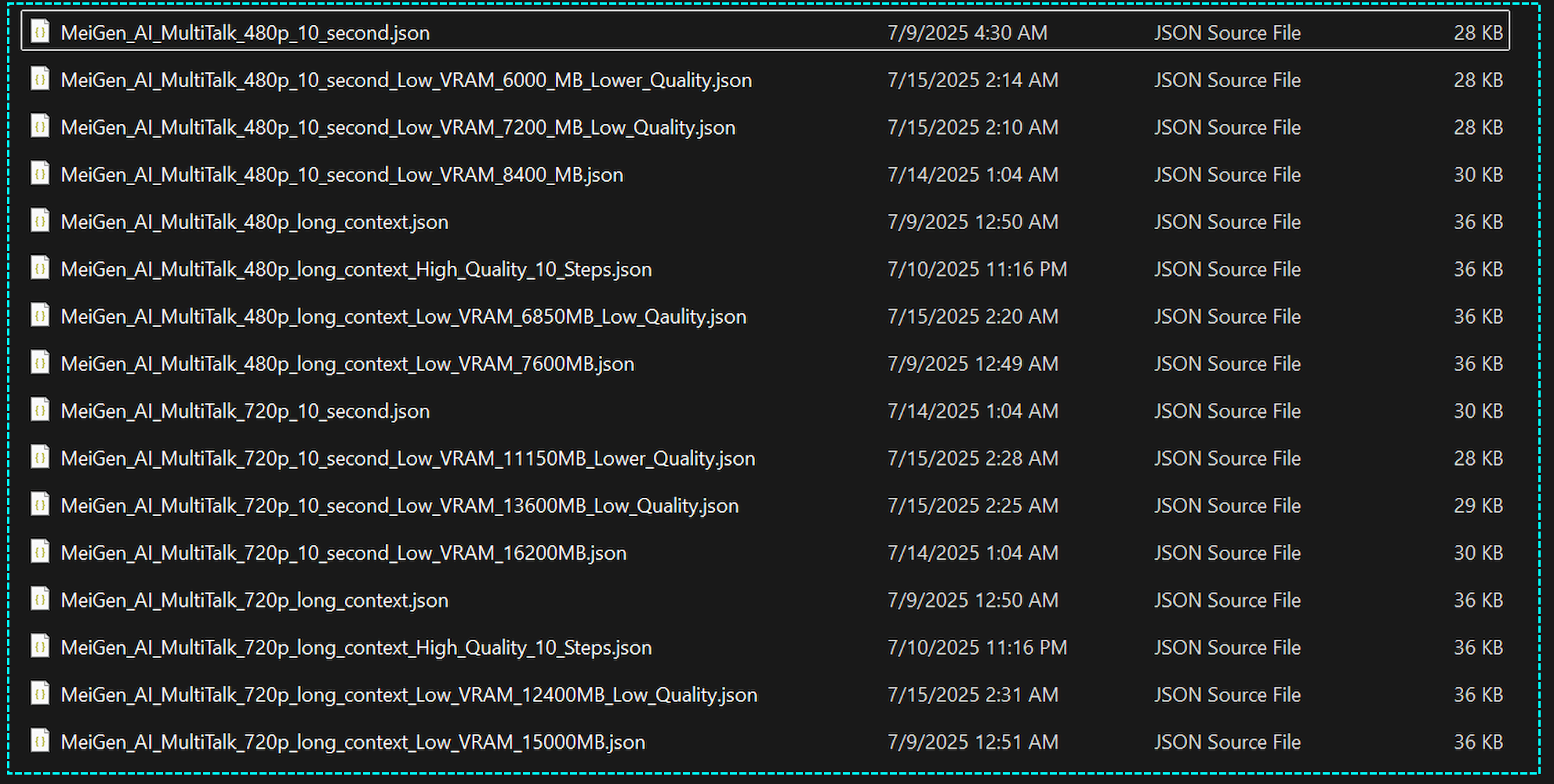

每个文件夹包含以下工作流程,包括针对低 VRAM GPU 的工作流程

视频章节 (MultiTalk 升级了 — 新工作流程带来比以前更好的动画效果 — 图像到视频):https://youtu.be/wgCtUeog41g

- 0:00 MultiTalk 教程简介

- 0:12 ComfyUI 和 MultiTalk 一键安装

- 0:29 MultiTalk 唱歌动画能力演示

- 0:58 VRAM 要求和工作流程优化

- 1:12 教程内容概览

- 1:35 改进和新工作流程选项

- 1:52 如何更新和使用新的 SwarmUI 和 MultiTalk 捆绑包

- 2:24 探索 ComfyUI 中的新工作流程预设

- 3:08 下载和使用带有嵌入式工作流程的演示视频

- 3:36 新视频和图像对比应用简介

- 4:00 如何使用图像对比工具

- 4:33 如何使用视频对比工具

- 5:24 高级升级和对比演示

- 6:11 总结和安装说明查找位置

视频章节 (MultiTalk 完整教程与一键安装程序 — 从静态图像制作说话和唱歌视频):https://youtu.be/8cMIwS9qo4M

通过使用 MeiGen MultiTalk,您可以根据给定的音频输入生成令人惊叹的、完全动画化的、逼真的视频。不仅可以说话,还可以实现身体动作的动画化。在这个视频中,我将向您展示如何在 Windows 上安装 ComfyUI 和 MultiTalk 捆绑包以及我们准备好的工作流程,只需一键操作。然后,我将展示如何非常轻松地从这些已安装的工作流程生成精彩视频。此外,我将展示我们最喜欢的云端私有 GPU 提供商 Massed Compute。如何在此处进行相同的安装并正确使用。最后,我还会展示 RunPod 上的所有操作。因此,无论您是 GPU 贫乏还是拥有良好的 GPU,本教程都涵盖了所有内容。

- 0:00 简介和 MultiTalk 演示

- 0:28 唱歌动画演示

- 0:57 教程结构概览 (Windows, Massed Compute, RunPod)

- 1:10 Windows — 步骤 1:下载并解压主 ZIP 文件

- 1:43 Windows — 前提条件 (Python, Git, CUDA, FFmpeg)

- 2:12 Windows — 如何执行全新安装 (删除 venv 和 custom_nodes)

- 2:42 Windows — 步骤 2:运行主 ComfyUI 安装程序脚本

- 4:24 Windows — 步骤 3:安装 MultiTalk 节点和依赖项

- 5:05 Windows — 步骤 4:使用统一下载器下载模型

- 6:18 Windows — 提示:在 ComfyUI 中设置自定义模型路径

- 7:18 Windows — 步骤 5:将 ComfyUI 更新到最新版本

- 7:39 Windows — 步骤 6:启动 ComfyUI

- 7:53 工作流程使用 — 使用 480p 10 秒工作流程

- 8:07 工作流程使用 — 配置基本参数 (图像、音频、分辨率)

- 8:55 工作流程使用 — 优化性能:“要交换的块”和 GPU 监控

- 9:49 工作流程使用 — 关键步骤:计算和设置帧数

- 10:48 工作流程使用 — 第一次生成:运行 480p 工作流程

- 12:01 工作流程使用 — 故障排除:如何修复“VRAM 不足”错误

- 13:51 工作流程使用 — 引入高质量长上下文工作流程 (720p)

- 14:09 工作流程使用 — 配置 720p 10 步高质量工作流程

- 16:18 工作流程使用 — 选择正确的模型 (GGUF) 和注意力机制

- 17:58 工作流程使用 — 通过更改种子提高结果

- 18:36 工作流程使用 — 并排比较:480p 与 720p 高质量

- 20:26 工作流程使用 — 幕后:介绍视频是如何制作的

- 21:32 第 2 部分:Massed Compute 云 GPU 教程

- 22:03 Massed Compute — 部署 GPU 实例 (H100)

- 23:40 Massed Compute — 设置 ThinLinc 客户端和共享文件夹

- 25:07 Massed Compute — 通过 ThinLinc 连接到远程机器

- 26:06 Massed Compute — 将文件传输到实例

- 27:04 Massed Compute — 步骤 1:安装 ComfyUI

- 27:39 Massed Compute — 步骤 2:安装 MultiTalk 节点

- 28:11 Massed Compute — 步骤 3:以超快速度下载模型

- 30:22 Massed Compute — 步骤 4:启动 ComfyUI 并首次生成

- 32:45 Massed Compute — 从本地浏览器访问远程 ComfyUI

- 35:07 Massed Compute — 将生成的视频下载到本地计算机

- 36:08 Massed Compute — 高级:与预安装的 SwarmUI 集成

- 38:06 Massed Compute — 关键:如何通过删除实例停止计费

- 38:33 第 3 部分:RunPod 云 GPU 教程

- 39:29 RunPod — 部署 Pod (模板、磁盘大小、端口)

- 40:39 RunPod — 通过 JupyterLab 连接并上传文件

- 41:11 RunPod — 步骤 1:安装 ComfyUI

- 42:32 RunPod — 步骤 2:下载模型

- 45:26 RunPod — 步骤 3:安装 MultiTalk 节点

- 45:52 RunPod — 步骤 4:启动 ComfyUI 并通过浏览器连接

- 47:50 RunPod — 在 GPU 上运行高质量工作流程

- 51:11 RunPod — 理解高 VRAM GPU 上的生成过程

- 52:34 RunPod — 将最终视频下载到本地机器

- 53:04 RunPod — 如何停止和重启 Pod 以节省成本

MultiTalk:用唇形同步让虚拟形象栩栩如生

MultiTalk 是 WAN 2.1 的补充,它是一个专门的模型,用于从图像和文本或音频输入生成会说话的虚拟形象。该模型可在 fal.ai 等平台使用,提供多种变体,如用于单个虚拟形象的单文本模式、用于对话的多文本模式,以及基于音频的同步模式。通过将文本转换为语音并确保自然的唇部动作,MultiTalk 解决了 AI 视频中的一个关键挑战:逼真的对话传递。

当 MultiTalk 与 ComfyUI 工作流程中的 WAN 2.1 配对时,MultiTalk 可实现 Veo 3 级别的唇形同步,从而使本地 AI 视频项目具有增强的表现力。这种集成因解决了困扰早期模型的唇形同步问题而受到称赞,允许创作者从静态肖像制作动态的说话人视频。例如,工作流程可在几分钟内将三张图像转换为视频,非常适合动画或虚拟网红。