推动开源大型语言模型在医疗健康领域的应用

推出OpenBioLLM-70B:一款最先进的开源生物医学大型语言模型

OpenBioLLM-70B是一款专门为生物医学领域设计的高级开源语言模型。由Saama AI Labs开发,该模型利用尖端技术,在广泛的生物医学任务上实现了最先进的性能。

🏥 生物医学专业化:OpenBioLLM-70B针对医疗和生命科学领域独特的语言和知识需求进行了定制。它在庞大的高质量生物医学数据语料库上进行了微调,使其能够以领域特定的准确性和流畅性理解和生成文本。

🎓 卓越性能:OpenBioLLM-70B拥有700亿参数,其性能超越了同等规模的其他开源生物医学语言模型。在生物医学基准测试中,它还显示出优于更大的专有和开源模型(如GPT-4、Gemini、Meditron-70B、Med-PaLM-1和Med-PaLM-2)的结果。

🧠 先进的训练技术:OpenBioLLM-70B建立在Meta-Llama-3-70B-Instruct和Meta-Llama-3-70B-Instruct模型强大基础之上。它整合了DPO数据集和微调方案,以及定制的多样化医疗指令数据集。训练流程的关键组件包括:

- 策略优化:直接偏好优化:你的语言模型实际上是一个奖励模型(DPO)

- 微调数据集:定制的医疗指令数据集(我们计划在即将发布的论文中发布样本训练数据集;请保持关注)

这些尖端技术的结合使得OpenBioLLM-70B能够与生物医学应用的关键能力和偏好保持一致。

⚙️ 发布详情

- 模型大小:700亿参数

- 量化:提供优化量化版本此处

- 语言(NLP): 英语

- 开发者:Ankit Pal (Aaditya Ura),来自Saama AI Labs

- 许可证: Meta-Llama许可证

- 微调自模型: Meta-Llama-3-70B-Instruct

- 更多信息资源

- 论文:即将发布

该模型可根据需要针对更专业的任务和数据集进行微调。

OpenBioLLM-70B代表着在医疗生物医学领域普及先进语言AI方面迈出了重要一步。通过利用Llama-3等领先开源项目中的最先进架构和训练技术,我们创造了一个强大的工具,以加速医疗保健和生命科学领域的创新和发现。

我们很高兴能与世界各地的研究人员和开发人员分享OpenBioLLM-70B。

与transformers一起使用

重要提示:请务必使用Llama-3 instruct版本提供的确切聊天模板。否则,性能将会下降。在极少数情况下,模型输出可能会过于冗长。请考虑将温度设置为0以减少这种情况发生。

请参阅以下代码片段,了解与Transformers的用法

import transformers

import torch

model_id = "aaditya/OpenBioLLM-Llama3-70B"

pipeline = transformers.pipeline(

"text-generation",

model=model_id,

model_kwargs={"torch_dtype": torch.bfloat16},

device="auto",

)

messages = [

{"role": "system", "content": "You are an expert and experienced from the healthcare and biomedical domain with extensive medical knowledge and practical experience. Your name is OpenBioLLM, and you were developed by Saama AI Labs. who's willing to help answer the user's query with explanation. In your explanation, leverage your deep medical expertise such as relevant anatomical structures, physiological processes, diagnostic criteria, treatment guidelines, or other pertinent medical concepts. Use precise medical terminology while still aiming to make the explanation clear and accessible to a general audience."},

{"role": "user", "content": "How can i split a 3mg or 4mg waefin pill so i can get a 2.5mg pill?"},

]

prompt = pipeline.tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

terminators = [

pipeline.tokenizer.eos_token_id,

pipeline.tokenizer.convert_tokens_to_ids("<|eot_id|>")

]

outputs = pipeline(

prompt,

max_new_tokens=256,

eos_token_id=terminators,

do_sample=True,

temperature=0.0,

top_p=0.9,

)

print(outputs[0]["generated_text"][len(prompt):])

训练流程

训练超参数

点击查看详情

- 学习率:0.0002

- 学习率调度器:cosine

- 训练批量大小:12

- 评估批量大小:8

- GPU:H100 80GB SXM5

- 设备数量:8

- 优化器:adamw_bnb_8bit

- 学习率调度器预热步数:100

- epoch数量:4

Peft超参数

点击查看详情

- 适配器:qlora

- lora_r:128

- lora_alpha:256

- lora_dropout:0.05

- lora_target_linear:true

-lora_target_modules

- q_proj

- v_proj

- k_proj

- o_proj

- gate_proj

- down_proj

- up_proj

训练结果

框架版本

- Transformers 4.39.3

- Pytorch 2.1.2+cu121

- Datasets 2.18.0

- Tokenizers 0.15.1

- Axolotl

- Lm harness 用于评估

基准测试结果

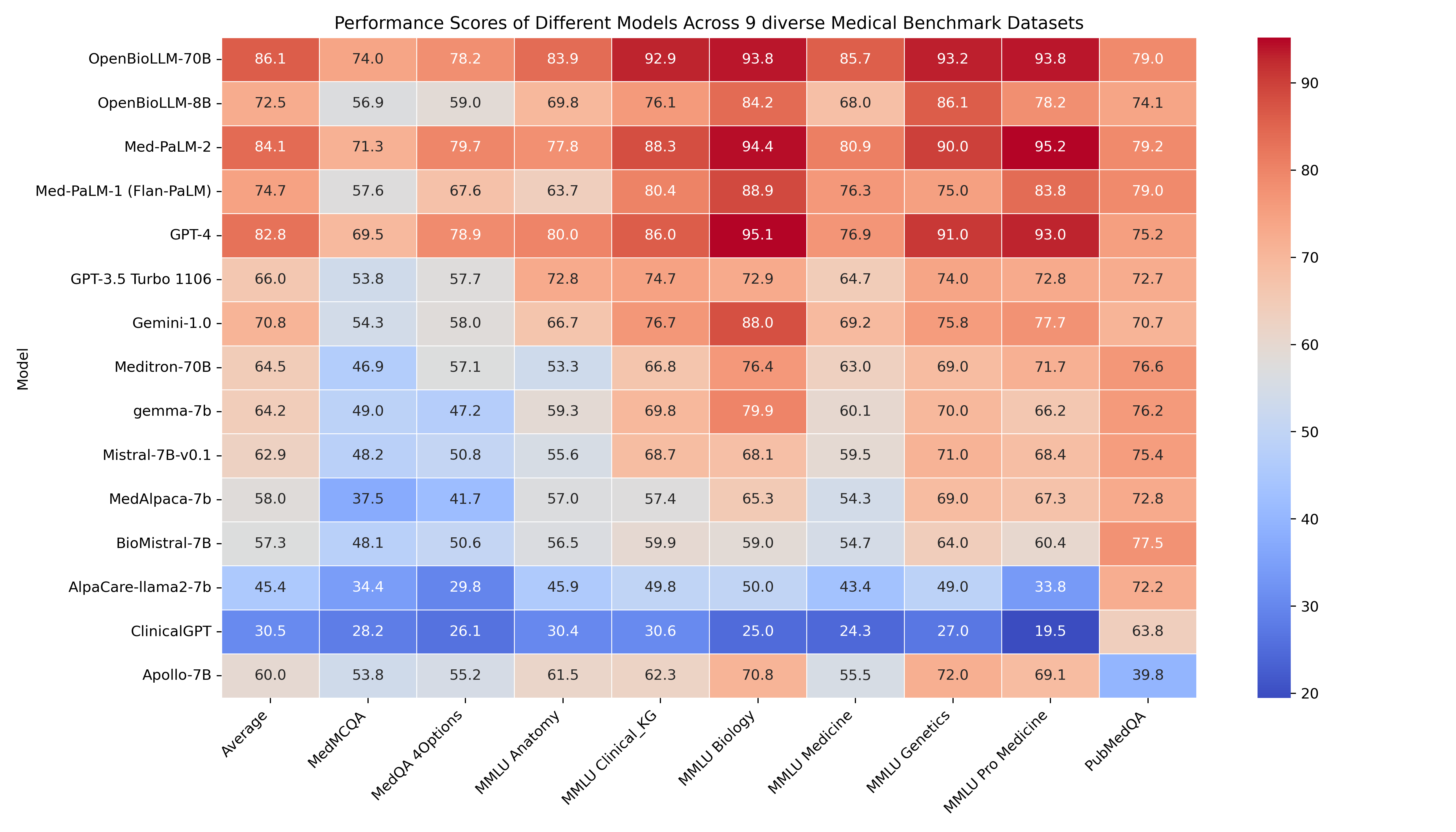

🔥 OpenBioLLM-70B在9个不同的生物医学数据集上展现出优于GPT-4、Gemini、Meditron-70B、Med-PaLM-1和Med-PaLM-2等大型模型的卓越性能,平均得分高达86.06%,尽管参数数量显著较小,仍取得了最先进的结果。该模型在临床知识图谱(Clinical KG)、医学遗传学(Medical Genetics)和PubMedQA等领域特定任务上的出色表现,突显了其有效捕获和应用生物医学知识的能力。

🚨 GPT-4、Med-PaLM-1和Med-PaLM-2的结果来自其官方论文。由于Med-PaLM未提供零样本准确率,我们使用其论文中的5样本准确率进行比较。所有呈现的结果均在零样本设置下,除了Med-PaLM-2和Med-PaLM-1使用5样本准确率。

| 临床知识图谱 | 医学遗传学 | 解剖学 | 专业医学 | 大学生物学 | 大学医学 | MedQA 4个选项 | PubMedQA | MedMCQA | 平均 | |

|---|---|---|---|---|---|---|---|---|---|---|

| OpenBioLLM-70B | 92.93 | 93.197 | 83.904 | 93.75 | 93.827 | 85.749 | 78.162 | 78.97 | 74.014 | 86.05588 |

| Med-PaLM-2 (5样本) | 88.3 | 90 | 77.8 | 95.2 | 94.4 | 80.9 | 79.7 | 79.2 | 71.3 | 84.08 |

| GPT-4 | 86.04 | 91 | 80 | 93.01 | 95.14 | 76.88 | 78.87 | 75.2 | 69.52 | 82.85 |

| Med-PaLM-1 (Flan-PaLM, 5样本) | 80.4 | 75 | 63.7 | 83.8 | 88.9 | 76.3 | 67.6 | 79 | 57.6 | 74.7 |

| OpenBioLLM-8B | 76.101 | 86.1 | 69.829 | 78.21 | 84.213 | 68.042 | 58.993 | 74.12 | 56.913 | 72.502 |

| Gemini-1.0 | 76.7 | 75.8 | 66.7 | 77.7 | 88 | 69.2 | 58 | 70.7 | 54.3 | 70.79 |

| GPT-3.5 Turbo 1106 | 74.71 | 74 | 72.79 | 72.79 | 72.91 | 64.73 | 57.71 | 72.66 | 53.79 | 66 |

| Meditron-70B | 66.79 | 69 | 53.33 | 71.69 | 76.38 | 63 | 57.1 | 76.6 | 46.85 | 64.52 |

| gemma-7b | 69.81 | 70 | 59.26 | 66.18 | 79.86 | 60.12 | 47.21 | 76.2 | 48.96 | 64.18 |

| Mistral-7B-v0.1 | 68.68 | 71 | 55.56 | 68.38 | 68.06 | 59.54 | 50.82 | 75.4 | 48.2 | 62.85 |

| Apollo-7B | 62.26 | 72 | 61.48 | 69.12 | 70.83 | 55.49 | 55.22 | 39.8 | 53.77 | 60 |

| MedAlpaca-7b | 57.36 | 69 | 57.04 | 67.28 | 65.28 | 54.34 | 41.71 | 72.8 | 37.51 | 58.03 |

| BioMistral-7B | 59.9 | 64 | 56.5 | 60.4 | 59 | 54.7 | 50.6 | 77.5 | 48.1 | 57.3 |

| AlpaCare-llama2-7b | 49.81 | 49 | 45.92 | 33.82 | 50 | 43.35 | 29.77 | 72.2 | 34.42 | 45.36 |

| ClinicalGPT | 30.56 | 27 | 30.37 | 19.48 | 25 | 24.27 | 26.08 | 63.8 | 28.18 | 30.52 |

医学分科详细准确性

用例与示例

🚨 **以下结果来自OpenBioLLM-70B的量化版本

总结临床笔记

OpenBioLLM-70B可以高效分析和总结复杂的临床笔记、电子健康记录数据和出院总结,提取关键信息并生成简洁、结构化的摘要

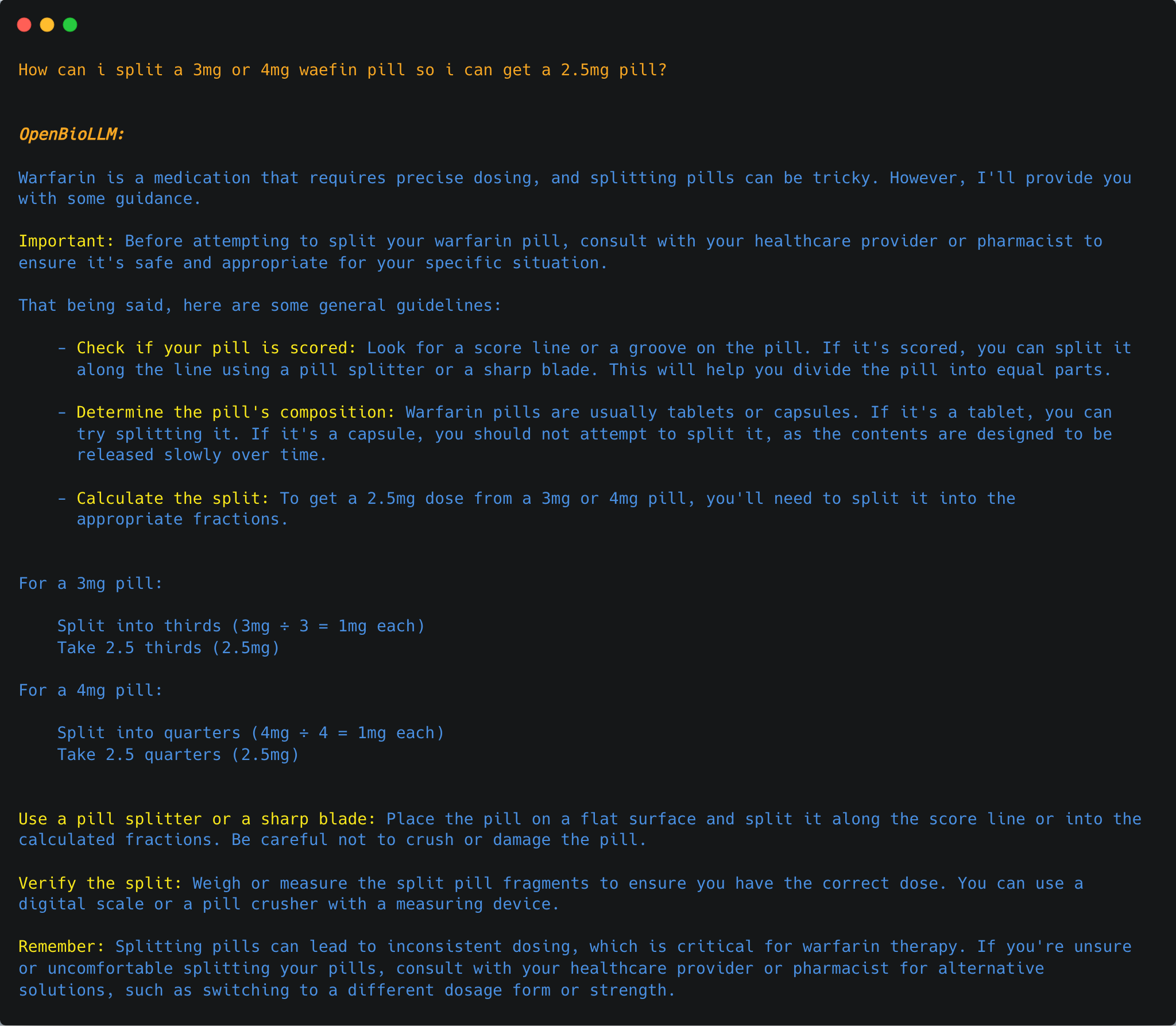

回答医学问题

OpenBioLLM-70B可以回答广泛的医学问题。

临床实体识别

OpenBioLLM-70B能够通过从非结构化临床文本中识别和提取疾病、症状、药物、程序和解剖结构等关键医学概念,执行高级临床实体识别。通过其对医学术语和上下文的深入理解,该模型可以准确标注和分类临床实体,从而更有效地从电子健康记录、研究文章和其他生物医学文本源中进行信息检索、数据分析和知识发现。这项能力可以支持各种下游应用,例如临床决策支持、药物警戒和医学研究。

生物标记物提取

分类

OpenBioLLM-70B可以执行各种生物医学分类任务,例如疾病预测、情感分析、医疗文档分类

去识别化

OpenBioLLM-70B可以检测并移除医疗记录中的个人身份信息(PII),确保患者隐私并符合HIPAA等数据保护法规。

忠告!

尽管OpenBioLLM-70B利用高质量数据源,但其输出仍可能包含不准确、偏见或不一致之处,如果未经过进一步测试和完善,可能会导致医疗决策风险。该模型的性能尚未在随机对照试验或真实医疗环境中进行严格评估。

因此,我们强烈建议目前不要将OpenBioLLM-70B用于任何直接的患者护理、临床决策支持或其他专业医疗用途。其使用应限于由了解其局限性的合格个人进行的研究、开发和探索性应用。OpenBioLLM-70B仅作为协助医疗专业人员的研究工具,绝不应被视为合格医生的专业判断和专业知识的替代品。

将OpenBioLLM-70B适当调整和验证用于特定医疗用途,可能需要大量额外工作,包括:

- 在相关临床场景中进行彻底的测试和评估

- 与循证指南和最佳实践保持一致

- 减轻潜在偏差和故障模式

- 与人工监督和解释相结合

- 遵守监管和道德标准

如有个人医疗需求,请务必咨询合格的医疗保健提供者。

引用

如果您在工作中发现OpenBioLLM-70B和8B有用,请按以下方式引用该模型:

@misc{OpenBioLLMs,

author = {Ankit Pal, Malaikannan Sankarasubbu},

title = {OpenBioLLMs: Advancing Open-Source Large Language Models for Healthcare and Life Sciences},

year = {2024},

publisher = {Hugging Face},

journal = {Hugging Face repository},

howpublished = {\url{https://huggingface.co/aaditya/OpenBioLLM-Llama3-70B}}

}

相关论文正在撰写中,即将发布。

💌 联系方式

期待您的来信,并与您在这个激动人心的项目上合作!

贡献者

- Ankit Pal (Aaditya Ura) [aadityaura at gmail dot com]

- Saama AI Labs

- 注:我正在寻找带薪博士机会,尤其是符合我负责任生成式AI、多模态大型语言模型、几何深度学习和医疗AI技能组合的职位。

参考文献

我们感谢Meta团队的卓越模型!

结果来源

- [1] GPT-4 [GPT-4在医学挑战问题上的能力] (https://arxiv.org/abs/2303.13375)

- [2] Med-PaLM-1 大型语言模型编码临床知识

- [3] Med-PaLM-2 用大型语言模型实现专家级医学问答

- [4] Gemini-1.0 Gemini进入医学院