Prompt Caching 会是新的 RAG 吗?

社区文章 发布于 2024 年 8 月 21 日

最近,Claude 的开发公司 Anthropic 宣布了一项名为 Prompt Caching 的出色新功能。这项突破性的发展使得处理冗长文档的成本比以往任何时候都低,并且有可能彻底改变我们处理 AI 对话中大量静态信息的方式!

让我们深入探讨这对 AI 应用程序的激动人心之处。

什么是 Prompt Caching?

Prompt Caching 涉及存储系统提示——即对话的静态部分。这个系统提示可以包含大量内容,例如整本书、长篇研究论文或大型代码库。其工作原理如下:

- 系统提示在首次请求时进行缓存,产生一次性成本。

- 后续的用户查询仅针对这个缓存的上下文处理动态的用户输入。

- 这种方法大大加快了交互速度,并降低了重复查询的成本。

Prompt Caching 的要点

- 系统提示与用户输入:系统提示(静态、缓存)与用户输入(动态、每次查询不同)是分开的。

- 初始缓存成本:首次缓存系统提示时,其成本比标准输入定价高约 25%。

- 后续查询节省:缓存后,针对缓存上下文处理新查询的成本仅为通常输入定价的约 10%。

- 时间限制:缓存有效期为 5 分钟。在此之后,如果想继续使用系统提示,需要重新缓存。

示例

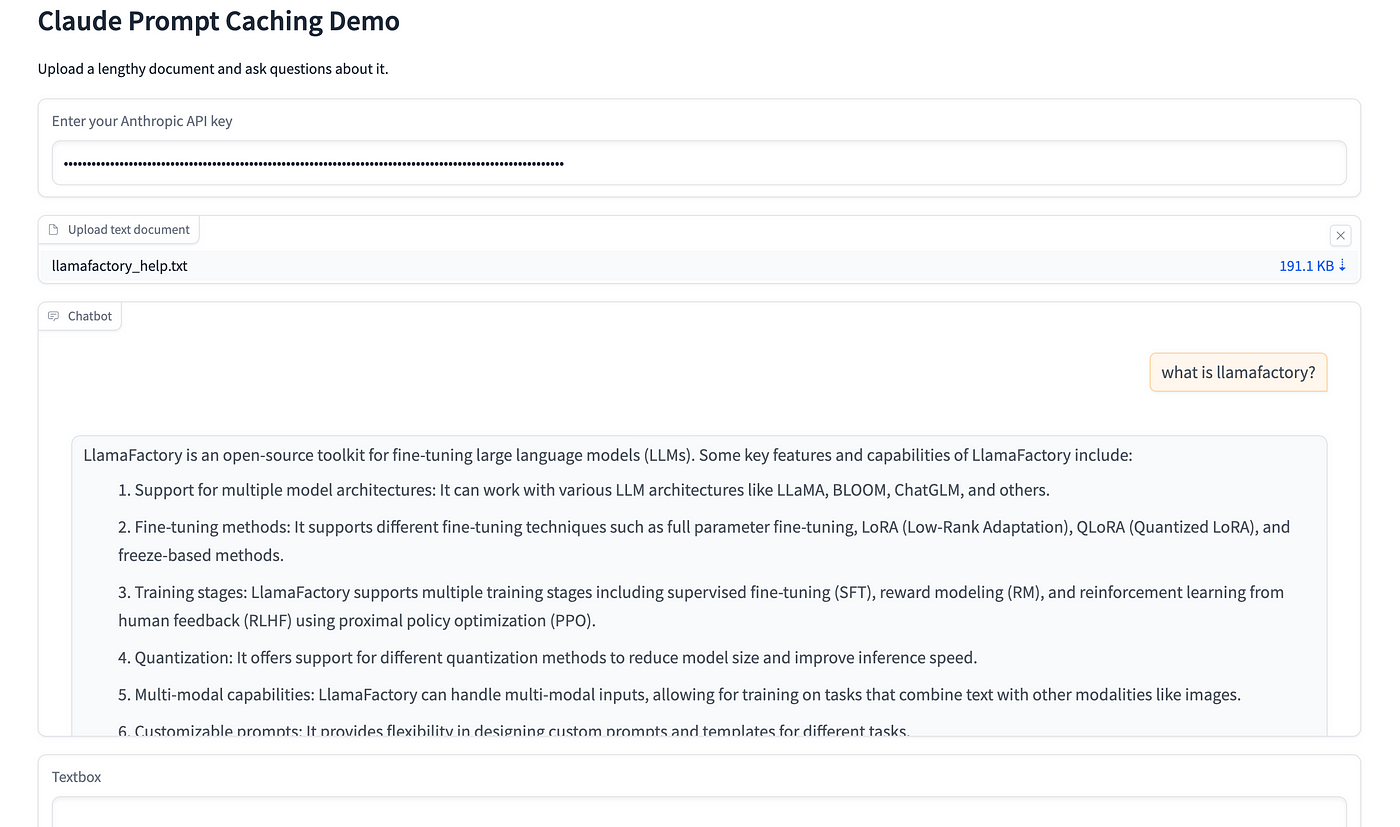

我在 HuggingFace 上用 一个简单的聊天界面 制作了一个 Gradio 应用程序,该应用程序使用了新的缓存 API。

在此示例中,我从 Github 存储库 (LLAMFactory) 上传了一份综合手册,并提出了一些问题。

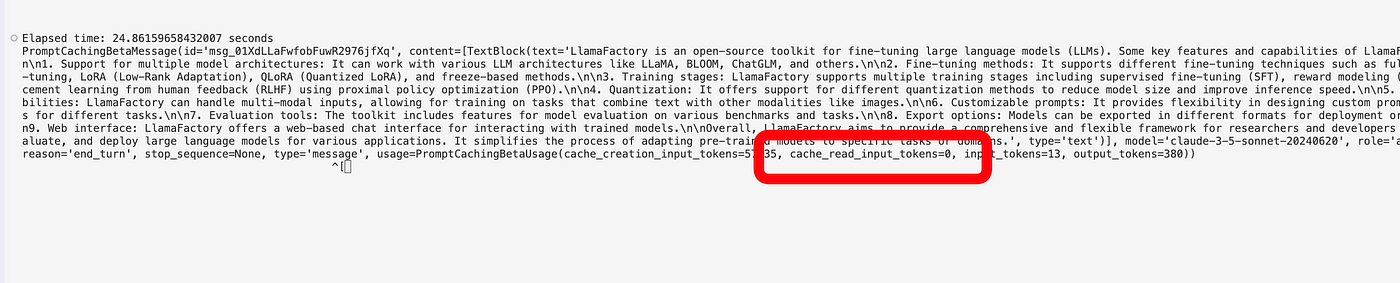

系统提示在第一个问题之后被缓存,因此缓存仍为零。

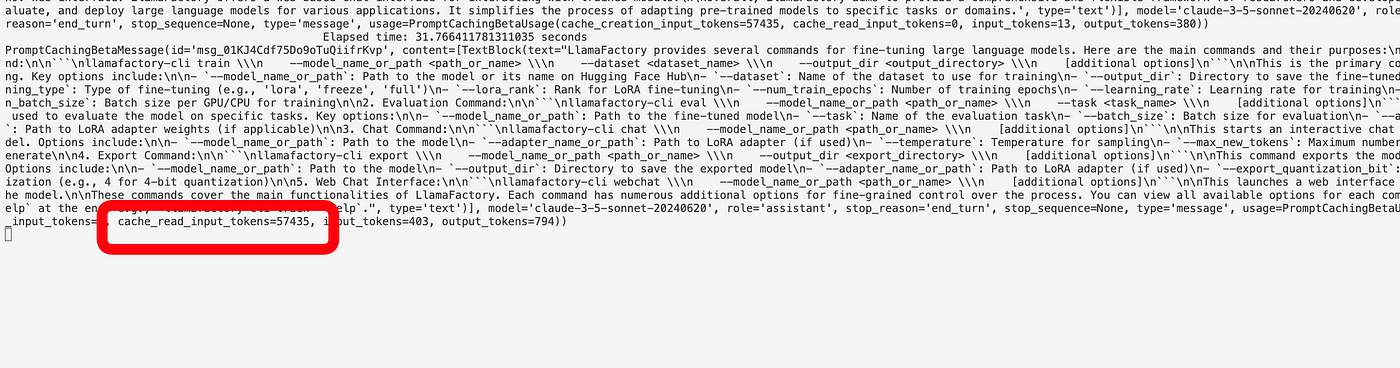

之后,使用缓存版本,响应速度更快,成本更低(输入 token 的成本是通常成本的 10%)。

Prompt Caching 的可能用例

- 文档分析:缓存整本书或长文档。用户可以对内容提出多个问题,而无需每次都重新处理整个文本。

- 代码审查:在缓存中存储大型代码库。开发人员可以快速且廉价地查询代码的不同部分。

- 研究辅助:缓存全面的研究论文或数据集。研究人员可以探索数据的各个方面,而无需重复处理成本。

- 法律文档处理:存储整个法典或判例法数据库。律师可以以通常成本的一小部分快速查询相关信息。

- 教育工具:缓存教科书或课程材料。学生可以就内容提出大量问题,使互动学习更加可行且经济实惠。

请注意,Prompt Caching 仍有一些局限性。缓存仅在 5 分钟内有效,并且尚未兼容所有 Claude 模型。

结论

Prompt Caching 是使 AI 交互更高效、更具成本效益的重要一步,尤其是在处理大型静态数据集的应用程序中。通过大幅缩短后续查询的时间和成本,它为 AI 驱动的分析、学习和跨行业信息处理开辟了新的可能性。