LLM 代币生成中的巨大时间和金钱浪费

如果你使用过 GPT 以及 Claude 或 Mistral 等其他 LLM,你可能已经注意到生产力大幅提升。然而,你使用生成式 AI 越多,就越会遇到帕累托原则——即画龙点睛比创建主要部分更难。

当你的内容(例如代码或文本)增长时,这个问题会更加明显,即使是微小的改动也会让人感到乏味、低效,并在时间和资源方面付出高昂的代价(延迟)。我多年来一直在研究这种模式,尤其是在代码生成方面,我想分享我的观察结果和解决这些挑战的潜在方案,帮助你以更低的成本、更少的精力和更少的延迟创造出色的作品。

听起来很抽象?我们举个例子。

I need to create a landing page for my new product/service. The landing page should be designed to attract and convert visitors by clearly communicating the value proposition, features, and benefits.....

你检查了一下,很喜欢,但接着你想要做一点点改动。

于是,你要求 GPT 进行修改。

... the hero section should ...

**几秒钟**(或几分钟)后,取决于原始文档的长度,它会重新生成整个文档。

它做了一些改动,但不是你所期望的。

于是,你再次提出请求。

... make some adjustments. The hero section is too cluttered.

几秒钟(或几分钟)后,取决于修改后的文档长度……然后,它又重新生成了整个文档。

它变得更好了,但仍然不是你所期望的。

周而复始。

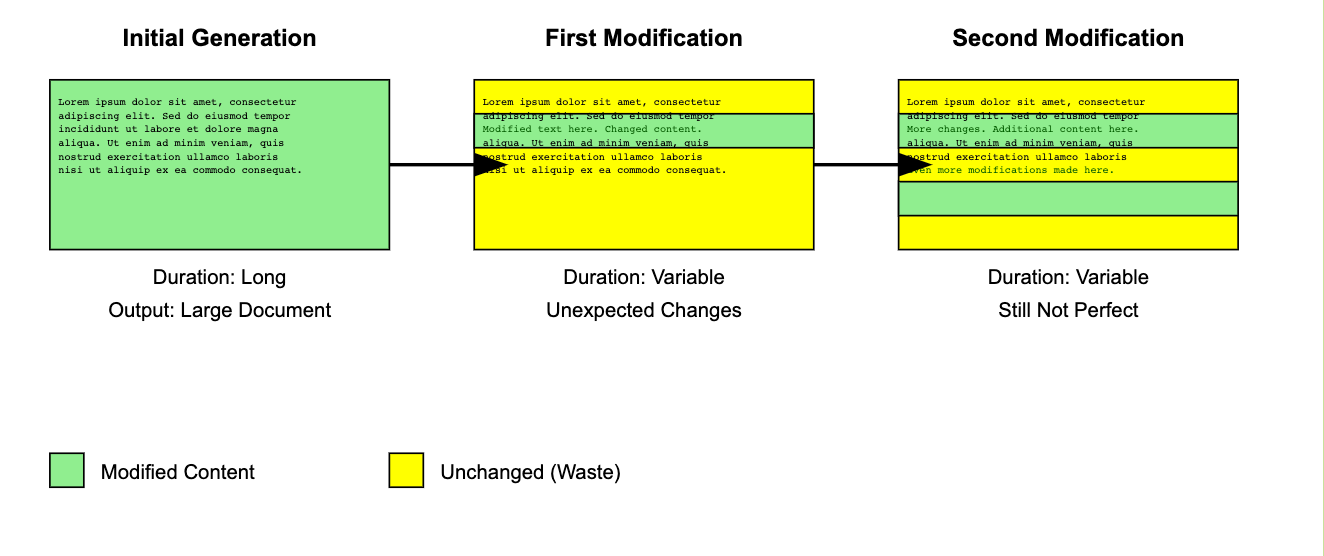

让我们用图解说明这种行为(感谢 Claude:)

文档越大,这项工作就越繁琐、越耗时、越昂贵。

这可能会非常令人沮丧,尤其是在对最初的生成抱有很大希望并感到兴奋之后。

我们在许多用例中都会遇到这些行为和挑战。

让我们快速看一些例子(非常简短)

- 总结:大背景和一段摘要。

☞ 如果你有好的提示和好的模型,效果会很好 - 回答长文档中的问题

☞ 效果很好,即使对于长文档也是如此,尤其是在有缓存的情况下。 - ****初始代码生成(全新开发)****,例如一个 hello world 应用程序

☞ 如果模型良好,通常简单快捷。 - ****修改生成的代码(初始生成后)****

☞ 很大程度上取决于底层模型的推理能力、文件大小以及你想要进行的更改。 - ****编辑现有文档、合同等****

☞ 取决于更改的数量、更改的长度以及它们如何分布(在一个段落中还是跨多个段落等)。

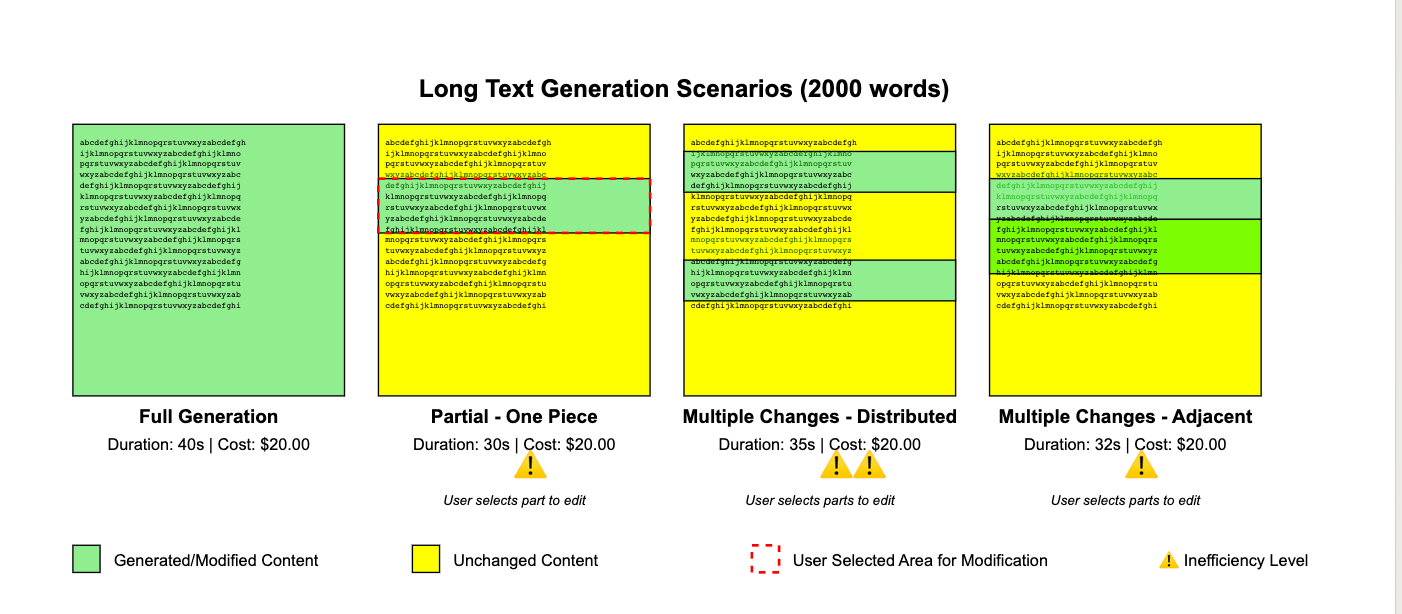

我将以更抽象的方式来看待它

如果我们从高层次来看这些场景,我们会发现一些模式,或者说一些高层次的场景。

长文本的初始生成

持续时间和令牌数量在很大程度上取决于文本的长度、模型速度和成本。在这个领域,业界几乎每天都在取得进展。

****编辑长文本中彼此靠近的部分:****

在许多编辑器中,例如 Canvas 或 Artifacts,你可以选择要编辑区域的部分,从而减少更改量并避免生成大量未修改的文本。

编辑短文本的几个部分

当我们处理短文本时,更改是否分散并不重要,整个生成不会花费太多时间,因此对于大多数快速且廉价的模型来说,这不应该是一个问题。