弥合视觉鸿沟:使用知识适应性字幕微调多模态模型

概述

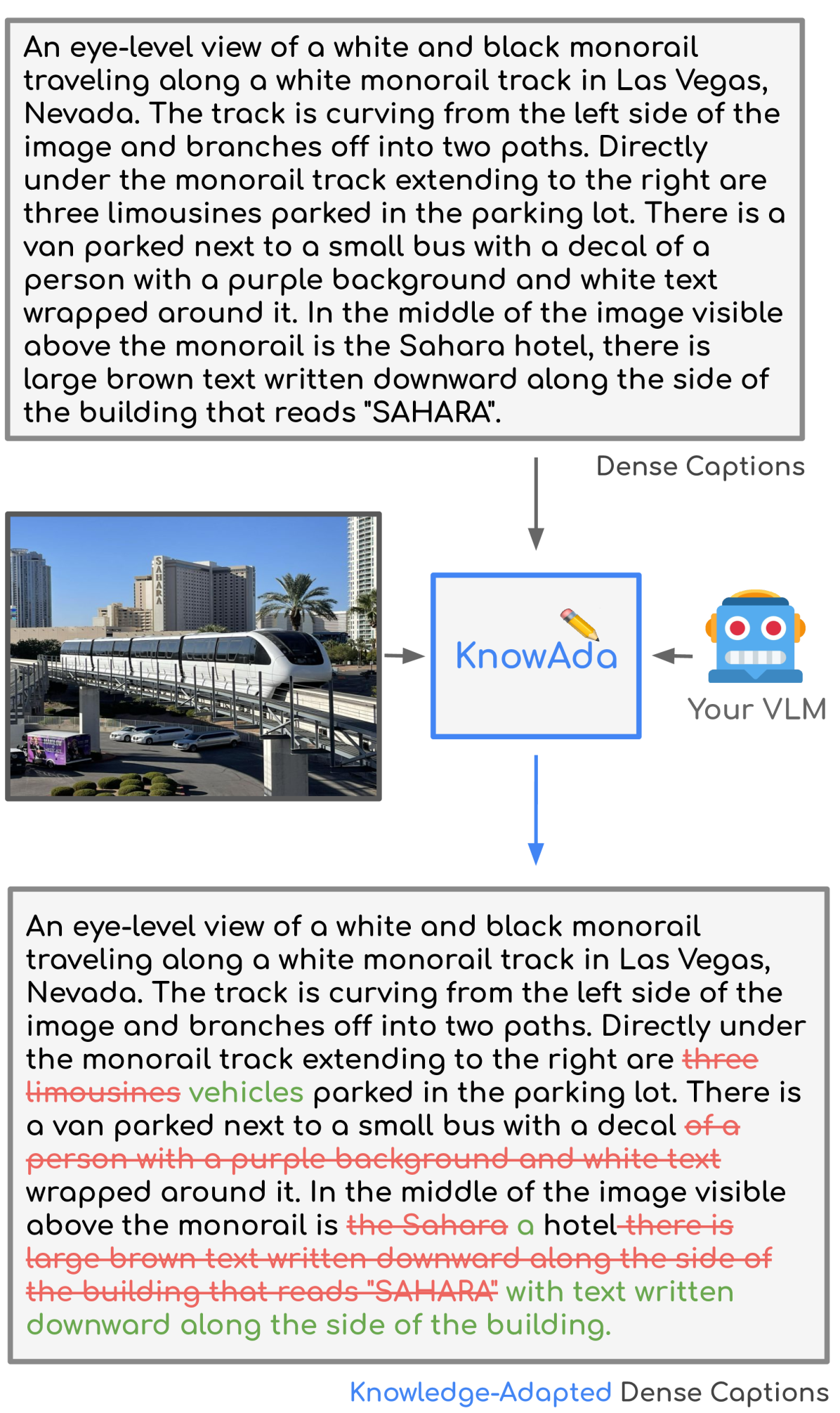

- 介绍 KnowAda,一种用于多模态模型的新型微调方法。

- 解决了现有模型难以进行复杂视觉推理的“视觉鸿沟”问题。

- 利用经过外部知识丰富后的知识适应性字幕。

- 展示了在视觉问答 (VQA) 任务中改进的性能。

- 有望增强多模态模型的推理能力。

通俗易懂的解释

KnowAda 弥合了视觉信息和模型理解之间的鸿沟,提升了复杂视觉推理任务的性能。

许多当前的多模态模型,例如 “文化包容性考量下的视觉-语言模型” 中探讨的模型,在需要深度视觉理解的任务中表现不佳。它们通常无法理解图像的细微之处以及不同元素之间的关系。这造成了“视觉鸿沟”,限制了它们在视觉问答 (VQA) 等任务中的有效性。现有方法尽管有所改进,但在问题需要理解图像中复杂的内在关系或不易察觉的背景知识时,仍显不足。这种鸿沟凸显了需要创新方法来增强模型对视觉内容的理解。在 “检测和缓解大型视觉-语言模型中的幻觉” 方面,通用语言模型也发现了类似问题,这凸显了人工智能在事实准确性和连贯性方面的更广泛挑战。

KnowAda 通过为模型配备“知识适应性字幕”来解决这一视觉鸿沟。这些字幕不再仅仅依赖基本的图像描述,而是整合了与场景相关的外部知识。想象一张历史地标的图片。常规字幕可能只说“一座建筑物”。而知识适应性字幕会提供上下文,例如“埃菲尔铁塔,由古斯塔夫·埃菲尔于 1889 年建造”。这些额外信息使模型能够更有效地进行推理。通过提供上下文和补充背景细节,KnowAda 帮助模型弥合视觉鸿沟并准确回答复杂问题,就像 “定向领域微调:定制单独的模态” 专门针对特定领域定制模型一样。这种方法类似于在提问前向某人提供更多细节,从而获得更明智、更准确的答案,这与研究人员正在探索 “更多细节是否总是会引入更多幻觉?” 的方式非常相似。

主要发现

该论文表明,使用 知识适应性字幕 对多模态模型进行微调,能显著提高 VQA 任务的性能。增强后的字幕为模型提供了对视觉内容更丰富的理解,使其能够回答需要更深入推理的问题。

技术解释

KnowAda 首先探测现有的视觉-语言模型 (VLM),以识别其知识不足的领域。这种分析为创建知识适应性字幕提供了依据。字幕是通过将初始描述与以问题为指导检索到的相关外部知识相结合而生成的。此过程确保添加的信息专门用于增强模型回答复杂问题的能力。然后,使用这些丰富的字幕对 VLM 进行微调,使其能够将提供的知识整合到对图像的理解中。架构本身没有修改;改进来自于用于微调的丰富数据。

这种方法可以提高视觉问答的性能。模型现在可以利用知识适应性字幕提供的额外上下文,更有效地推理图像并回答更复杂的问题。这对该领域具有重要意义。这项工作展示了一种有前景的方法来弥合当前多模态模型中的视觉鸿沟,为人工智能中更复杂的视觉推理能力铺平了道路。

批判性分析

虽然 KnowAda 前景光明,但也有一些局限性。该方法的有效性依赖于所用外部知识的质量和相关性。不准确或不相关的知识可能会对性能产生负面影响。此外,生成知识适应性字幕的过程可能计算成本高昂,特别是对于大型数据集。 弥合视觉鸿沟:多模态模型的微调 将受益于未来研究探索更有效的方式来生成和整合外部知识。还需要进一步研究以了解 KnowAda 如何推广到 VQA 之外的其他视觉推理任务。此外,还值得探讨这种方法如何与旨在缓解幻觉的技术(例如 “检测和缓解大型视觉-语言模型中的幻觉” 中描述的技术)相互作用。

结论

KnowAda 为增强多模态模型的视觉推理能力提供了一个引人注目的策略。通过使用知识适应性字幕,它解决了限制当前模型的视觉鸿沟。这种方法提高了复杂 VQA 任务的性能,并为未来的研究开辟了激动人心的途径。其潜在影响超越了研究领域,有望在各种应用中实现更智能、更有能力的人工智能系统。这可能在图像搜索、内容理解和人机交互等领域带来改进。对高效知识整合和推广到其他任务的进一步研究对于释放这种方法的全部潜力至关重要,正如在多模态模型开发的更广泛背景下所见,例如 “文化包容性考量下的视觉-语言模型”。