Gemma 3 新手指南:谷歌开源人工智能模型介绍

各位 AI 爱好者,欢迎回来!今天,我们将探索 Google 的新 Gemma 3 AI——一个强大的开源模型,旨在单个 GPU 上运行。如果你听说过 Gemma 3 是“可以在单个 GPU 上使用的最强大的模型”,那么你来对地方了。

关于 Gemma 3

什么是 Google Gemma 3?

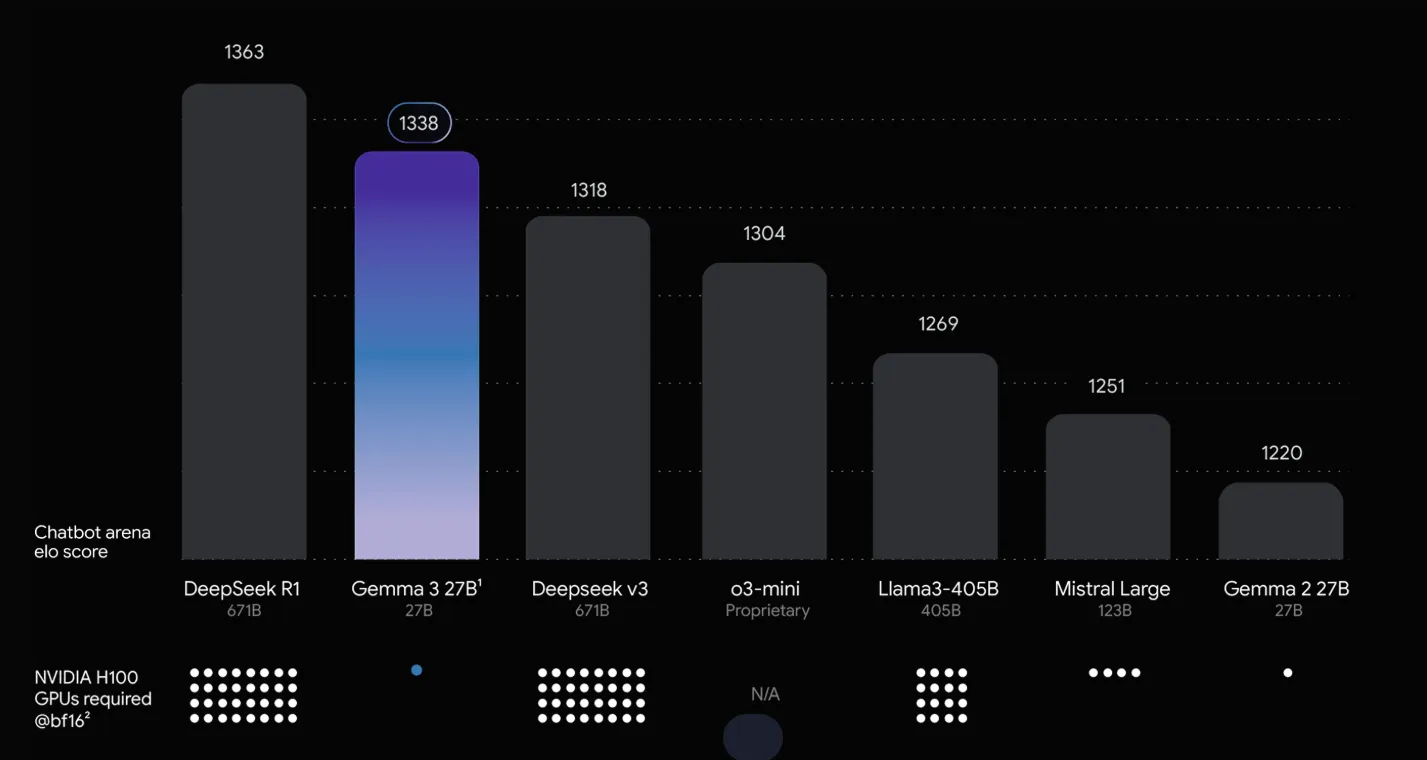

你可以将 Gemma 3 视为 Google 对 GPT 风格模型的答案,但它是**开源**的,并且经过优化,可以在任何地方运行——你的笔记本电脑、单个服务器甚至高端手机!它是 Google Gemma 系列 AI 模型中的最新成员。Google 将其庞大 Gemini 模型的核心技术提炼到 Gemma 3 中。结果:一套你可以实际下载和运行的模型。Gemma 3 旨在实现可访问性,同时不牺牲性能。事实上,参数量最大的 Gemma 3 模型(270 亿参数)在质量上跻身顶级开源 AI 模型之列。

了解 Gemma 3 模型

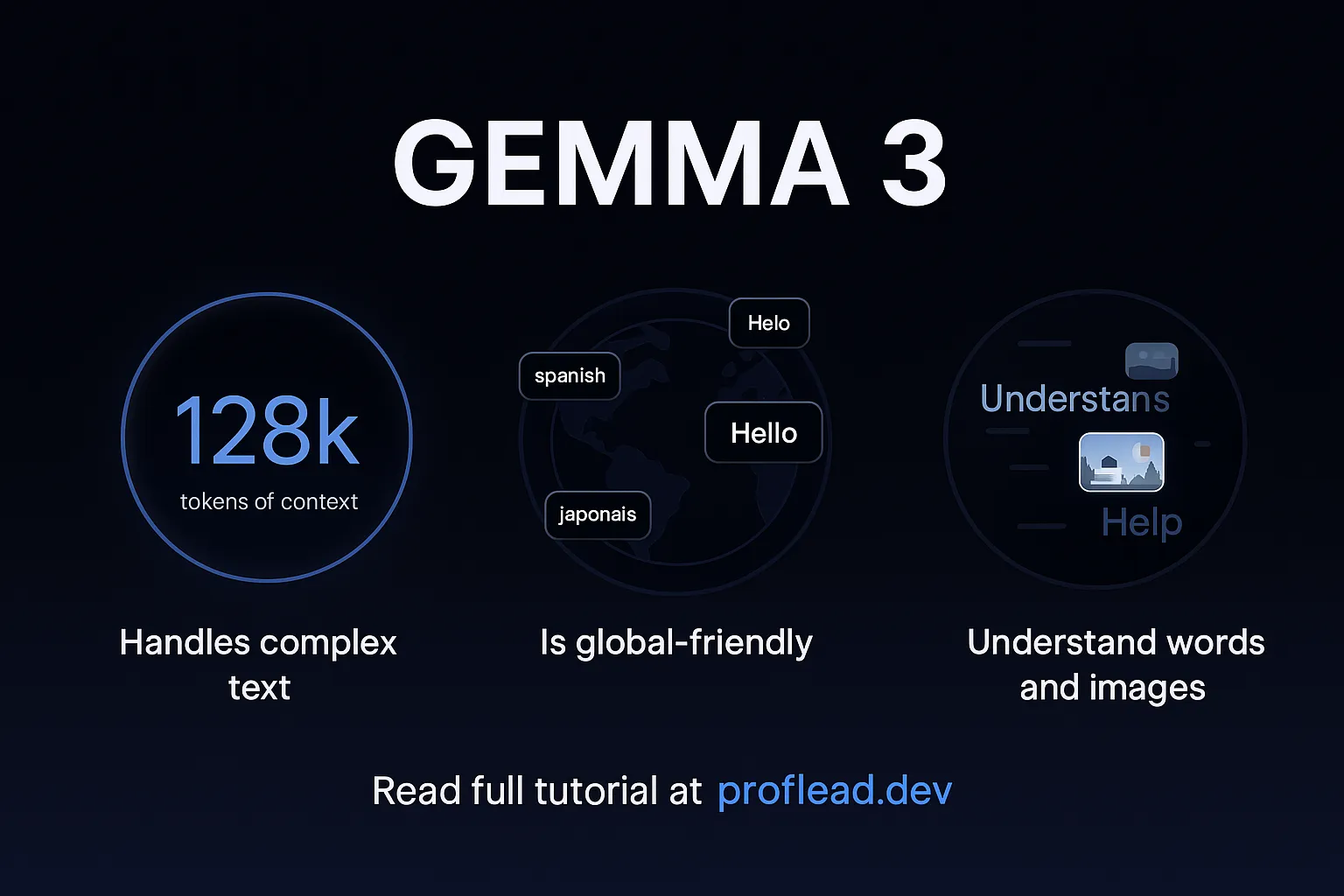

Gemma 3 有四种尺寸——1B、4B、12B 和 27B(B 代表十亿参数)。一般来说,参数越大,模型越智能。但即使是 4B 或 12B 的模型也能处理很多事情。它是多语言的(开箱即支持 140 多种语言),甚至是多模态的,这意味着它可以理解图像和文本的结合。我们只在 GPT-4 等非常高级的模型中见过这种能力。此外,Gemma 3 拥有扩展的内存——128,000 个 token 的上下文窗口——基本上,它可以一次性阅读和记忆非常长的文档或对话。举例来说,这相当于一次处理 100 多页的文本!

Google **向开发者开放了 Gemma 3**。你可以免费下载模型权重,并在本地运行或通过 API 调用 Gemma 3。如果你自己托管,则无需按提示付费。它拥有商业使用许可证,并附带一些负责任的 AI 指南,因此你有可能将其构建到产品中。这种开放模型的方法类似于 Meta 的 LLaMA 2,但 Google 在多模态和高效率方面做得更进一步。

你可以使用你喜欢的工具,例如 **Hugging Face Transformers、Ollama、PyTorch、Google AI Edge、UnSloth、vLLM 等**。在本教程中,我将向你展示如何通过 Hugging Face 使用它。在本教程结束时,我们将拥有一个类似 ChatGPT 的本地运行的 Web 应用程序。

Gemma 3 的主要特点

- 小巧而强大。 Gemma 3 功能强大;即使是大型的 27B 模型也可以在单个 GPU 上运行。它比许多其他 AI 更快、更小。

- 能阅读长文本。 它可以一次性阅读和理解非常长的文档,例如书籍或合同。

- 理解图片和文本。 你可以向它展示一张图片并提问。它知道如何查看图片并给出专业的答案。

- 支持 140 多种语言。 Gemma 支持多种语言——例如西班牙语、法语、日语等。

- 提供清晰的数据。 它可以以 JSON 等格式回复,因此开发人员可以轻松地在应用程序中使用这些答案。

- 可在较小设备上运行。 提供较小版本,因此你可以在内存较小的笔记本电脑上运行它。

- 内置安全。 Google 添加了 ShieldGemma 2 工具,以帮助确保其安全并阻止有害内容。

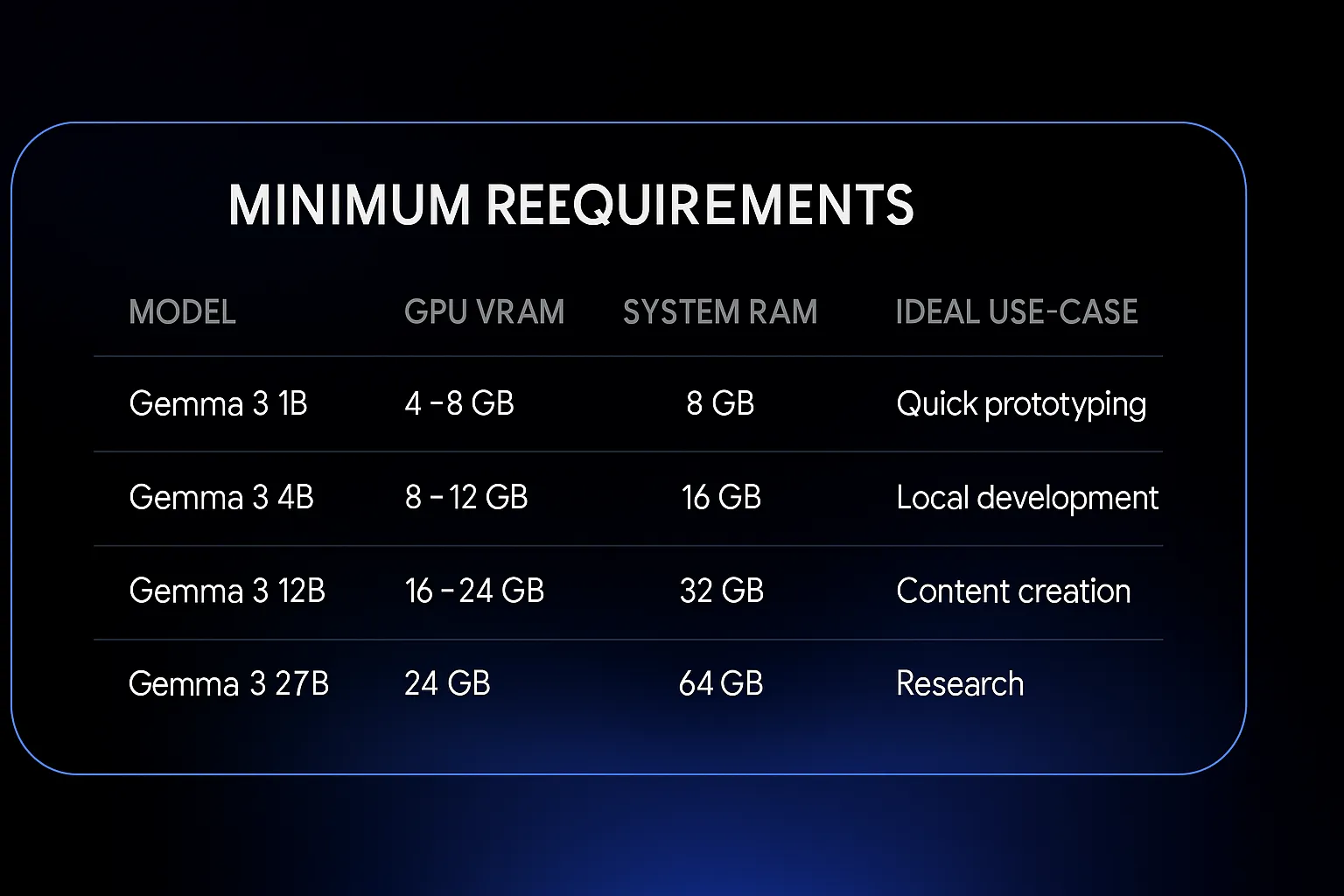

在本地运行 Gemma 3 的最低要求

如果你想在本地计算机上运行 Gemma 3,请确保你的设备符合最低要求。

如何访问 Gemma 3

有多种方法可以使用此模型。在本教程中,我将向你展示三种方法:

- Google AI Studio

- Hugging Face

- Google API

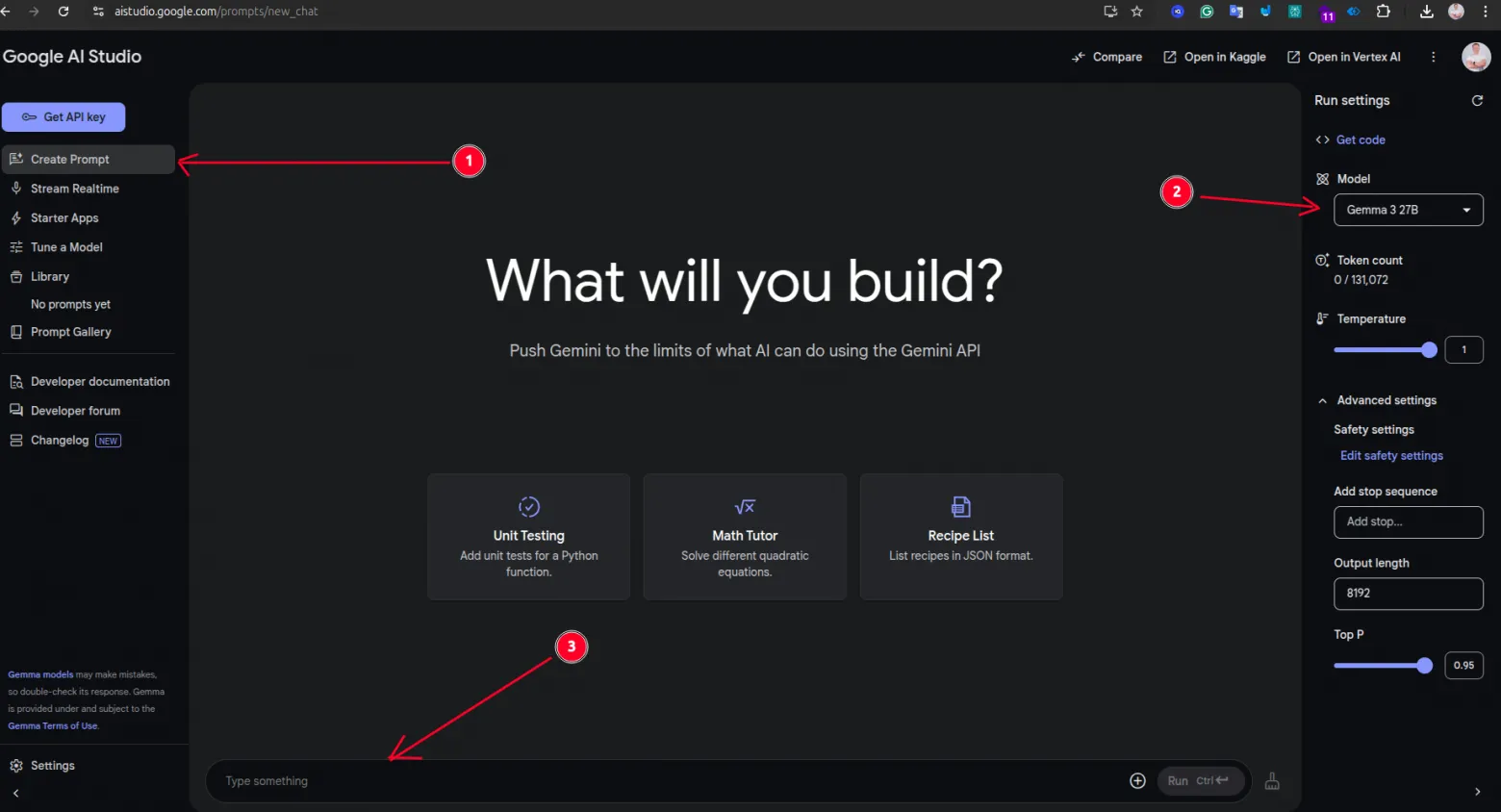

如何在 Google AI Studio 中使用 Gemma 3

- 在浏览器中打开此链接:https://aistudio.google.com/

- 你需要一个 Google 帐户才能使用 AI Studio。

- 点击**“创建提示”**。

- 在**模型设置**中,选择 **Gemma 3**(你可能会看到“Gemma 27B”、“Gemma 4B”等选项)。

- 输入任何你想让 Gemma 协助的内容——例如写作、编码或提问。

- 点击**“运行”**按钮以获取 Gemma 3 的响应。

如何通过 Hugging Face Transformers (Python) 使用 Gemma 3

如果你熟悉 Python,这将非常简单。Hugging Face 的中心有 Gemma 3 模型。你所要做的就是安装 transformers 库,然后下载模型。我不会详细解释所有步骤,但你可以阅读我的 Hugging Face 完整教程,

在我们开始之前,你需要:

- 安装 IDE,如 VSCode

- 安装 Python 语言

然后按照以下步骤操作:

- 打开:https://huggingface.co 并在那里创建一个帐户。

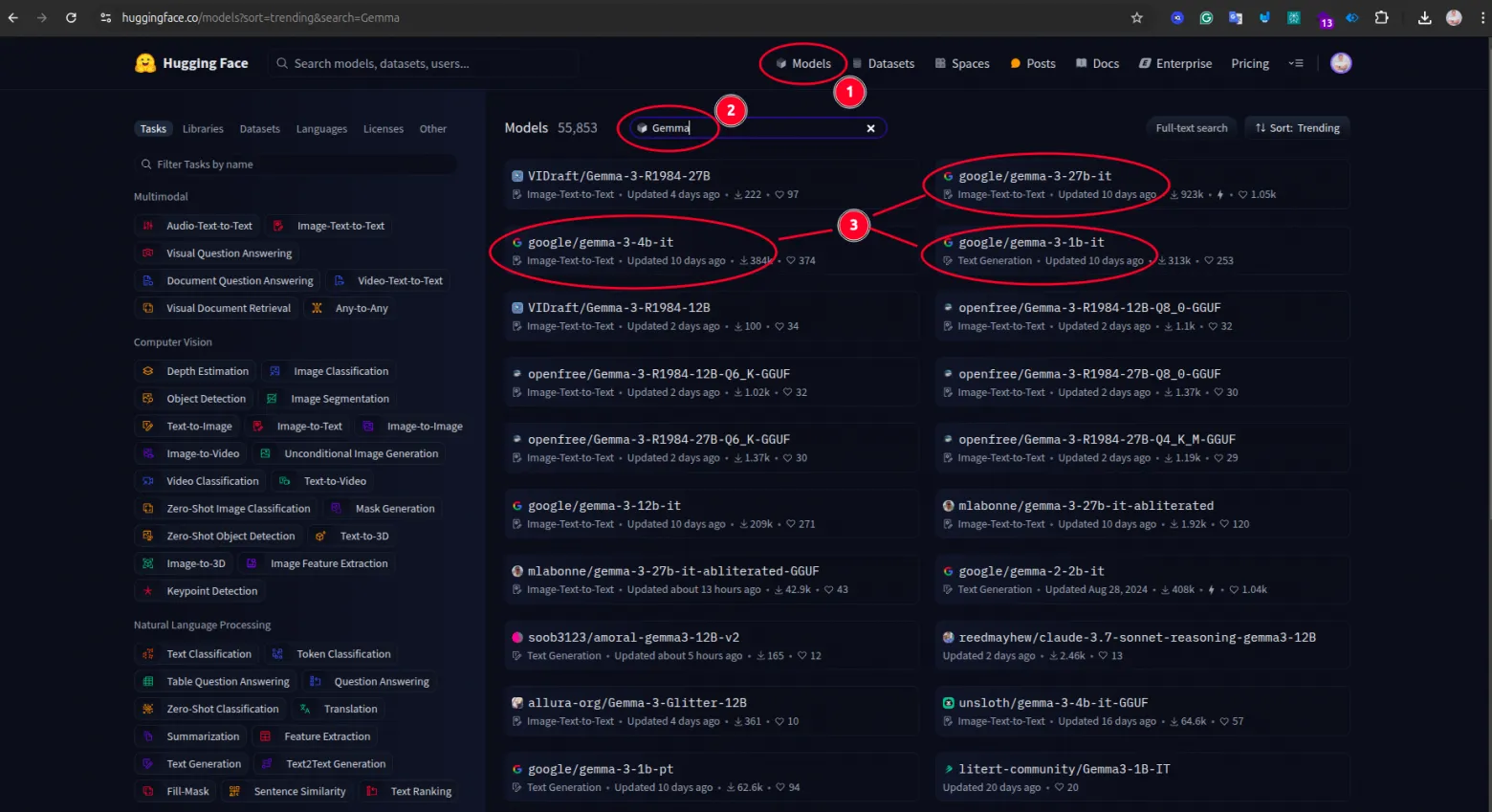

- 点击顶部导航栏中的“Models”链接,然后输入“Gemma”过滤结果,之后从列表中选择一个 Google 模型。

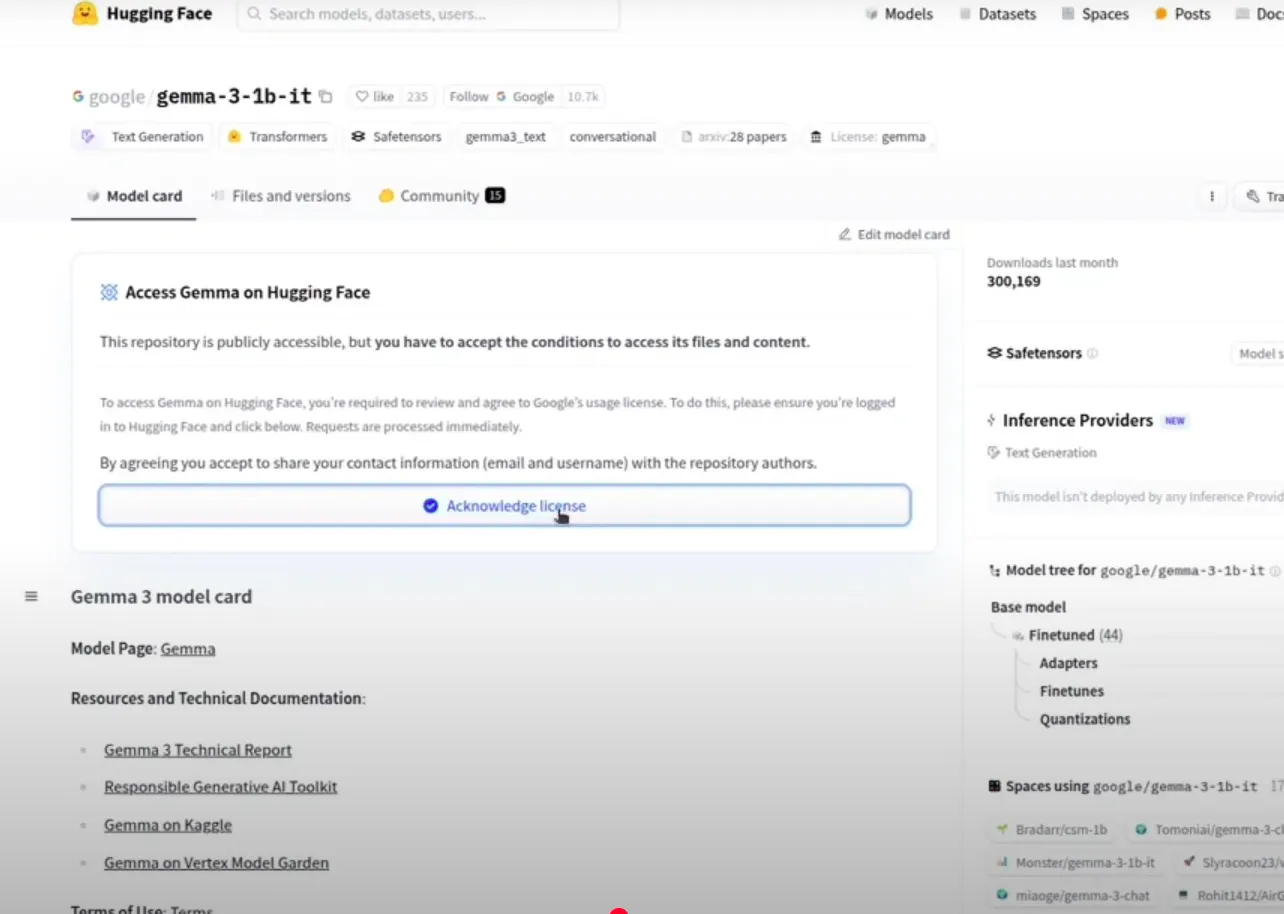

- 选择所需的模型,例如:https://huggingface.co/google/gemma-3-4b-it,并接受许可协议。

然后打开你的终端,逐个粘贴这些命令:

python3 -m venv venv

source venv/bin/activate

pip install transformers datasets evaluate accelerate

pip install torch

然后打开你的 IDE,创建一个新文件,例如 `main.py`,并粘贴以下代码:

from transformers import pipeline

import torch

pipe = pipeline(

"image-text-to-text",

model="google/gemma-3-4b-it",

device="cpu",

torch_dtype=torch.bfloat16

)

messages = [

{

"role": "system",

"content": [{"type": "text", "text": "You are a helpful assistant."}]

},

{

"role": "user",

"content": [

{"type": "image", "url": "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/p-blog/candy.JPG"},

{"type": "text", "text": "What animal is on the candy?"}

]

}

]

output = pipe(text=messages, max_new_tokens=200)

print(output[0]["generated_text"][-1]["content"])

使用此命令运行 Python 代码:

python3 main.py

在此示例中,我们要求 Gemma 查看 URL 中的图像并识别糖果上的动物。我们使用了 Gemma 3-4B 模型和 CPU 设备。

你可以在我的 Git 仓库中找到包含其他示例的完整代码——Gemma 3

如何通过 Google 的 API 使用 Gemma 3

与 Hugging Face 的示例一样,在开始之前你需要:

- 安装 IDE,如 VSCode

- 安装 Python 语言

然后按照以下步骤操作:

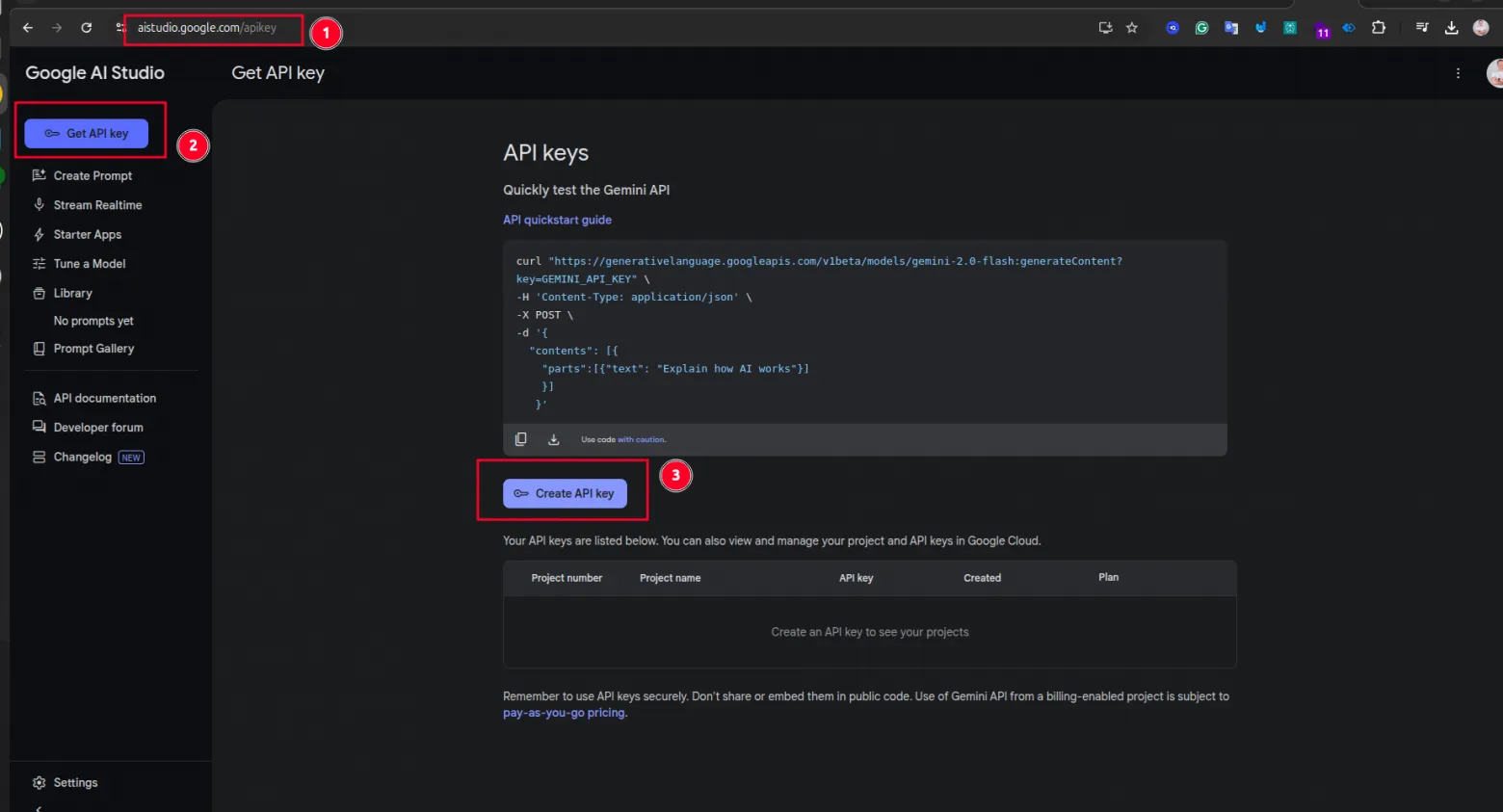

- 打开 https://aistudio.google.com/,如果你没有 Google 账户,请创建一个。

- 然后点击“获取 API 密钥”按钮。在此页面上,你需要生成一个 API 密钥。我们将需要它来连接到 Google Cloud API。

然后打开你的终端,逐个粘贴这些命令:

pip install google-generativeai

pip install google-genai

然后打开你的 IDE,创建一个新文件,例如 `google-cloud-api-terminal.py`,并粘贴以下代码:

import google.generativeai as genai

# Configure the API key

genai.configure(api_key="[REPLACE-THIS-TEXT-WITH-YOUR-API-KEY]")

# Initialize the GenerativeModel with the model name as a positional argument

model = genai.GenerativeModel("gemma-3-27b-it")

# Generate content

response = model.generate_content("What is the latest version of iphone?")

# Print the generated text

print(response.text)

此示例使用了 270 亿参数模型和简单的文本提示。

你可以在我的 Git 仓库中找到包含其他示例的完整代码——Gemma 3

一个类似 ChatGPT 的简单 Gemma 3 Web 应用程序

那么,让我们把所有东西都整合起来,创建一个可以在你的电脑上本地运行的简单 Web 应用程序。在这个例子中,我将使用 Google Cloud API,但你也可以使用 Hugging Face 并将模型下载到你的电脑上。

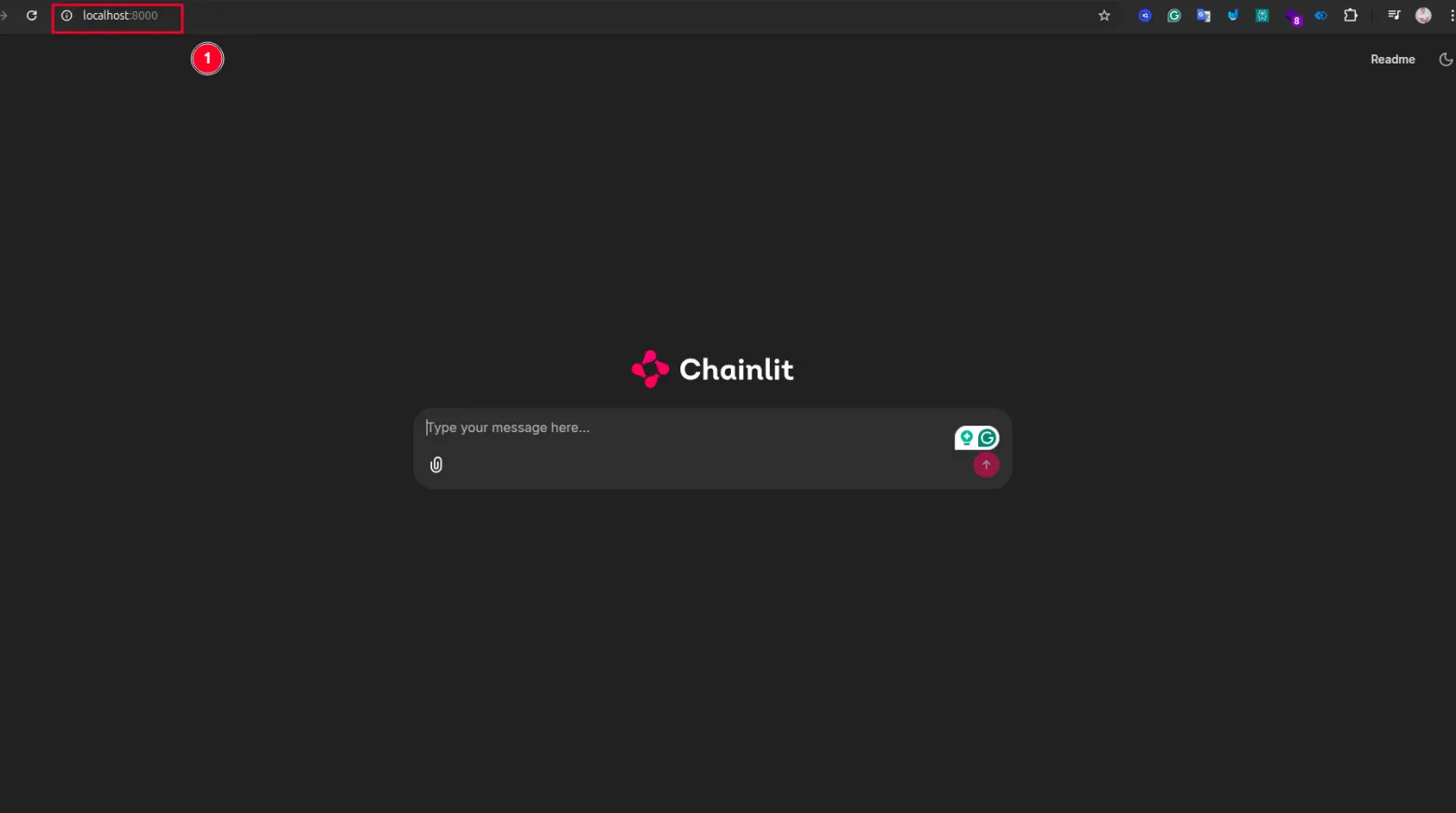

我们将使用 **chainlit 库**。Chainlit 是一个开源的 Python 包,用于构建可用于生产的对话式 AI。

在我们开始之前,你需要:

- 安装 IDE,如 VSCode

- 安装 Python 语言

- Google AI Studio 的 Google API 密钥(请参见上一节)。

然后打开你的终端,逐个粘贴这些命令:

pip install google-generativeai

pip install google-genai

pip install chainlit

然后打开你的 IDE,创建一个新文件,例如 `google-cloud-web-interface.py`,并粘贴以下代码:

import chainlit as cl

import google.generativeai as genai

# Configure the Generative AI client

genai.configure(api_key="[REPLACE-THIS-TEXT-WITH-YOUR-API-KEY]")

# Initialize the GenerativeModel

model = genai.GenerativeModel("gemma-3-27b-it")

@cl.on_message

async def handle_message(message: cl.Message):

# Generate content based on the user's input

response = model.generate_content(contents=[message.content])

reply = response.text

# Send the generated response back to the user

await cl.Message(content=reply).send()

使用此命令运行 Python 代码:

chainlit run google-cloud-web-interface.py

如果一切正常,你将在 https://:8000/ 看到你的 Web 应用程序。

视频教程

我有一个详细解释所有内容的视频教程。你可以在 YouTube 上找到它。

在 YouTube 上观看: Gemma 3 完整指南

结论

总之,Google Gemma 3 是一个功能强大的人工智能,你可以在本地运行并自行定制。无论你是为自定义应用程序优化它的开发人员,还是在 PC 上探索人工智能的爱好者,Gemma 3 都提供了无限的可能性。

如果你觉得本教程有帮助,请**点赞**并**订阅**以获取更多前沿 AI 内容。如果你有任何问题,或者用 Gemma 3 做出了很酷的东西,我很乐意听你分享。

感谢你的阅读,下次再见,编程愉快!👋

祝好!;)

来源:Gemma 3 教程