Common Pile v0.1

四年半前,EleutherAI通过发布The Pile:一个用于语言建模的800GB多样化文本数据集进入人工智能领域。The Pile在当时具有许多独特之处,包括率先使用了现在已成为标准的数据源,如PubMed和StackExchange,并引入了同时在代码和自然语言上进行训练的理念。但最重要的是,它是一个包含3000亿个GPT-2标记的数据集,我们正在积极地用它训练一个大型语言模型,这在当时是其创建者发布过的最大预训练数据集。当我们在2021年初发布GPT-Neo时,它不仅是世界上最强大的开源GPT-3风格模型,也是第一个在由其创建者公开发布的数据上训练的LLM。

公开大规模训练数据集对于严谨的科学工作是必要的。没有训练数据的访问,记忆和隐私、数据整理和课程学习、训练动态以及偏见和公平等领域的研究是不可能进行的。此外,共享语料库使得受控的消融研究和正面比较成为可能,因为可以在相同的数据条件下评估替代架构,正如RWKV(Peng 等人,2023,Peng 等人,2024)和Mamba(Gu和Dao,2023,Gu和Dao,2024)使用The Pile作为比较性能的标准所展示的那样。这使得人们可以更有效地在彼此的工作基础上进行构建,并减少重复劳动。最后,当高度不可复现的基准成为评估模型能力的主要方式时,能够比较训练数据和测试数据是否存在泄露对于建立公众信任至关重要。

过去几年,关于在机器学习中使用数据的诉讼层出不穷。这些诉讼并未实质性地改变LLM训练中的数据来源实践,但它们极大地降低了公司的透明度。比较2020年至2022年发布的模型与2023年至今发布的模型,揭示了透明度下降的令人担忧的趋势。即使是像OpenAI、Anthropic和Google DeepMind这样以封闭著称的公司,过去也曾披露大量关于其预训练数据混合和设计语料库所进行的实验的信息。虽然我们通常更倾向于发布而非仅仅透明,但这些论文比这些公司近年来发布的工作提供了更多关于其训练内容的见解。我们与之交谈的一些公司的研究人员也明确指出,诉讼是他们无法发布在数据密集型领域所做研究的原因。少数组织,如AI2、Hugging Face、Zyphra和LLM360,逆势而上,但公开预训练语料库的增长速度远未赶上公开预训练模型的增长速度。

即使组织不发布其完整的训练数据,公开披露数据信息也是有益于社会的。开源运动的核心原则之一是,人们应该有权了解他们使用和受制于的技术是如何运作的以及为什么。训练数据披露是其中的关键组成部分。它对于问责制也很重要:一些领先的模型提供商一直在警告其产品在生成恶意软件、未经同意的私密图像以及其设计大规模杀伤性武器的详细知识等领域的潜在负面影响[1]。如果他们所声称的是真的,公众有权知道,审计师也需要能够验证公司是否遵循了从训练集中过滤此类数据的最佳实践。目前该领域的状态是,此类最佳实践并不存在,因为没有任何做出此类预训练声明的组织曾披露过任何数据过滤信息。

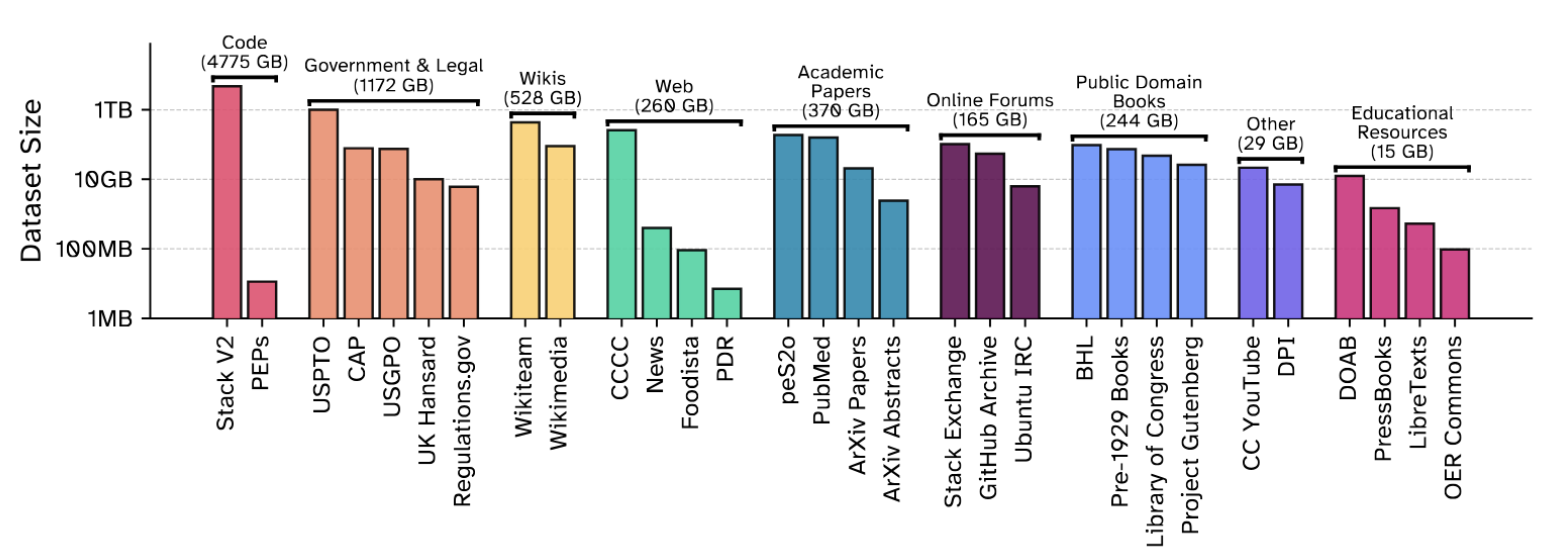

今天,我们很高兴地宣布期待已久的The Pile的继任者:Common Pile v0.1的发布。在与多伦多大学和Vector Institute、Hugging Face、艾伦人工智能研究所、Teraflop AI、康奈尔大学、麻省理工学院、卡内基梅隆大学、Lila Sciences、poolside、马里兰大学帕克分校和劳伦斯利弗莫尔国家实验室的朋友合作下,我们过去两年精心策划了一个8 TB的开放许可和公共领域文本语料库,用于训练大型语言模型。我们还发布了Comma v0.1-1T和Comma v0.1-2T,这些模型分别在这个数据集上训练了1万亿和2万亿个标记。您可以在arXiv、Hugging Face和GitHub上找到我们发布的所有内容。

开放许可数据

开放性是EleutherAI深厚的文化价值观。我们是一个开放科学、开源和开放知识的社区。我们的主要目标之一是赋能世界各地更多的人使用、了解和参与大型语言模型的研究。

什么是开放性?

整理开放许可数据集需要大量努力。对于“开放”许可在不同用途下的构成有不同的看法。对于Common Pile,我们不得不咨询法律专家,以制定一份我们认为足以用于LLM训练数据的开放许可列表。一个好的开始是Blue Oak理事会审查的许可性许可列表。我们决定依赖开放知识基金会的开放许可定义,其中除了许可性许可外,还包括一些共享许可,如Share-Alike许可。

开放许可定义的核心原则与OSI的开源定义、知识共享组织的开放文化声明、维基媒体的许可政策等一致:“开放”意味着任何个人出于任何目的,被授予使用、研究、修改和再分发的权限,无论现有或将来创建的任何媒体和格式,并进行必要的技术修改。(引自CC BY 4.0)

不幸的是,识别特定作品的许可协议出奇地困难,而自动工具的可靠性不足以满足我们的标准。一个显著的例外是代码仓库,我们能够使用软件遗产基金会和BigCode项目以及ScanCode Toolkit开发的优秀工具,来构建Stack v2的开放许可子集。我们相信Common Pile v0.1的这个组成部分将引起许多机器学习研究人员的特别兴趣。在没有自动工具的情况下,我们不得不依赖可信来源提供的元数据和人工整理,旨在识别许可协议并删除我们怀疑许可协议被篡改的内容。

公共领域作品更难识别,因为公共领域不是一种许可,而是一种法律地位,表明版权的缺失或过期。作品是否属于公共领域因司法管辖区而异,而且通常没有确凿的证据证明某份文档属于公共领域。提供公共领域作品访问权限的机构应使用机器可读的权利状态指示符,例如知识共享公共领域标志。然而,我们发现只有少数作品附有公共领域标志,并且作品的公共领域状态是在收藏级别表明的,或者隐藏在网站的某个小字中,就像美国政府印刷局的数字存储库GovInfo的情况一样。

构建开放数据生态

我们和我们的合作者深切关注开放数据生态。在这个项目过程中,我们开发了各种数据提取和许可识别工具、标准和流程,其中一些已经发布,另一些我们计划在未来发布。

2024年6月,Mozilla和EleutherAI共同举办了一次数据集召集会,汇集了来自开源人工智能初创公司、非营利人工智能实验室和民间社会组织的专家,共同讨论开放数据领域的新兴实践。我们也在召集会上预览了这项工作,并获得了关于决策过程的意见和反馈。此次召集会的结果已在一篇论文中进行了总结:《迈向LLM训练开放数据集的最佳实践》。

我们已将用于构建此数据集的代码发布在Github上,并预计其中一些工具将广泛有用。我们还与Mozilla合作发布了独立的工具,用于使用Whisper转录音频文件和使用Docling进行文档转换(请在此处了解更多信息)。

基于 Common Pile v0.1,我们旨在今后与朋友和合作伙伴更频繁地发布开放数据集。我们认为文化遗产领域在合作方面存在巨大的未开发潜力。Common Pile 已经包含了国会图书馆和互联网档案馆数字化的近 30 万本公共领域书籍的文本。其中许多书籍都是使用传统的 OCR 技术数字化的。我们相信,应用当前最先进的开源 OCR 模型,如 Docling 或 Surya,将显著提高提取文本的质量。同样,我们成功地使用 Whisper 转录音频内容,并希望在未来使用它来改善字幕制作,使数据更易于访问。我们相信,现在是时候在开源 AI 社区与图书馆、博物馆和档案馆之间建立互惠互利的伙伴关系,以将更多公共领域作品发布为高质量的开放数据集了。

Comma v0.1的性能与在未授权数据上训练的模型相当

当人们谈论使用开放许可文本训练LLM时,一个常见的担忧是,生成的模型不如在未许可数据上训练的模型。为了解决这个问题,我们训练了两个7B参数的模型,一个训练了1万亿个标记,一个训练了2万亿个标记,都在我们的数据集上进行。我们发现我们的Comma模型与在相同条件下使用未许可数据训练的领先模型性能相当。

Comma v0.1-1T 和 Comma v0.1-2T 与在类似条件下训练的模型性能比较。Qwen 3 训练了 36 万亿个标记,并作为当前最先进技术的参考。

Comma v0.1-1T 和 Comma v0.1-2T 与在类似条件下训练的模型性能比较。Qwen 3 训练了 36 万亿个标记,并作为当前最先进技术的参考。

我们还通过小规模的消融研究,比较了我们的数据集与其他授权和未授权数据集。我们发现,在Common Pile v0.1上训练的模型优于在KL3M、OLC和Common Corpus上训练的模型,并且与在Pile或OSCAR上训练的模型性能相当。尽管如此,与FineWeb相比仍存在差距。

总的来说,我们认为未经许可的文本会提升性能这一普遍观念是没有根据的。虽然与 FineWeb 相比存在性能差距,但我们将其归因于 FineWeb 拥有更大的数据池,因此可以更积极地过滤出最佳数据进行训练。随着可访问的开放许可和公共领域数据量的增长,我们可以预期基于开放许可内容训练的模型质量会提高。

展望未来

将这个数据集命名为Common Pile v0.1是一个非常明确的意图声明。我们对这次发布感到非常兴奋,但将其视为第一步而非最后一步。我们希望构建更大更好的版本,解锁目前无法使用的开放许可数据,并为公共领域贡献更多。我们也对开放许可的后期训练数据感兴趣,以便我们可以调整Comma v0.1模型,使其对更多用户更有用。

引用信息

引用本作品,请使用

@article{kandpal2025common,

title={{The Common Pile v0.1: An 8TB Dataset of Public Domain and Openly Licensed Text}},

author={Kandpal, Nikhil and Lester, Brian and Raffel, Colin and Majstorovic, Sebastian and Biderman, Stella and Abbasi, Baber and Soldaini, Luca and Shippole, Enrico and Cooper, A. Feder and Skowron, Aviya and Longpre, Shayne and Sutawika, Lintang and Albalak, Alon and Xu, Zhenlin and Penedo, Guilherme and Ben Allal, Loubna and Bakouch, Elie and Pressman, John David and Fan, Honglu and Stander, Dashiell and Song, Guangyu and Gokaslan, Aaron and Kirchenbauer, John and Goldstein, Tom and Bartoldson, Brian R. and Kailkhura, Bhavya and Murray, Tyler},

journal={arXiv preprint arXiv:2506.05209},

year={2025}

}

脚注

[1] 虽然就这些话题进行诉讼超出了本工作的范围,但我们认为,未经同意的私密图像(NCII)造成的伤害威胁远比生成恶意软件或分享大规模杀伤性武器信息更为确凿。尽管如此,当一家公司对其商业产品做出如此戏剧性的声明时,他们有道德义务解释为什么他们