让大模型辩论:首届多语种大语言模型辩论赛

在过去的一年中,当前的静态评估和用户驱动的竞技场已经显示出其局限性和偏见。在这里,我们探索一种新颖的大语言模型评估方法:辩论。从公元前 5 世纪雅典公民大会的辩论到今天的世界大学辩论锦标赛,辩论在整个历史中都是展示推理能力和语言能力的绝佳方式。当今的大语言模型是否展现出与人类相似的辩论技巧?目前哪个模型最擅长辩论?当模型相互辩论时,我们能从中学到什么?为了回答这些问题,BAAI 创建了一个“辩论竞技场”,让大模型相互竞争。目前,它支持英语、中文、阿拉伯语和韩语的辩论比赛。

背景:重新定义大语言模型评估标准的必要性

多模态和多语种技术的发展暴露了传统静态评估协议在捕捉大语言模型在复杂交互场景中性能的局限性。受 OpenAI 的“通过辩论实现 AI 安全”框架(该框架强调通过多模型互动增强模型的推理和逻辑能力([1]))的启发,BAAI 的 FlagEval 辩论平台引入了一种动态评估方法来解决这些局限。最近的研究表明,多智能体辩论在提高模型的推理能力和事实准确性方面具有潜力。例如,研究表明多智能体互动可以显著提高模型在逻辑推理和事实判断上的一致性和准确性([2]),而其他研究则指出多模型辩论能鼓励模型生成更真实、更连贯的回答([3])。虽然像 LMSYS Chatbot Arena 这样的现有平台为多模型互动提供了基础设置,但它们在实际评估中存在某些局限性:

- 缺乏区分度:许多模型对抗结果为平局,缺乏显著的性能差异。这需要大量的用户投票来确保统计的稳定性和准确性,从而降低了评估效率,并妨碍了对模型相对优劣的快速比较。

- 孤立生成现象:在这些平台中,模型并非真正互动;相反,它们根据用户输入独立生成回答,而没有与对方的输出进行互动。这种单向生成依赖于随机的用户对话,使得难以探究模型推理和逻辑的边界,也难以在复杂的对抗性情境中评估其性能。

- 潜在的投票偏见:由于模型通常表现出独特的风格,用户的投票通常偏爱特定的模型生成风格或格式,而不是评估内容本身。没有专家标注,这些偏见会扭曲评估结果,使客观评估模型能力变得复杂,并降低了用户驱动判断的可靠性。

BAAI 的 FlagEval 辩论平台通过引入真正的多模型辩论来解决这些挑战。模型进行直接对抗,展示其推理过程和深度。这使得评估者可以观察和比较模型之间在观点、逻辑推理和论证策略上的差异。该平台的多语种支持和实时调试功能使用户能够在真实和互动的环境中研究模型优势,最终提供更具区分度和深度的评估结果。

FlagEval 辩论赛的主要特点与创新

多语种支持:实现全面的全球评估

FlagEval 辩论赛支持中文、英文、韩文和阿拉伯文,涵盖了多种书写系统和语言。这种多语种能力为模型在跨文化背景下表现提供了平台,并测试了它们在不同语言环境中的适应性和沟通效果。这满足了全球对多语种大语言模型评估的需求。

开发者定制:灵活的模型配置与优化

为增强公平性和灵活性,FlagEval 辩论赛提供开发者定制功能,允许参赛模型团队根据其模型的特点和任务要求微调参数、策略和对话风格。此功能使开发者能够优化其模型在辩论中的表现,展示优势同时发现改进之处。实时反馈循环促进了持续优化,使模型在竞争性评估中脱颖而出。

双重评估指标:专家评审与用户反馈

FlagEval 辩论赛采用独特的双重评估系统,结合专家评审和用户反馈,从技术和体验两个角度评估模型。

- 专家评审:我们邀请了顶级的辩论专家,从逻辑推理、论证深度和语言表达等维度对模型进行严格评估。这些专家提供客观、详细的评估,确保评估结果具有高度的专业可信度。

- 用户反馈:同时,平台通过观众投票促进用户参与,用户可以根据个人偏好和互动体验为模型打分。这些反馈反映了模型在实际用户互动中的接受度和有效性,补充了专家评估。整合用户视角确保评估与真实应用场景保持一致。

实验结果:评估多模型辩论的影响

在 2024 年第三季度,我们在 FlagEval 辩论平台上进行了广泛的实验,以评估多模型辩论对模型逻辑推理和差异化表现的影响。实验得出了一些关键见解:1. 大多数现有模型都能参与辩论 我们的实验表明,所有参赛模型,包括闭源变体,都能有效地参与辩论任务。这表明,不同架构和训练范式的模型都具备在多模型环境中进行逻辑推理和互动对话所需的能力。这种广泛的适用性增强了 FlagEval 辩论赛作为综合评估平台的相关性。我们通过经验观察到,一些小型开源模型在保持连贯性和紧扣主题方面仍面临挑战。

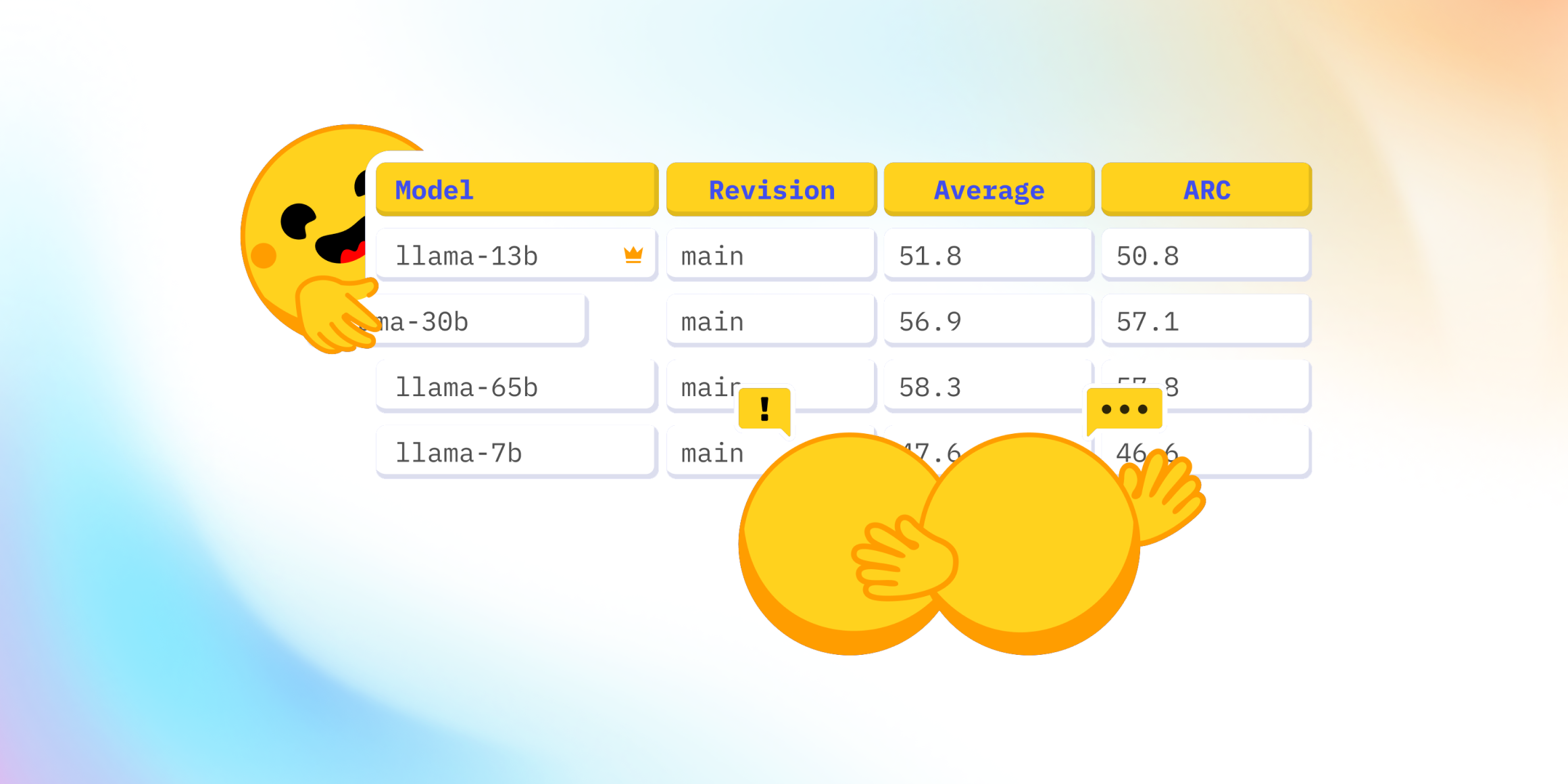

- 模型在对抗条件下表现出强烈差异 互动对抗揭示了推理逻辑、论证技巧和语言使用方面的显著差异,尤其是在对抗条件下。然而,在发布这些细致的发现之前,我们正在等待更多的专家评估。通过促进直接互动,FlagEval 辩论赛能够更细致地评估模型的逻辑推理、批判性思维和修辞策略,而无需依赖大型的预存数据集。如下图所示,即使只有几百场比赛,很明显 Model_7 的获胜次数显著更高,而 Model_3 累计了更多的失败次数。在传统的竞技场式和一对一评估中,这些模型之间的性能差距往往不那么明显,通常需要大量的比赛才能得出结论性结果。与 LMSYS Chatbot Arena 类似,FlagEval 辩论赛也接收新模型提供商的评估请求。由于这些提供商仍在对其模型进行微调,我们在微调完成并获得足够的用户投票和专家评审之前,会保持模型匿名。

模型有巨大的改进潜力 在开发的早期阶段,我们观察到模型在辩论中会犯各种类型的错误。例如,一个模型会同时生成正方和反方的内容,而另一些模型即使在不恰当的情况下也会表现出强制同意。例如:

{ "model_A": "Affirmative: I believe that a Dutch man fathering 1,000 children through sperm donation is a remarkable gesture. First, he provides hope and opportunities for couples who long for children but face challenges. Secondly, he demonstrates selflessness and kindness, showing a willingness to give part of his life for others. For the mothers carrying his children, it’s a valuable gift in their lives. His actions bring love and hope to the world. Negative: However, this action also raises moral and legal concerns. Having so many children from one individual could lead to family conflicts and legal disputes. Additionally, how will they handle the responsibilities of supporting and educating so many children? This could also place a burden on society. So, even if done with good intentions, the potential consequences of such actions need careful consideration.", }我们通过优化系统提示要求和调整输入格式解决了这些问题,尽管每个模型仍然表现出独特的错误模式。同时,实验也突显了模型增强的巨大机会。性能差异表明在推理链、语言表达能力和对抗策略方面有改进的潜力。我们鼓励模型创建者使用我们的辩论调优服务来完善和优化他们模型的辩论性能!

更强的评估:结合专家反馈与用户偏好 我们的研究结果还表明,仅仅依靠用户偏好进行评估可能会引入偏见并限制性能评估的准确性。为了缓解这种情况,FlagEval 辩论赛的双重评估系统整合了专家评审,以提供一个平衡的视角。通过将可靠的专家评估与主观的用户反馈相结合,我们旨在确保一个更公平、更全面的评估,使结果既符合技术专业知识,也符合人类偏好。

如何将您的模型加入到这场比赛中?

初步实验表明,参赛辩论模型的性能在及时优化后会有显著提升。欢迎模型提供商和创建者点击链接辩论赛报名表或发送邮件至flageval@baai.ac.cn。通过报名参加模型辩论评估,FlagEval 将提供免费的模型辩论调试服务。以下公司已经参与了我们的辩论:

| 公司 | 模型 | 调试方法 |

|---|---|---|

| OpenAI | o1-preview | 自行调试 |

| OpenAI | o1-mini | 自行调试 |

| OpenAI | GPT-4o-mini | 自行调试 |

| OpenAI | GPT-4o | 自行调试 |

| Anthropic | claude-3-5-sonnet | 自行调试 |

| 月之暗面 | step-2-16k-f | 提供商调试 |

| 百度 | ERNIE-4.0-Turbo | 提供商调试 |

| 字节跳动 | Doubao-pro | 提供商调试 |

| 阿里巴巴 | qwen2.5-72b-instruct | 自行调试 |

| 腾讯 | Hunyuan-Turbo | 提供商调试 |

| 零一万物 | Yi-Lightning | 自行调试 |

| 智谱 AI | GLM-4-plus | 提供商调试 |

| 深度求索 | DeepSeek_V2.5 | 自行调试 |

- 自行调试:指我们为辩论配置和优化的模型。

- 提供商调试:指由模型提供商自己调试和优化的模型。

结论

FlagEval 辩论赛代表了大语言模型评估方法的重大进步。通过整合多语种支持、开发者定制和双重评估系统,它为在互动、真实世界场景中评估模型提供了一个强大的框架。展望未来,BAAI 致力于完善此平台,以促进创新、增强评估方法,并推动 AI 实践的标准化。目标是为开发者和用户提供一个具有前瞻性的评估生态系统,加速先进大语言模型的演进和部署。

关于 BAAI 和 FlagEval

北京智源人工智能研究院(BAAI)成立于 2018 年 11 月,是一家开创性的非营利性研究机构,主要专注于人工智能领域的原始创新和核心技术。其目标是推动 AI 理论、方法、工具、系统和应用方面的革命性和颠覆性突破。在 BAAI 内部,FlagEval 是一个专门从事大规模 AI 模型评估的团队。FlagEval 于 2023 年推出了其大模型评估平台,至今已覆盖全球 800 多个模型。该平台评估超过 40 个维度,包括推理、数学技能和任务解决能力。FlagEval 最近推出了用于模型对模型竞赛的新平台,进一步加强了其评估框架并推进了 AI 评估方法论。它已被公认为推动 AI 评估标准和促进学术界与产业界合作的领导者。

参考文献

[1] Irving G, Christiano P, Amodei D. AI safety via debate. arXiv preprint arXiv:1805.00899, 2018.

[2] [ICML 2024] Du Y, Li S, Torralba A, et al. Improving factuality and reasoning in language models through multiagent debate. arXiv preprint arXiv:2305.14325, 2023.

[3] [ICML 2024 Best] Khan A, Hughes J, Valentine D, et al. Debating with more persuasive llms leads to more truthful answers. arXiv preprint arXiv:2402.06782, 2024.