日语 LLM 开放排行榜简介

如今,大语言模型在英语方面的能力越来越强,但我们很难了解它们在其他国家语言中的表现,这些语言虽然被广泛使用,但却存在其独特的语言挑战。今天,我们很高兴能够填补日语在这方面的空白!

我们在此宣布推出 日语 LLM 开放排行榜,该排行榜由超过 20 个数据集组成,涵盖了从经典到现代的各种自然语言处理(NLP)任务,旨在深入了解日语 LLM 的内在机制。该排行榜由 LLM-jp(一个旨在研究和开发日语大语言模型的跨组织项目)与 Hugging Face 合作建立。

日语有其独特的挑战。它的形态丰富,并且由于历史和文化上与世界各地的交流而不断演变。其书写系统基于三种独立字符集的混合:简体中文表意符号汉字(漢字)、表音字母系统平假名(平仮名 / ひらがな)和片假名(片仮名 / カタカナ),后者常用于外来词。现代日语可以说是最难处理的语言之一,因为它混合了汉日词、和语词、拉丁字母(罗马字 / ローマ字)、来自荷兰语、葡萄牙语、法语、英语、德语的借词,以及阿拉伯数字和中文数字。此外,日本的数字世界还为我们带来了使用 Unicode 编写的表情符号 : )、使用西里尔字母的颜文字 (っ °Д °;)っ,以及使用希腊字母的颜文字 _φ(°-°=)。当然,我们不能忘记经典的 emoji,它起源于 20 世纪 90 年代手机在日本的普及。

日语复杂的书写系统还隐藏着更深一层的复杂性,即词与词之间没有空格。与中文或泰语类似,日语在语言单位之间没有空格,这使得在分词过程中检测词边界变得极其困难。多年来,充满活力的日本生态系统(从知名大学实验室、人工智能初创公司到行业巨头的研发中心)已将日语 NLP 的特性融入其中,开发出了强大的现代日语 LLM,但该领域一直缺乏一个集中、开放的系统来比较这些模型。

因此,我们推出了日语 LLM 开放排行榜,这是 Hugging Face 与 LLM-jp 的一次合作,旨在促进研究的透明度,并鼓励开源模型的开发理念。我们坚信,这一举措将成为一个平台,让日本及国际研究人员能够协作、评估和改进日语 LLM。

排行榜任务简介

日语 LLM 开放排行榜使用专门的评估套件 llm-jp-eval 对日语 LLM 进行评估,涵盖了从经典任务(如自然语言推理、机器翻译、摘要、问答)到更现代的任务(如代码生成、数学推理或人类考试)等 16 项任务。任务以 4-shot 的方式启动。

数据集由 LLM-jp 的评估团队编制,部分由语言学家、专家和人工标注者从头构建,部分则自动翻译成日语并根据日语特性进行调整,其中一些任务需要长上下文推理能力。为了更好地理解排行榜,我们将详细介绍 8 个数据集的样本(日语原文后附浅灰色英文翻译)。有关所有可用任务的更多详细信息,请参阅排行榜的“关于”选项卡以及各数据集的官方链接。

Jamp

Jamp (Controlled Japanese Temporal Inference Dataset for Evaluating Generalization Capacity of Language Models) 是用于自然语言推理(NLI)的日语时间推理基准。该数据集探索了具有各种时间推理模式的英语和日语句子对,并用蕴含、中性或矛盾等黄金标签进行标注。

JEMHopQA

JEMHopQA (Japanese Explainable Multi-hop Question Answering) 是一个日语多跳问答(QA)数据集,可以评估模型的内部推理能力。这项任务要求模型接收一个问题作为输入,并生成答案和推导过程。

jcommonsenseqa

jcommonsenseqa 是 CommonsenseQA 的日文版,是一个多项选择问答数据集。该数据集旨在评估模型的常识推理能力。

chABSA

chABSA 是作为基于方面的情感分析 (Aspect-Based Sentiment Analysis) 数据集开发的。ChABSA 基于日本上市公司 2016 财年的财务报告,对实体、属性和情感三元组进行标注。具体来说,根据日本金融监管机构金融厅 (Financial Service Agency, FSA) 的分类法,对日本 2,260 家上市公司中的 230 家(约占所有公司的 10%)进行了标注。

mbpp-ja

mbpp-ja 数据集是一个编程数据集:它是 Mostly Basic Python Problems (MBPP) 数据集的日文版,由 LLM-jp 利用翻译工具 DeepL 从英语翻译成日语。

mawps

基于数据集 MAWPS (A Math Word Problem Repository),日语 mawps 数据集是一个数学评估数据集。该版本评估模型通过逐步推理解决新任务的能力,这一过程也称为思维链 (Chain-of-Thought, CoT) 推理。该数据集调整了人名、单位和地名,以适应日本的语境。数学推理的水平相对简单:加法、减法、多步算术,以及单个或成对的方程。

JMMLU

JMMLU 是一个使用四选一问答形式的知识数据集。它由 MMLU 数据集的一部分问题翻译成日语构成,旨在评估高中水平测试的知识。该数据集基于天文学、化学、社会学、国际法等 57 个学科,问题和答案均被翻译成日语,同时根据日本独特的文化背景进行了调整,例如日本公民学、日本地理和日本习语。

XL-Sum

XL-Sum 是一个摘要数据集,基于研究论文 “XL-Sum: Large-Scale Multilingual Abstractive Summarization for 44 Languages”,利用了 BBC 新闻文章的日文译文。该数据集分为三部分:标题、文本(全文)和摘要。主题涵盖全球议题、政治、科技、体育和文化。

技术设置

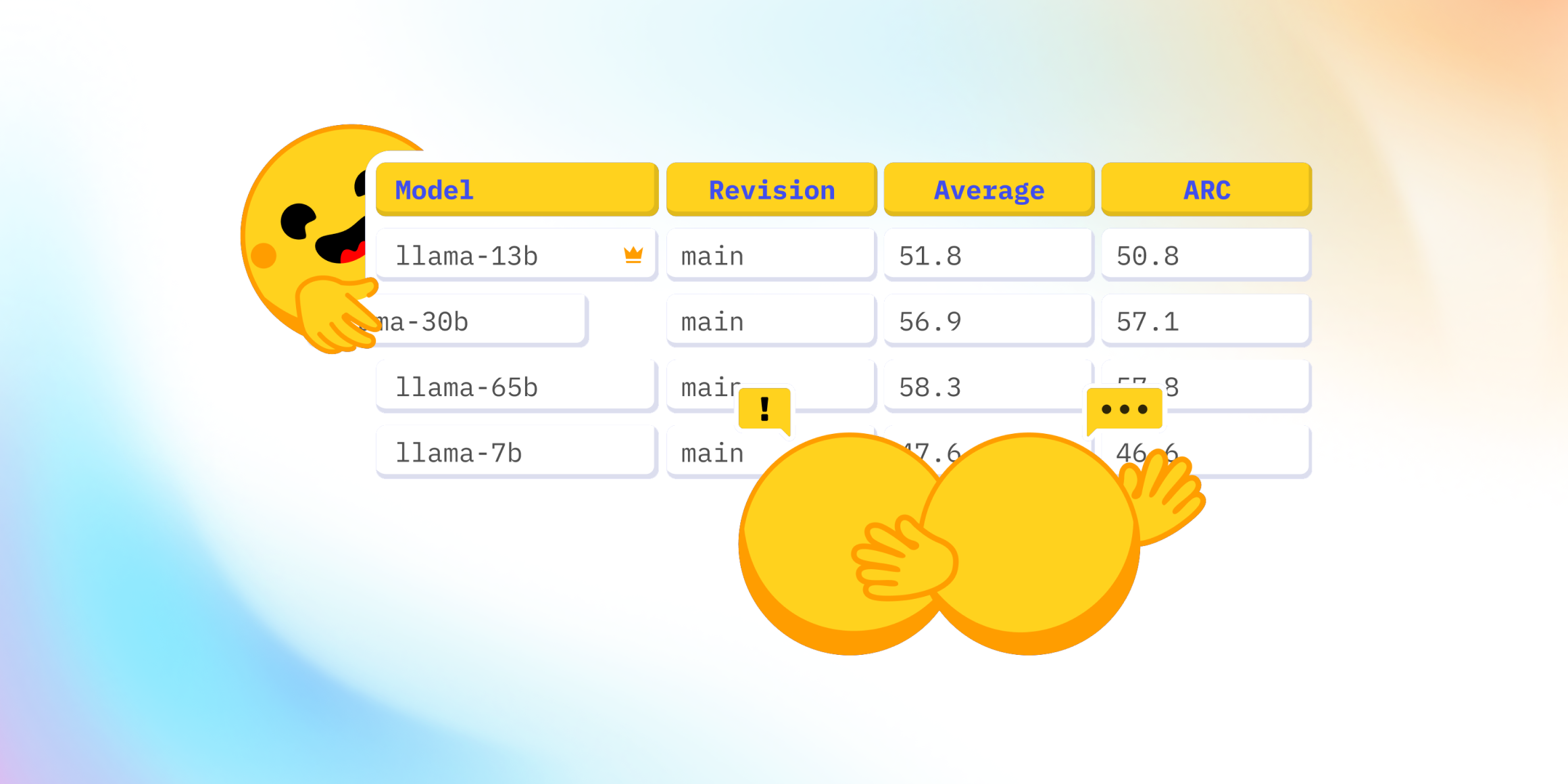

该排行榜的灵感来源于 开放 LLM 排行榜。提交的模型使用 Hugging Face 的 推理端点 (Inference Endpoints) 自动部署,通过 llm-jp-eval 库 (1.14.1 版) 进行评估,并利用内存高效的推理和服务引擎 vLLM (v0.6.3 版) 进行处理。后端计算由日本领先的研究计算平台 mdx 提供支持。

观察发现

根据日语 LLM 指南 Awesome Japanese LLM(提供日语、英语和法语版本),Meta 的 Llama 开源架构似乎是许多日本 AI 实验室的首选。然而,日本开源社区也成功地利用了其他架构,例如法国 Mistral 的 Mistral 和中国阿里巴巴的 Qwen。这些架构都带来了在日本 LLM 排行榜上取得最佳分数的模型。

在通用语言处理任务上,我们观察到基于开源架构的日语 LLM 正在缩小与闭源 LLM 的差距。例如,由 LLM-jp 开发并由大学拨款资助的日语 LLM llm-jp-3-13b-instruct,其性能已接近闭源模型。特定领域的数据集,如 chABSA(金融)、Wikipedia Annotated Corpus(语言学标注)、代码生成(mbpp-ja)和摘要(XL-Sum)对大多数 LLM 来说仍然是一个挑战。有趣的是,源自日本公司或实验室的模型在特定的 JCommonsenseMorality 数据集上得分更高。该数据集评估模型在面对道德困境时根据日本价值观做出选择的能力。

未来方向

日语 LLM 开放排行榜将跟随评估工具 llm-jp-eval 的发展,以反映日语 LLM 的不断演进。以下是 llm-jp-eval 未来方向的一些示例,我们希望得到支持。欢迎联系我们提供帮助或提出建议!

新数据集:更多日语评估 llm-jp-eval 的评估团队正在致力于此部分,目前正在添加 JHumanEval (HumanEval 的日文版) 和 MMLU (衡量大规模多任务语言理解)。

新评估系统:思维链评估 我们希望比较 LLM 在使用思维链提示与基本提示时的性能差异,以便更深入地了解模型行为。

新指标支持:选项外率 (Out-of-Choice rate) 对于一些已经有明确标签列表的评估任务(如自然语言推理),我们希望增加一个补充指标,测试模型预测选项外词元 (token) 的频率。由于选项已在提示中提供,这将使我们能够评估每个 LLM 遵循特定指令的能力。

致谢

日语 LLM 开放排行榜由研究联盟 LLM-jp 建立,并荣幸地获得位于日本东京的国立情报学研究所以及高性能计算平台 mdx 项目的赞助。

我们谨向东京大学的宫尾祐介教授和韩南起在科学咨询和指导方面的贡献表示感谢,并感谢 Hugging Face 的 Clémentine Fourrier 和 Toshihiro Hayashi 协助我们集成和定制了他们的新评估框架和排行榜模板。