推出 ConTextual:您的多模态模型在文本丰富的场景中能多好地联合推理文本和图像?

模型在理解独立文本方面已经相当出色,但对于图像中的文本(提供重要的上下文信息)呢?例如,导航地图或理解一个表情包?对图像中文本和视觉上下文之间交互进行推理的能力可以支持许多现实世界的应用,例如AI助手或辅助视障人士的工具。

我们将这些任务称为“上下文敏感的富文本视觉推理任务”。

目前,大多数对指令调整的大型多模态模型(LMM)的评估都集中在测试模型对图像上的提问或命令式句子(“数一下这个”、“列出那个”等)的响应能力……但未能很好地理解上下文敏感的富文本场景!

这就是为什么我们(来自加州大学洛杉矶分校的研究人员)创建了 ConTextual,一个用于评估 LMM 的上下文敏感的富文本视觉推理数据集。我们还发布了一个排行榜,以便社区可以亲自查看哪些模型在此任务中表现最佳。

如需深入了解,您还可以查看这些额外资源:论文、代码、数据集、验证数据集 和 排行榜。

什么是 ConTextual?

ConTextual 是一个上下文敏感的富文本视觉推理数据集,包含 506 条用于 LMM 评估的挑战性指令。我们创建了文本丰富的图像上各种指令,并要求它们需要对图像中的文本和视觉线索进行上下文敏感的联合推理。

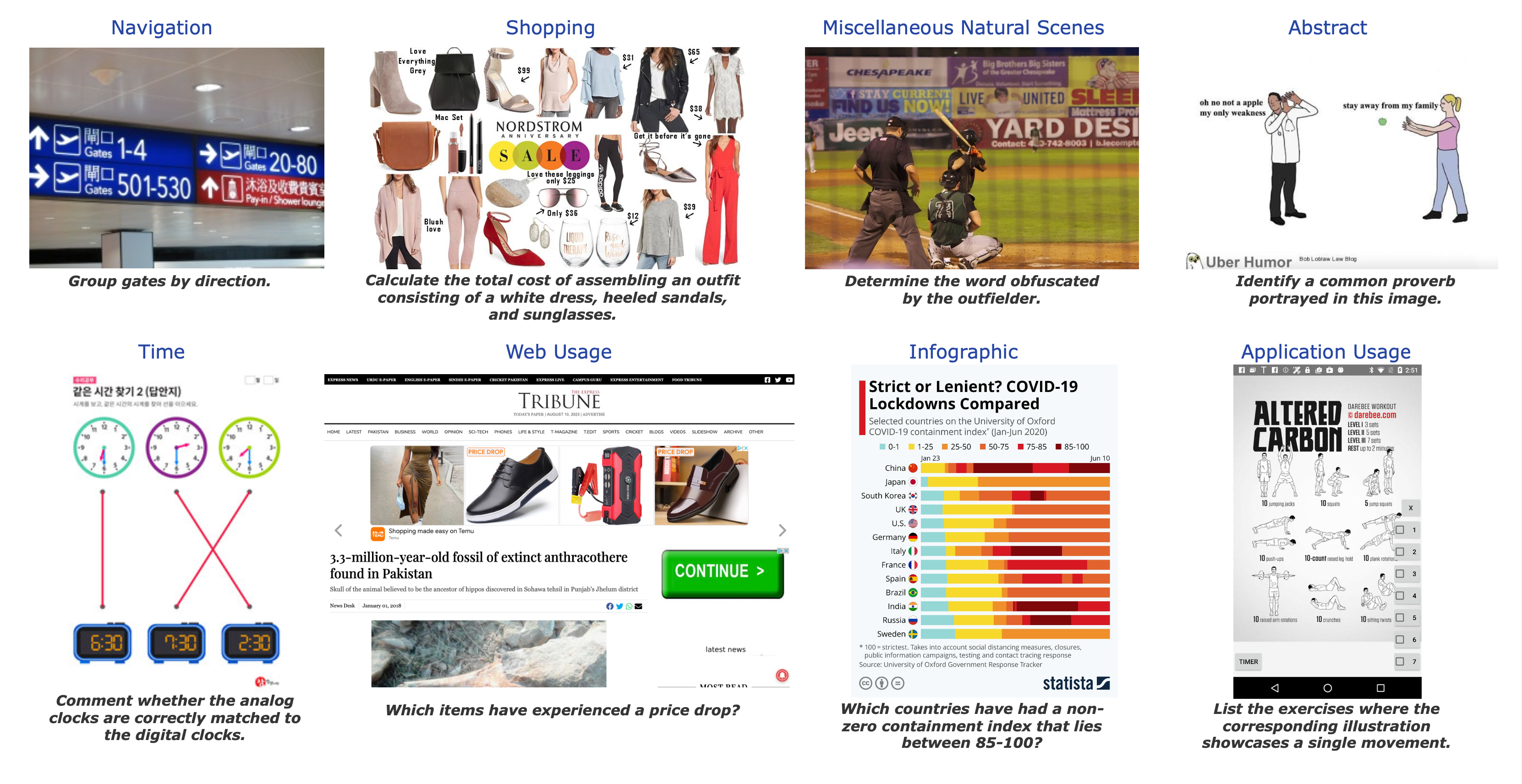

它涵盖了 8 种现实世界的视觉场景——时间阅读、购物、导航、抽象场景、移动应用程序、网页、信息图表和杂项自然场景。(请参阅图以获取每个数据集的样本。)

每个样本包括:

- 一张文本丰富的图像

- 一条人工编写的指令(问题或命令任务)

- 一个人工编写的参考响应

该数据集以两种形式发布:

- (a) 一个包含 100 个实例的验证集,其中包含完整数据集中的指令、图像和指令的参考答案。

- (b) 一个仅包含指令和图像的测试数据集。

排行榜包含模型在验证和测试数据集上的结果(信息也存在于论文中)。开发集允许实践者轻松测试和迭代他们的方法。评估沙盒位于我们的 GitHub 上。

实验

对于我们的初步实验,我们的基准评估了 13 个模型的性能。我们将其分为三类:

- 增强型大型语言模型(LLM)方法:GPT4 + 以图像 OCR 和/或密集图像字幕形式的视觉信息;

- 闭源大型多模态模型(LMM):GPT4V(ision) 和 Gemini-Vision-Pro;

- 开源大型多模态模型(LMM):LLaVA-v1.5-13B、ShareGPT4V-7B、Instruct-Blip-Vicuna-7B、mPlugOwl-v2-7B、Bliva-Vicuna-7B、Qwen-VL-7B 和 Idefics-9B。

我们的数据集为每条指令都包含一个参考响应,这使得我们能够测试各种自动评估方法。对于评估,我们使用 LLM-as-a-judge 方法,并向 GPT-4 提供指令、参考响应和预测响应。模型必须返回预测响应是否可接受。(选择 GPT4 是因为它在我们的实验中与人类判断的相关性最高。)

让我们看一些例子!

示例 1 在此示例中,尽管 GPT-4V 进行了逻辑推理,但对指令给出了不正确的响应。绿色表示与参考匹配的响应,而红色突出显示响应中的错误。此外,还提供了“总结推理”以概述 GPT-4V 得出答案所使用的推理过程。

示例 2 在此示例中,GPT-4V 正确响应了指令。然而,ShareGPT-4V-7B(性能最佳的开源 LMM)和带布局感知 OCR + 字幕的 GPT-4(增强型 LLM)由于缺乏对文本和图像的联合推理而产生了错误的响应。

您可以在我们论文的附录部分找到更多类似的例子!

主要收获!

在进行这项工作时,我们发现:

- 现代 LMM(专有模型和开源模型)在 ConTextual 数据集上的表现不佳,而人类则表现良好,这暗示了模型改进以增强富文本图像推理的可能性,这是一个具有重要现实世界应用的领域。

- 专有 LMM 在涉及时间阅读的信息图表推理中表现不佳,表明其能力与人类相比存在差距。值得注意的是,性能最佳的模型 GPT-4V 在抽象推理方面超越了人类,这可能是由于接触了表情包和引用数据,但在人类擅长的时间相关任务中却表现不佳。

- 对于 LLaVA-1.5-13B 和 ShareGPT-4V-7B 等开源模型,它们在获得可接受的人类评分的领域(抽象和自然场景上下文)与其他领域(时间阅读、信息图表、导航、购物、网页和移动使用)之间存在显著差距。因此,我们样本中涵盖的许多领域很可能超出了这些模型的分布。因此,开源模型应旨在增加其训练数据的多样性。

- 用大型语言模型增强 LMM,该模型通过 OCR 或字幕将视觉信息转换为文本,表现明显不佳,人类批准率仅为 17.2%。我们的样本需要精确的视觉感知与细粒度的视觉语言对齐相结合才能解决。

我们的分析表明,下一步有望实现:

- 开发增强型图像编码器,

- 创建高度准确的图像描述,

- 促进细粒度的视觉-语言对齐,以改善模型的感知并减少幻觉的发生。

这反过来将导致更有效的上下文敏感的富文本视觉推理。

接下来是什么?

我们也很乐意评估您的模型,以共同推动视觉语言模型的发展!要提交,请遵循以下指南。

我们希望这个基准能帮助开发细致的视觉-语言对齐技术,并欢迎任何形式的合作!您可以通过以下方式联系我们:Rohan 和 Hritik,并在此处了解更多关于团队的信息:Rohan、Hritik、Kai-Wei Chang、Nanyun (Violet) Peng。

如何提交?

我们接受测试集和验证集的提交。请遵循以下相应程序。

验证集提交

要将您的验证结果提交到排行榜,您可以按照这些说明运行我们的自动评估代码(使用 GPT4 的评估流程)。

我们希望提交的文件为 JSON 格式,如下所示:

{"model_name": {"img_url": "The boolean score of your model on the image, 1 for success and 0 for failure"}}

- 将模型名称替换为您的模型名称(字符串)

- 将 img_url 替换为实例的 img_url(字符串)

- img_url 的值为 0 或 1(整数)

应该有 100 个预测,对应于验证集的 100 个 URL。

要进行提交,请访问 HuggingFace 上托管的排行榜并填写提交表单。

测试集提交

一旦您对验证结果满意,您可以将您的模型预测发送给Rohan和Hritik。

请在您的电子邮件中包含:

- 您模型的名称。

- 组织(隶属关系)。

- (可选)GitHub 仓库或论文链接。

我们希望提交的格式为 JSON,类似于验证集,如下所示:

{"model_name": {"img_url": "predicted response"}}

- 将模型名称替换为您的模型名称(字符串)

- 将 img_url 替换为实例的 img_url(字符串)

- img_url 的值是该实例的预测响应(字符串)

应有 506 个预测,对应测试集的 506 个 URL。