Argunauts 训练第三阶段:RLVF(基于事后指令重标注、自我纠正和动态课程)

引言

在本文中,我将解释如何使用可验证奖励强化学习(RLVF)来提高大型语言模型(LLM)的批判性思维和论证分析能力。本文是我正在进行的工作的一个快照,也是关于 Argunauts 项目系列文章的延续。

☑️ Argunauts:动机与目标 ↪

☑️ 第一阶段:SFT 训练 ↪

☑️ 第二阶段:逐行自玩微调 ↪

✅ 第三阶段:✨RLVF(基于事后指令重标注、自我纠正和动态课程)✨

使用 RLVF 提高开放式大型语言模型的论证分析能力面临四大挑战:

- 我们需要为论证图绘制和逻辑论证分析中涉及的各种任务定义**强且可验证**的奖励。

- 训练必须处理针对**多个难度各异的任务**的**多个奖励**。

- 侧重于可验证的奖励,尤其是那些可以形式化或符号化验证的奖励,增加了奖励漏洞的风险。

- 我们的基础模型在一些它们本应学习的任务上达到了**零准确率**。

我正尝试通过以下方式解决这些挑战:

- 🏃♀️ 识别——非常符合 deepa2 的精神——论证图绘制和论证分析中涉及的各种**核心任务**;

- ⛹️♀️ 基于第一点,设计涉及多个核心任务的连贯和协调解决方案的额外**复杂任务**;

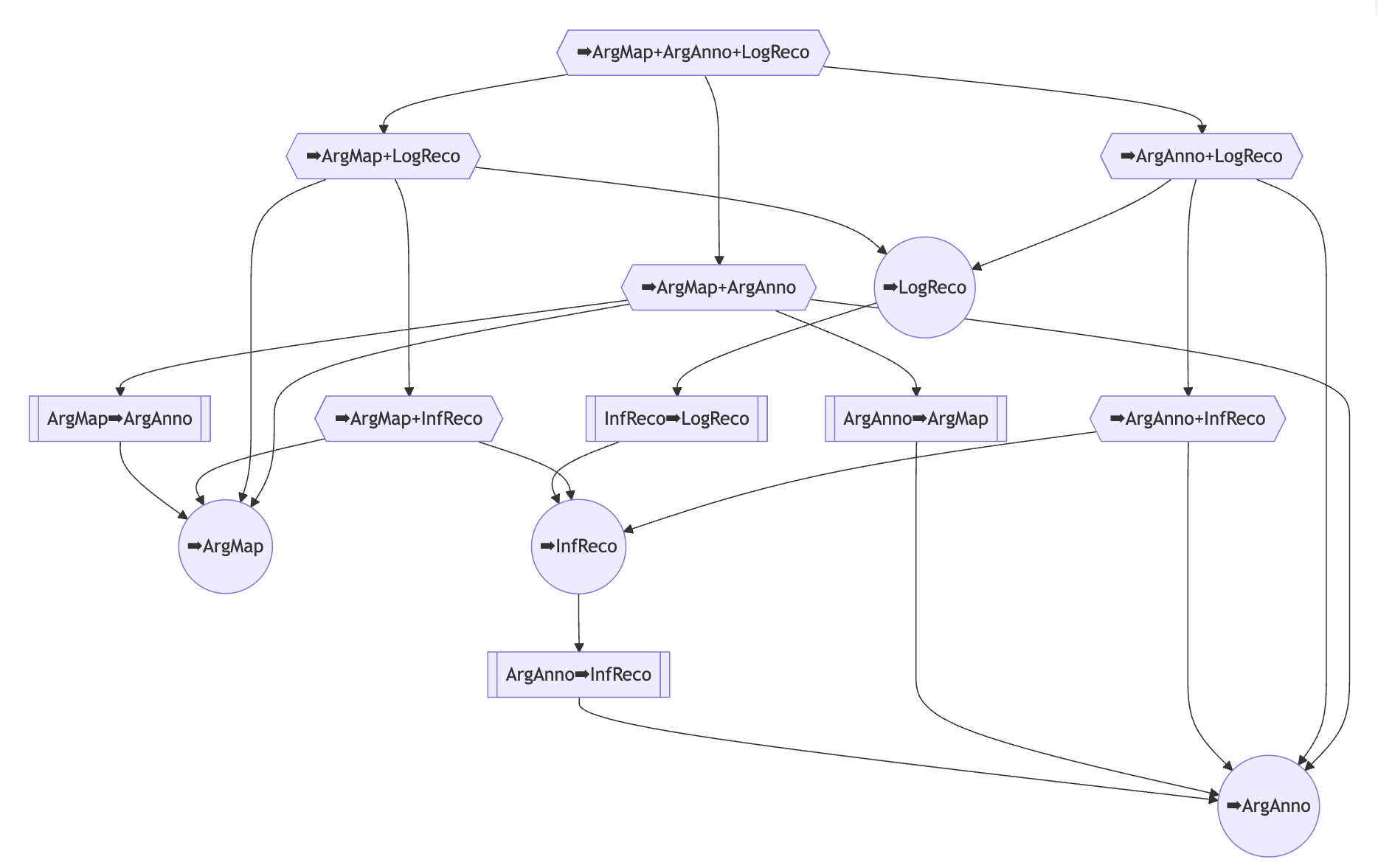

- 🌲 将各种任务(来自第一点和第二点)之间的**要求**映射到**教学依赖有向无环图(DAG)**中;

- 🕵️♀️ 利用 Argdown 语法、逻辑一致性和有效性,以及控制复杂任务的连贯性约束,构建**可验证的二元奖励**,并为任意候选解决方案生成详细的**自然语言错误消息**;

- 🛜 采用**在线 DPO** 作为一种简单干净的强化学习范式,可灵活扩展(如下文第 6、7、8 点所述);

- 👀 将**事后指令重标注(HIR)**应用于 DPO,利用**自然语言错误消息**(来自第 4 点),使模型能够**从负面反馈中学习**并防止部分/不完美奖励的过度泛化;

- 🪞 在强化学习流程中集成**多步自我纠正循环**,以生成带有评论或修订的额外偏好对;

- 🔄 训练期间,根据模型在每个任务(来自第 1 点和第 2 点)上的当前表现以及教学依赖 DAG(第 3 点)中任务的要求,**持续调整训练课程**。

论证分析任务与练习

四个核心任务涵盖论证文本标注、论证图绘制、非形式论证重构和形式论证重构

核心任务 arganno:对源文本进行论证标注。

示例项目

| 问题 | 解决方案 |

| 标注: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 | 公民现在面临着<PROP id=1>选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1>选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。 |

可验证奖励(选择)

- 符合 XML 标注方案

- 源文本完整性

- 所有已标注命题的唯一 ID

核心任务 argmap:将源文本重构为 Argdown 论证图。

示例项目

| 问题 | 解决方案 |

| 创建论证图: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

```argdown

|

可验证奖励(选择)

- 带边界的 argdown 代码块

- 有效的 Argdown 语法

- 没有前提结论结构

核心任务 infreco:非形式地重构源文本中提出的论证。

示例项目

| 问题 | 解决方案 |

| 非形式地重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

```argdown

|

可验证奖励(选择)

- 有效的 Argdown 语法

- 单个论证被重构为前提结论结构

- 有效的 yaml 推理元数据

核心任务 logreco:逻辑地重构源文本中呈现的论证。

示例项目

| 问题 | 解决方案 |

| 形式地重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

```argdown

|

可验证奖励(选择)

- 有效的 Argdown 语法

- 逻辑形式化格式良好

- 子推论的演绎有效性

- 没有逻辑上不相关的前提

在上述核心任务的基础上,我定义了六个复合任务,它们涉及多个核心任务的协调解决方案。这些复合任务旨在通过要求解决方案的不同部分相互连贯,来提供额外的**可验证语义约束**。

复合任务 argmap_plus_arganno:对源文本进行论证标注,并将其重构为论证图。

示例项目

| 问题 | 解决方案 |

| 标注并重构为图: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

::: 公民现在面临着 <PROP id=1 map_label="有钱人的利益">选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1 map_label="超级政治行动委员会">选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。::: ```argdown

|

可验证奖励(连贯性)

- 每个标注的命题都对应并一致地引用了论证图中的一个节点。

- 论证图中的每个节点都对应并一致地引用了已标注的命题。

- 标注的支持和攻击关系与论证图中草拟的辩证关系相匹配。

复合任务 arganno_plus_infreco:对源文本进行论证标注,并以标准形式非形式地重构论证。

示例项目

| 问题 | 解决方案 |

| 标注并重构为图: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

::: 公民现在面临着 <PROP id=1 reco_label="C3">选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1 reco_label="P1">选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。::: ```argdown

|

可验证奖励(连贯性)

- 每个标注的命题都对应并一致地引用了重构论证中的一个陈述(结论或前提)。

- 论证中的一些前提/结论对应并一致地引用了已标注的命题。

- 标注的支持关系与论证的推断相匹配。

复合任务 arganno_plus_logreco:对源文本进行论证标注,并以标准形式逻辑地重构论证。

示例项目

| 问题 | 解决方案 |

| 标注并逻辑重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

::: 公民现在面临着 <PROP id=1 reco_label="C4">选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1 reco_label="P1">选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。::: ```argdown

|

可验证奖励(连贯性)

- 每个标注的命题都对应并一致地引用了重构论证中的一个陈述(结论或前提)。

- 论证中的一些前提/结论对应并一致地引用了已标注的命题。

- 标注的支持关系与论证的推断相匹配。

复合任务 argmap_plus_infreco:论证映射源文本,并以标准形式(前提-结论结构)非形式地重构所有对应的论证。

示例项目

| 问题 | 解决方案 |

| 映射并重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

```argdown

|

可验证奖励(连贯性)

- 论证图中的每个节点都与非形式重构中的命题或论证相匹配。

- 图中草拟的每个辩证关系都以非形式重构中的推论关系为基础。

复合任务 argmap_plus_logreco:论证映射源文本,并以标准形式将所有相应的论证逻辑地重构为逻辑有效推论。

示例项目

| 问题 | 解决方案 |

| 映射并逻辑重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

```argdown

|

可验证奖励(连贯性)

- 论证图中的每个节点都与逻辑重构中的命题或论证相匹配。

- 图中草拟的每个辩证关系都以逻辑重构中的推论关系为基础。

复合任务 argmap_plus_arganno_plus_logreco:论证映射源文本,标注源文本,并以标准形式将所有相应的论证逻辑地重构为逻辑有效推论。

示例项目

| 问题 | 解决方案 |

| 映射、标注并逻辑重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。 |

::: 公民现在面临着 <PROP id=1 reco_label="C4">选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1 reco_label="P1">选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。::: ```argdown

|

可验证奖励(连贯性)

- 图和逻辑重构相互连贯(同上)

- 逻辑重构和标注相互连贯(同上)

- 标注和图相互连贯(同上)

另外四个顺序任务旨在通过从源文本的论证分析而非纯源文本本身开始,帮助模型学习更具挑战性的任务。

顺序任务 arganno_from_argmap:给定相应的论证图,对源文本进行论证标注。

| 问题 | 解决方案 |

根据图标注: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。```argdown

|

公民现在面临着<PROP id=1>选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1>选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。 |

顺序任务 argmap_from_arganno:将已进行论证标注的文本重构为论证图。

| 问题 | 解决方案 |

重构为图: 公民现在面临着<PROP id=1>选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1>选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。 |

```argdown

|

顺序任务 infreco_from_arganno:给定已进行论证标注的文本,以标准形式非形式地重构论证。

| 问题 | 解决方案 |

重构为图: 公民现在面临着<PROP id=1>选举系统中组织化的金钱利益权力日益增长的证据</PROP>,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。<PROP id=2 supports=1>选举系统正在被超级政治行动委员会(Super PACs)所重塑</PROP>,以及那些向其捐款的人选择最符合其目的的候选人的权力大幅增加。 |

```argdown

|

顺序任务 logreco_from_infreco:给定非形式重构,逻辑地重构论证并以标准形式呈现。

| 问题 | 解决方案 |

形式地重构: 公民现在面临着选举系统中组织化的金钱利益权力日益增长的证据,与此同时,国家比以往任何时候都更清楚地意识到,收入群体之间的不平等急剧增加,经济困难持续存在。选举系统正在被超级政治行动委员会(Super PACs)及其捐助者选择最符合其目的的候选人的权力大幅增加所重塑。```argdown

|

```argdown

|

教学依赖与动态训练课程

不同任务之间存在我们**先验**可识别的依赖关系:

- 掌握复合任务的前提是系统掌握该复合任务所涉及的组成任务。

- 从训练角度来看,掌握顺序任务的前提是系统掌握前置任务,因为顺序任务的输入将由模型在线自动生成。

这给我们提供了以下**教学依赖 DAG**

顶部节点代表最苛刻的任务,其中系统应生成源文本的语法和逻辑有效的标注、论证图和形式论证重构,所有这些都要求相互连贯。在 DAG 的底部,有两个根节点,代表论证映射和论证文本标注的核心任务。节点形状表示任务类型,圆形代表核心任务,六边形代表复合任务,矩形代表顺序任务。

Shi 等人(2025)证明了强化学习受益于仔细选择对模型来说既不太容易也不太难解决的任务。很明显,我们可以利用上述教学依赖 DAG 动态确定模型在给定时间应训练的任务,同时考虑到模型在任务上的当前表现。

例如,如果模型甚至不知道如何生成语法正确的 Argdown 论证图,那么练习创建与论证文本标注连贯的论证图就没有意义。

我目前是这样实现这个想法的:

假设我们每个训练周期总共有 $N$ 个练习预算。现在我们需要详细说明如何根据不同的任务 $t=1,...,14$ 动态分配这个预算。

我将 10% 的训练预算保留给四个核心任务,并均匀分配。非核心任务的初始预算为零。

剩余预算根据模型在不同任务上的当前表现 $a_i;(i=1...14)$ 递归分配。基本思想是训练模型尚未掌握,但依赖于模型已掌握的任务。

(展开查看算法)

令 $b_i$ 为已分配给任务 $i$ 的预算;令 $i_1, ..., i_k$ 表示教学依赖 DAG 中任意任务 $i$ 的 $k$ 个子任务。

我们再定义任务 $i$ 的当前**最大需求失败率** $\epsilon_i$ 如下:

如果 $i$ 有任何子项,否则 $\epsilon_i = 0$。

然后,我们可以将预算分配算法指定如下:

- 将未初始分配的自由预算转移到顶部任务。

- 如果预算 $b$ 转移到任务 $i$,则

- 将 $i$ 的预算 $b_i$ 增加 $(1 - \epsilon_i) \cdot b$;

- 将剩余预算 $\epsilon_i \cdot b$ 根据每个子任务 $i_l$ 的当前表现转移到任务 $i$ 的子任务 $i_1, ..., i_k$:$$\frac{1-a_{i_l}}{\sum_j(1-a_{i_j})} \epsilon_i \cdot b.$$

通过这种动态训练课程,我们期望模型首先训练简单/核心任务,然后逐步转向更具挑战性的任务。

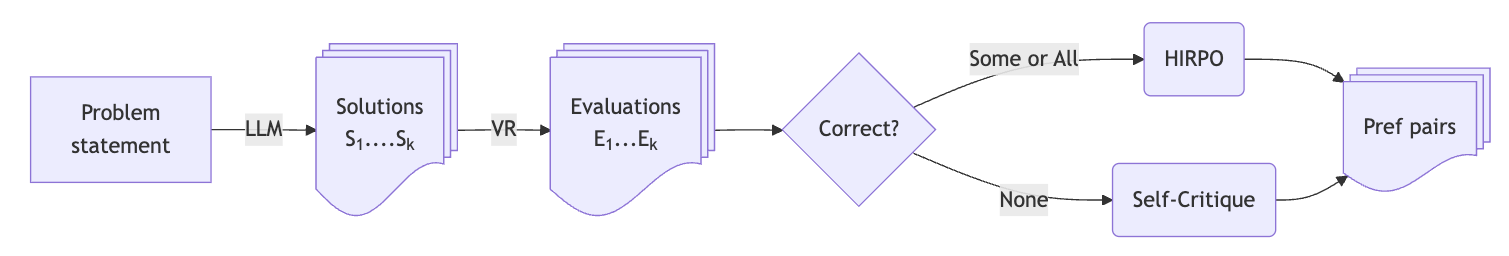

事后指令重标注直接偏好优化(HIRPO)

事后指令重标注(Hindsight Instruction Relabeling)是一种优雅的强化学习可验证奖励(RLVR)方法,最初由Zhang 等人(2023)提出。

在一个单一的 HIR 训练周期中,我们进行以下操作:

- 在线从模型中抽取答案,

- 评估答案,

- 将正确解决的指令和答案用作训练项,

- 对带有不正确答案的指令进行重新标注(例如,要求模型犯错),然后

- 将重新标注的指令和答案用作训练项,最后

- 使用监督微调(SFT)目标对模型进行训练。

让我们用一个简单的例子来说明事后指令重标注

| 指令 | 回答 | VR | HIR 训练项 (SFT) |

|---|---|---|---|

| 问:8*7=? | 答:56 | ✅ | 问:8*7=? 答:56 |

| 问:8*7=? | 答:57 | ❌ | 问:8*7=? (犯个错误!) 答:57 |

Zhang 等人(2023)证明,与仅使用正确解决的指令进行训练相比,将重新标注的指令添加到训练数据中可以显著提高模型的性能。这是因为 HIR “能够从失败案例中学习”(这可能有助于我们解决 GRPO 的一个明显缺点 (Xiong 等人 2025))。

Argunauts 项目将最初为 SFT 设计的 HIR 范式,迁移到在线 DPO 训练(→HIRPO)。在 HIRPO 中,我们还利用了在构建偏好对时存在不同类型错误的事实。以上述例子为例:

| 指令 | 答案 | HIRPO 提示 | HIRPO 选定 | HIRPO 拒绝 |

|---|---|---|---|---|

| 问:8*7=? | "A: 56", "A: 65", "A: Yes" | 问:8*7=? | 答:56 | 答:65 |

| 问:8*7=? | "A: 56", "A: 65", "A: Yes" | 问:8*7=? (混淆数字!) | 答:65 | 答:56 |

| 问:8*7=? | "A: 56", "A: 65", "A: Yes" | 问:8*7=? (制造 NaN 错误!) | 答:是 | 答:56 |

将 HIR 引入 DPO 的另一个好处现在变得显而易见:通过将第 2 行的偏好对添加到训练数据中,我们向模型展示了为什么第 1 行的选中答案优于被拒绝的答案。其直觉是,这可能有助于防止部分奖励的过度泛化。

但这还不是全部。

通过 HIRPO,即使模型没有生成任何正确答案,我们也可以构建偏好对:

| 指令 | 答案 | HIRPO 提示 | HIRPO 选定 | HIRPO 拒绝 |

|---|---|---|---|---|

| 问:8*7=? | "A: 57", "A: 65", "A: Yes" | 问:8*7=? (避免 NaN 错误!) | 答:65 | 答:是 |

此外,我们还可以奖励除了答案正确或不正确之外的优秀行为

| 指令 | 答案 | HIRPO 提示 | HIRPO 选定 | HIRPO 拒绝 |

|---|---|---|---|---|

| 问:8*7=? | "A: 56", "A: 56 ;-)", "A: 56, of course" | 问:8*7=? (别开玩笑!) | 答:56 | 答:56 ;-) |

| 问:8*7=? | "A: 56", "A: 56 ;-)", "A: 56, of course" | 问:8*7=? (加个笑话!) | 答:56 :-) | 答:56 |

在进行 HIRPO 实验的同时,Sun 等人(2025)发表了令人兴奋且更通用的“多层次感知偏好学习:增强复杂多指令任务的 RLHF”论文,其中包含了 HIRPO 的思想。我计划未来将 MAPL-DPO 整合到 Argunauts 项目中。以下是我目前看到的其他与 HIRPO 相关的方法:

| 方法 | 事后指令重标注 | 自然语言反馈 | 可验证的奖励 | DPO |

|---|---|---|---|---|

| HIR | ✅ | ✅ | ✅ | 🅾️ |

| IPR | ✅ | ✅ | ✅ | 🅾️ |

| CDF-DPO | 🅾️ | ✅ | ✅ | ✅ |

| CUT | 🅾️ | ✅ | ✅ | 🅾️ |

| MAPL-DPO | ✅ | 🅾️ | ✅ | ✅ |

| HIRPO | ✅ | ✅ | ✅ | ✅ |

HIRPO 如何应用于 Argunauts?

对于 14 项论证分析任务,我定义了大约**40 种可验证奖励**(其中部分已在上文列出),所有这些奖励都会生成二元奖励信号(正确/不正确)和高度具体的错误消息,这些错误消息反过来可以用于构建带有 HIRPO 的训练数据。

在此基础上,我还定义了另外**40 项额外的优秀分数**,用于评估模型答案的质量,这些分数不仅限于严格的正确性,例如论证图中的标签是否简洁,论证的前提是否与源文本一致,或者论证图是否密集(支持和攻击关系是否很多)。

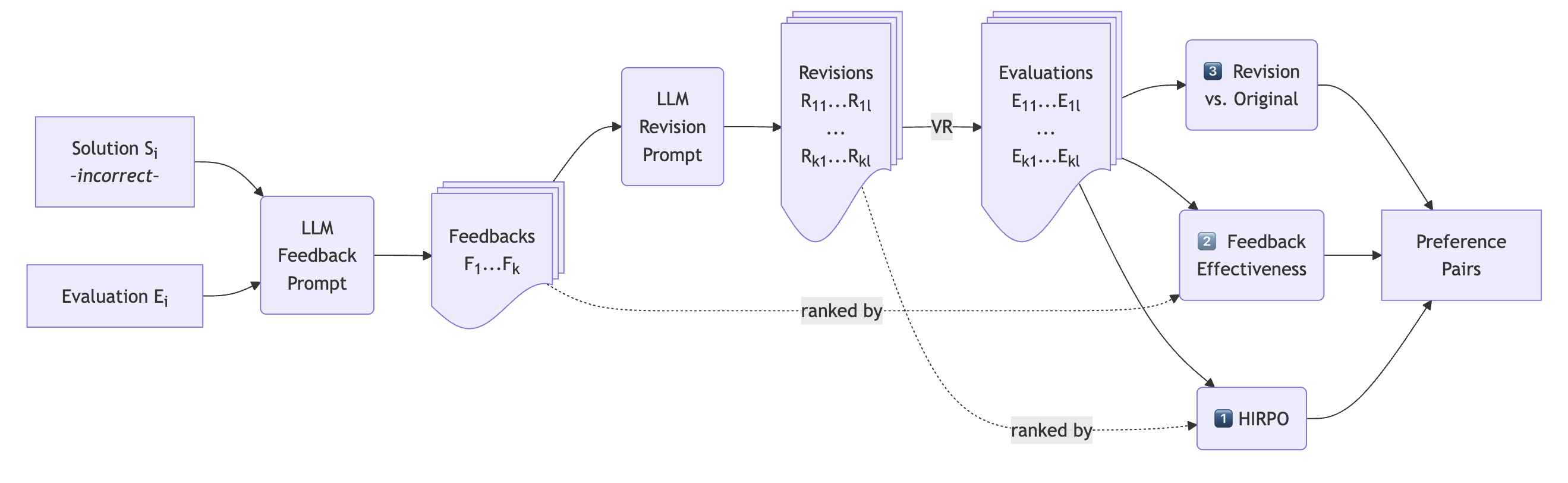

带自我纠正的在线 DPO

根据Kamoi 等人(2024)的研究,他们表明 LLM 的“自我纠正在可以使用可靠外部反馈的任务中效果良好”,我们利用可验证奖励的自然语言反馈,不仅用于构建 HIRPO 偏好对,还用于使模型能够

- 生成建设性反馈和

- 修订其原始答案。

当所有主要候选解决方案都不正确时,将触发自我批评工作流程。

在自我批评工作流程中,模型在看到不正确的答案和详细的错误消息后,被提示——作为老师——为学生提供建设性反馈。对于相应生成的每个反馈,然后要求模型修改其原始答案。所有修改后的答案将再次进行评估。

我们现在可以进一步构建偏好对,如下所示:

1️⃣ 我们对修订后的(而不是主要的)解决方案进行纯 HIRPO(如前所述)。

2️⃣ 我们根据不同反馈文本的有效性进行比较,即它们如何更好地帮助模型改进其答案。

3️⃣ 我们将修订后的答案与原始解决方案进行比较。

训练

问题集

我们正在使用来自DebateLabKIT/arguments-and-debates集合子集中的、经过精心挑选的、来自不同领域、长度各异的论证文本作为练习。

拥有一份内容深刻且多样化的论证文本阅读材料对于培养学生的批判性思维和论证分析能力非常有价值。扩展和改进论证文本的选择是一项持续的努力,我欢迎社区的贡献。

基础模型

我们使用的基础模型是 Argunauts 项目**第二阶段**的 Argunaut 模型 Llama-3.1-Argunaut-1-8B-SPIN,它是 meta-llama/Llama-3.1-8B-Instruct 的微调版本。

训练过程

每个训练周期包含以下步骤:

- 从论证文本集合中**抽取** `exercises_per_epoch` 个练习;并根据当前任务权重将练习**分配**给不同的任务类型。

- 为每个练习和任务**生成**答案和 HIRPO 对。

- **混入**之前周期生成的训练项,优先考虑那些对比有效和无效答案的项。

- 使用生成的 HIRPO 对,通过 DPO **训练**模型。

我们每隔 evaluate_epochs 个周期评估当前训练的模型,并根据模型在任务上的表现重新计算任务权重(参见动态课程)。

total_epochs: 128

evaluate_epochs: 4

采样参数

exercises_per_epoch: 512

eval_gen_kwargs:

temperature: 0.2

max_tokens: 4096

top_p: 0.95

min_p: 0.05

gen_kwargs:

temperature: 0.8

max_tokens: 4096

min_p: 0.05

feedback_gen_kwargs:

temperature: 0.8

max_tokens: 1024

min_p: 0.05

训练参数

loss_type: sigmoid

num_train_epochs: 2

per_device_train_batch_size: 2

gradient_accumulation_steps: 8

learning_rate: 5.0e-7

lr_scheduler_type: linear

warmup_ratio: 0.5

框架

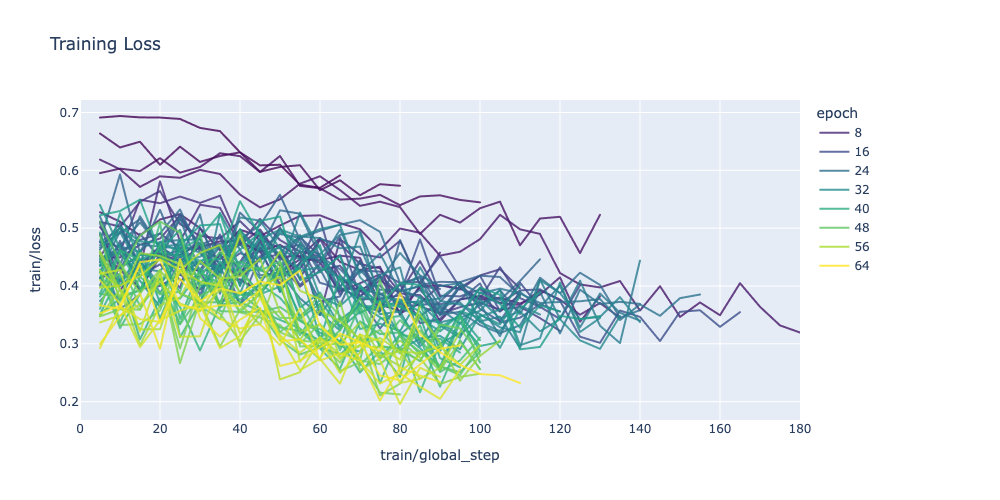

训练指标

训练损失在**每个周期内**和**从一个周期到另一个周期**都在下降

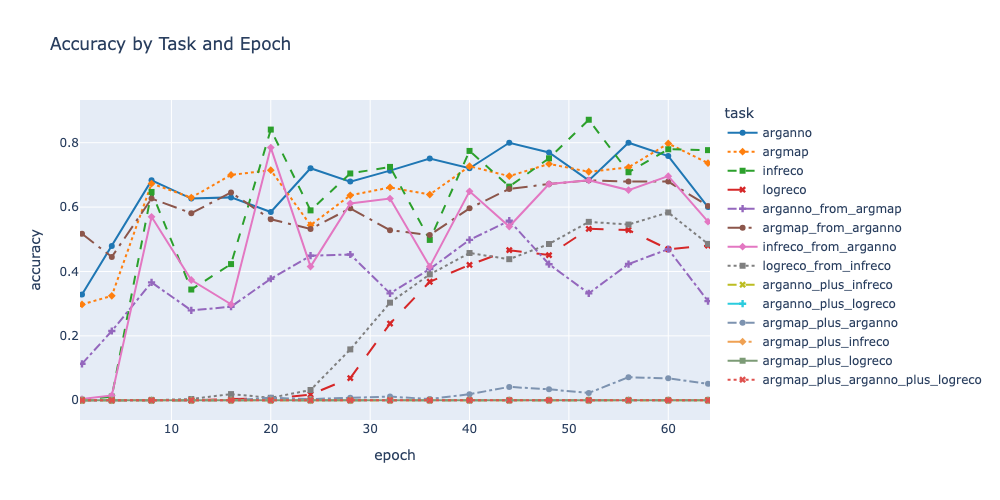

在 HIRPO 训练期间,模型在各种论证分析任务中的表现,根据评估集中的练习进行评估,显著提高

值得注意

- 模型获得了它最初根本不具备的技能,例如非形式论证重构(

infreco,大约在第 4 个周期)、逻辑论证分析(logreco,大约在第 20 个周期),以及较不成功的,连贯的论证映射和标注(argmap_plus_arganno,大约在第 40 个周期)。 - 在达到高水平表现后,指标会持续出现特征性波动,反映出随着训练重点动态转移到其他任务而出现的性能下降,然后随着训练返回到性能下降的任务而反弹。

- Llama-3.1-Argunaut-1-8B-HIRPO 未能掌握更复杂的任务,例如连贯标注和逻辑分析(

arganno_plus_logreco)。我将在未来的迭代中尝试解决这个问题,从更精确和详细的指令/提示开始。

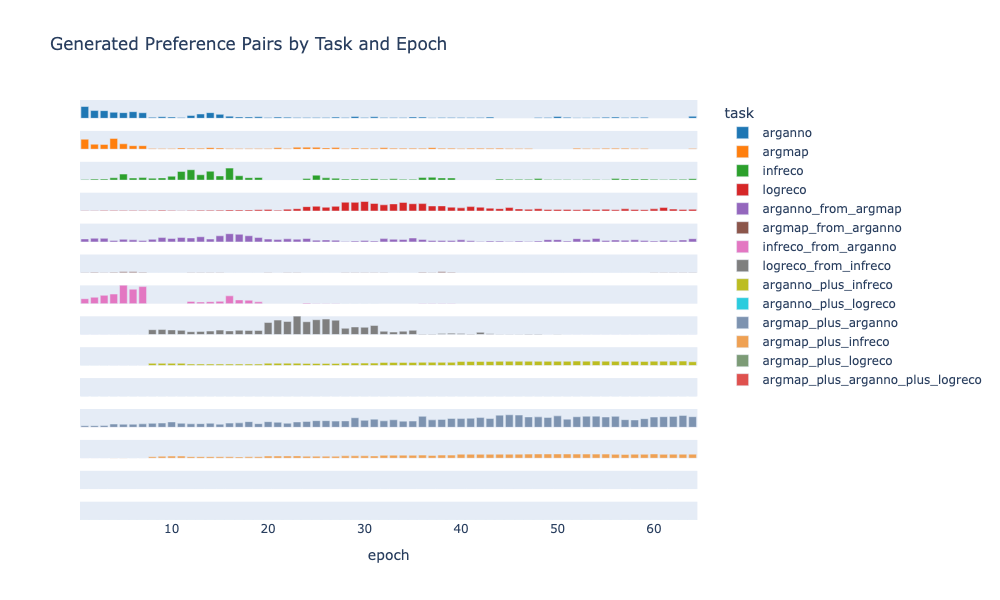

随着模型掌握越来越多的技能,训练课程也会动态调整,这体现在每个周期生成的训练项目数量上:

这也表明,螺旋式课程(训练回到之前掌握的任务)是训练过程的一个**新兴特征**(比较 infreco 或 logreco 训练项目的波动数量)。

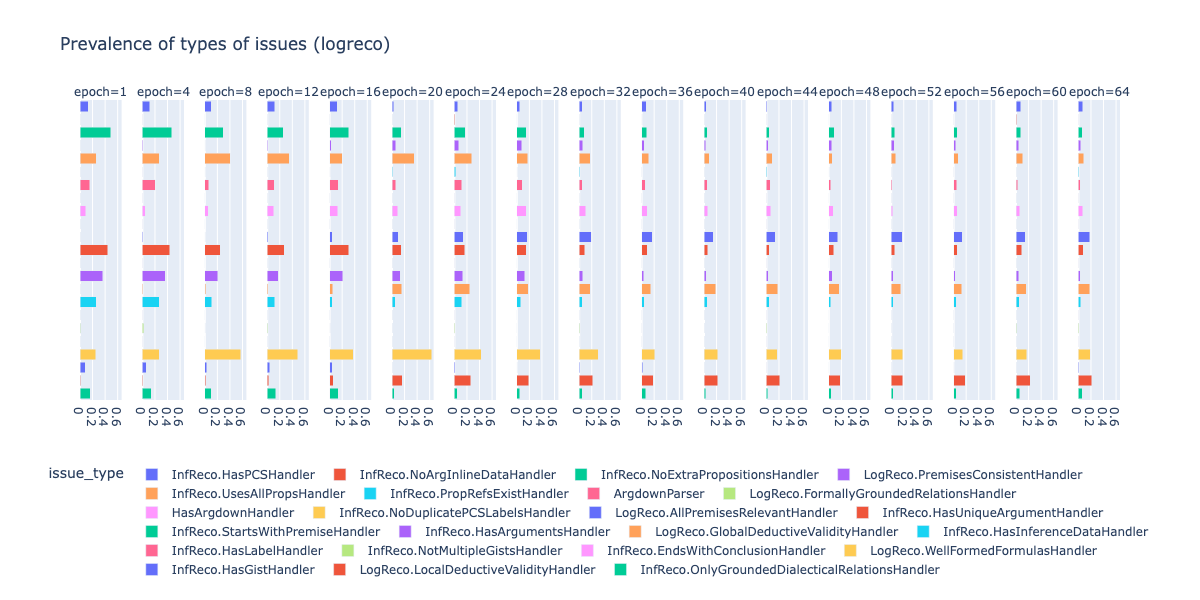

我们可以根据所犯的错误类型来分解性能。因此,模型可能由于非常不同的原因(例如,格式错误的边界代码块、缺少结论、缺少推断数据、格式错误的逻辑公式等)未能生成论证文本的有效逻辑重构。下图显示了模型在 logreco 任务中不同错误(问题)的发生率:

我们发现模型正在显著改进,并且在任务达到最低性能水平(大约第 20 个周期)之前,它就已经开始成功避免特定的错误。这是因为模型成功地从它一直在练习的其他任务中迁移了见解,或者因为它纯粹从负面反馈(失败类型偏好对)中学习。

评估

聊天体验

让我分享一下与 ggbetz/Llama-3.1-Argunaut-1-8B-HIRPO-dev4-Q4_K_M-GGUF 的聊天记录。

👤 **您**

您好,您熟悉 Argdown 吗?

🤖 **助手**

是的,我熟悉 Argdown,它是一种用于逻辑和批判性思维的标记语言,特别适用于表示和分析论证。它允许清晰、结构化地表示论证,包括主张和论证,以及推理树。如果您有需要我分析的论证,或者需要批判性思维问题的帮助,请随时提供详细信息!

👤 **您**

您能将以下文本的论证宏观结构可视化为 Argdown 论证图吗?

:::

校服可以遏制犯罪,提高学生安全。在加利福尼亚州长滩,实行全学区 K-8 强制校服政策两年后,学区学校的袭击和殴打报告下降了 34%,持致命武器袭击下降了 50%,打架事件下降了 51%,性犯罪减少了 74%,抢劫下降了 65%,持有武器(或“类似武器”)下降了 52%,持有毒品下降了 69%,故意破坏行为下降了 18%。[64]

内华达州斯帕克斯中学实施校服政策一年后,学校警方数据显示警方记录报告下降了 63%,帮派活动、学生打架、涂鸦、财产损失和殴打事件也都有所减少。一项同行评审研究发现,有校服政策的学校发生枪械相关事件的比例比没有校服的学校低 12%,毒品相关事件低 15%。[25][69]

校服还能防止学生将武器藏在宽松的衣服下,更容易在实地考察中追踪学生,并使校园内的入侵者更容易被发现。新泽西州洛迪学区总监弗兰克·夸特罗内表示:“当学生穿着统一时,他们会更安全。如果有人进入建筑物,入侵者很容易被识别出来。”[6][38]

此外,校服在学生之间创造了一个公平的竞争环境,减少了同伴压力和欺凌。当所有学生都穿着统一时,学生之间在服装选择上的竞争以及对那些穿着廉价或不时尚服装的学生进行嘲笑的情况就可以消除。校服协会的研究发现,83% 的教师认为“一套好的校服……可以防止基于外貌或经济背景的欺凌。”北德克萨斯大学家长教育中心创始人兼主任阿明塔·雅各布森表示,校服让“所有孩子在他们的外貌方面处于同一起跑线。我认为这可能给了他们一种归属感和被社会接受的感觉。”[5][91]

:::

🤖 **助手**

所提供的文本不包含具有明确前提和结论的论证。它提出了一些主张并用证据支持它们,但没有明确说明具有清晰前提和结论结构的论证。因此,没有论证可以映射。

如果您提供完整的论证,包括前提和结论,我可以帮助您创建 Argdown 论证图。请分享完整的论证。

👤 **您**

没错。但我要求您使用 Argdown 语法在一个 Argdown 片段中映射这些支持和攻击关系。

🤖 **助手**

根据所提供的信息,似乎存在一种隐含的论证结构。但是,没有明确的前提和结论,很难创建清晰的 Argdown 图。尽管如此,让我们表示所描述的支持和攻击关系。

[Conclusion~1]: School uniforms deter crime and increase student safety.

<+ <Subargument 1>:

<+ [Conclusion~2]: Implementing school uniforms reduces bullying based on appearance or economic background.

<+ <Subargument 2>:

<+ [Premise]: 83% of teachers think that a good school uniform can prevent bullying based on appearance or economic background.

<+ [Premise]: Reducing bullying based on appearance or economic background contributes to a sense of belonging and social acceptance among students.

<+ [Premise]: A sense of belonging and social acceptance among students is a desirable outcome.

👤 **您**

请用您自己的话总结文本中提出的主要论点。请勿超过 2-3 句话。

🤖 **助手**

论证的关键点是:校服可以遏制犯罪,提高学生安全。

👤 **您**

让我们专注于这个论点。为了记录,结论是什么?

🤖 **助手**

文本没有明确说明结论。它提供了支持证据和来自各种来源的引用。如果我必须根据文本推断结论,那将是

校服可以遏制犯罪,提高学生安全。

👤 **您**

现在,您能用 argdown 语法将这个论证重构为前提-结论结构(标准形式)吗?请在开始前提-结论结构之前给论证一个简洁的标题。

🤖 **助手**

该论证可以重构如下

- 论证没有明确说明结论是从前提推导出来的,因此我不会添加推理图。

(1) 83% of teachers think that a good school uniform can prevent bullying based on appearance or economic background.

(2) Reducing bullying based on appearance or economic background contributes to a sense of belonging and social acceptance among students.

(3) A sense of belonging and social acceptance among students is a desirable outcome.

--

School uniforms deter crime and increase student safety.

👤 **您**

嗯,请解释一下:这三个前提如何共同证明结论?

🤖 **助手**

这些前提通过建立校服、欺凌和学生福祉之间的联系来共同证明结论。具体而言,第一个前提表明绝大多数教师支持校服可以减少欺凌的观点,从而创造一个更安全、更和谐的学校环境。第二个前提表明减少欺凌会带来积极的学生社会动态,让他们感受到归属感和被接受感。第三个前提通过肯定这种社会动态是可取的结果来强化其价值。将这些前提结合起来,可以推断出校服(可以减少欺凌)有助于创造一个更积极、更安全的学校环境,从而支持校服可以遏制犯罪,提高学生安全的结论。

👤 **您**

您能添加一个连接性前提,明确地将积极环境与安全/犯罪威慑联系起来吗?

🤖 **助手**

我将相应地调整 argdown 代码。

(1) 83% of teachers think that a good school uniform can prevent bullying based on appearance or economic background.

(2) Reducing bullying based on appearance or economic background contributes to a sense of belonging and social acceptance among students.

(3) A sense of belonging and social acceptance among students is a desirable outcome.

(4) A positive school environment contributes to a safer school environment.

--------------------------

(5) School uniforms deter crime and increase student safety.

我的结论是,评估所证明的论证分析性能的提高并不能直接转化为聊天中更好的性能。……可能还表明,在某个时候,Argunaut 模型将不得不经历最终的经典指令微调阶段。

基准测试

🚧 即将推出,欢迎投稿

后续步骤

- 有太多需要实证检验和彻底评估的工作……所以,如果您是正在寻找具有易于实现成果的优秀项目的研究生或初级研究员,请与我联系!