Hugging Face 和 Graphcore 合作优化 IPU 上的 Transformers

在 2021 年 AI 硬件峰会上,Hugging Face 宣布推出新的硬件合作伙伴计划,其中包括设备优化模型和软件集成。在此,Graphcore——智能处理单元(IPU)的开发者,也是该计划的创始成员之一——解释了他们与 Hugging Face 的合作将如何让开发者轻松加速使用最先进的 Transformer 模型。

Graphcore 和 Hugging Face 是两家拥有共同目标的公司——让创新者更容易驾驭机器智能的力量。

Hugging Face 的硬件合作伙伴计划将允许使用 Graphcore 系统的开发者,以最低的编码复杂性,在生产规模上部署为我们的智能处理单元 (IPU) 优化的最先进的 Transformer 模型。

什么是智能处理单元?

IPU 是为 Graphcore 的 IPU-POD 数据中心计算系统提供动力的处理器。这种新型处理器旨在支持 AI 和机器学习的非常特定的计算要求。细粒度并行性、低精度算术以及处理稀疏性的能力等特性已内置到我们的芯片中。

Graphcore 的 IPU 没有采用像 GPU 那样的 SIMD/SIMT 架构,而是使用大规模并行 MIMD 架构,超高带宽内存紧邻处理器核心,直接位于硅片上。

这种设计提供了高性能和新级别的效率,无论是运行当今最流行的模型,如 BERT 和 EfficientNet,还是探索下一代 AI 应用。

软件在释放 IPU 功能方面发挥着至关重要的作用。我们的 Poplar SDK 自 Graphcore 成立以来就与处理器共同设计。如今,它已与标准机器学习框架(包括 PyTorch 和 TensorFlow)以及 Docker 和 Kubernetes 等编排和部署工具完全集成。

使 Poplar 与这些广泛使用的第三方系统兼容,使开发者能够轻松地将其模型从其他计算平台移植过来,并开始利用 IPU 的先进 AI 功能。

为生产优化 Transformer

Transformers 彻底改变了(双关语)人工智能领域。Graphcore 的客户在 NLP 及其他领域的广泛应用中广泛使用 BERT 等模型。这些多功能模型可以执行特征提取、文本生成、情感分析、翻译和许多其他功能。

Hugging Face 已经拥有数百个 Transformers,从法语 CamemBERT 到将 NLP 经验应用于计算机视觉的 ViT。Transformers 库平均每月下载量达 200 万次,需求还在增长。

Hugging Face 拥有超过 50,000 名开发者用户,创下了开源项目采用速度最快的纪录。

现在,凭借其硬件合作伙伴计划,Hugging Face 正在将终极 Transformer 工具集与当今最先进的 AI 硬件连接起来。

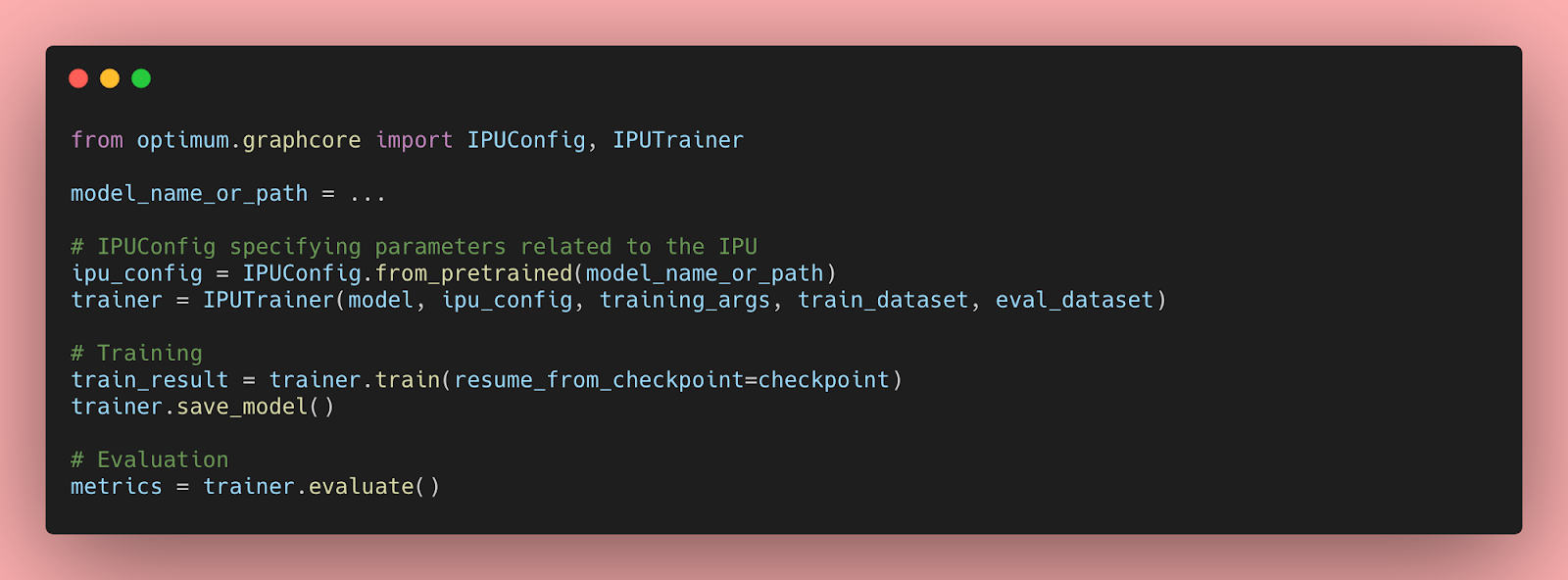

通过使用 Optimum(一个新的开源库和工具包),开发者将能够访问 Hugging Face 认证的硬件优化模型。

这些模型由 Graphcore 和 Hugging Face 合作开发,首批 IPU 优化模型将于今年晚些时候在 Optimum 上发布。最终,它们将涵盖从视觉、语音到翻译和文本生成等广泛应用。

Hugging Face 首席执行官 Clément Delangue 表示:“开发者都希望使用最新、最棒的硬件——比如 Graphcore IPU,但总是会遇到是否需要学习新代码或新流程的问题。有了 Optimum 和 Hugging Face 硬件计划,这根本不是问题。它基本上是即插即用的。”

SOTA 模型邂逅 SOTA 硬件

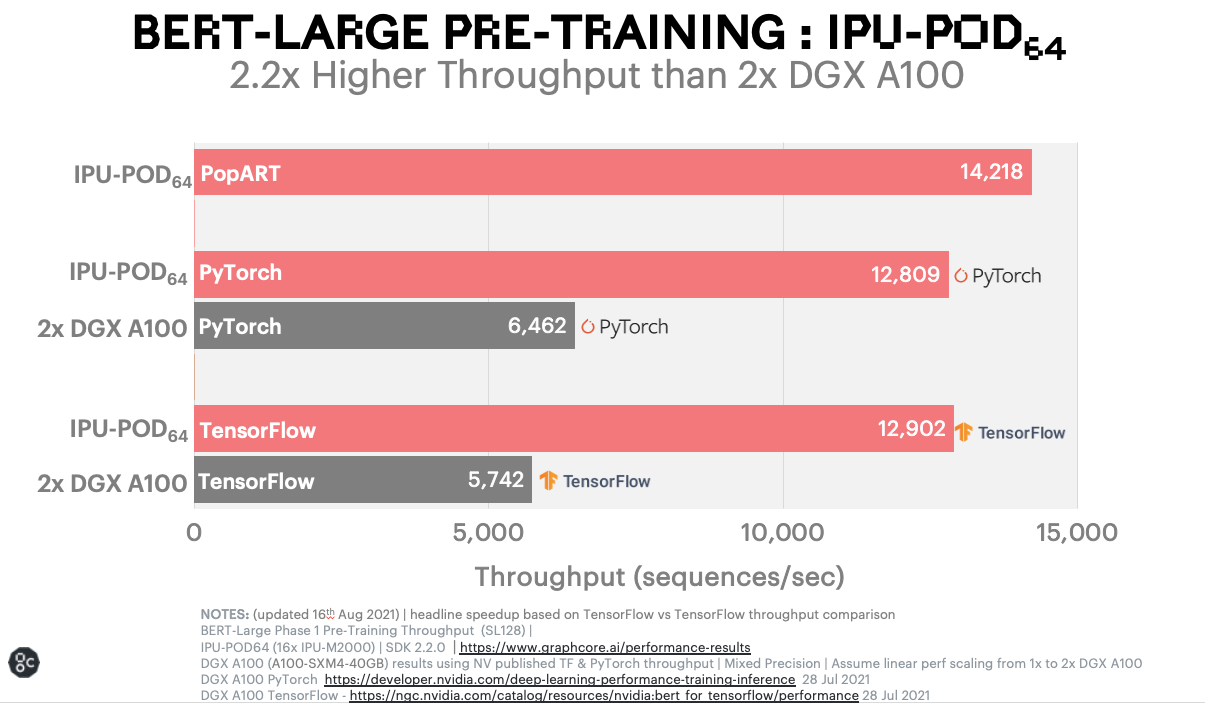

在宣布与 Hugging Face 合作之前,我们已经通过使用 Pytorch 专门为 Graphcore 优化实现 Hugging Face BERT,展示了 IPU 加速最先进 Transformer 模型的能力。

有关此示例的完整详细信息,请参阅 Graphcore 博客:IPU 上的 BERT-Large 训练解析。

BERT 在 Graphcore 系统上运行的显著基准测试结果,与同类基于 GPU 的系统相比,对于目前在 IPU 以外的设备上运行流行 NLP 模型的用户来说,无疑是一个诱人的前景。

这种加速对于机器学习研究人员和工程师来说具有颠覆性意义,它能为他们节省宝贵的训练时间,并在开发新模型时进行更多次迭代。

现在,Graphcore 用户将能够通过 Hugging Face 平台,凭借其优雅的简洁性和卓越的模型范围,解锁这些性能优势。

Hugging Face 和 Graphcore 携手合作,帮助更多人接触 Transformer 的强大功能,并加速 AI 革命。

访问 Hugging Face 硬件合作伙伴门户,了解更多关于 Graphcore IPU 系统以及如何获取它们的信息。