Graphcore 与 Hugging Face 联袂推出全新 IPU-Ready Transformers 系列模型

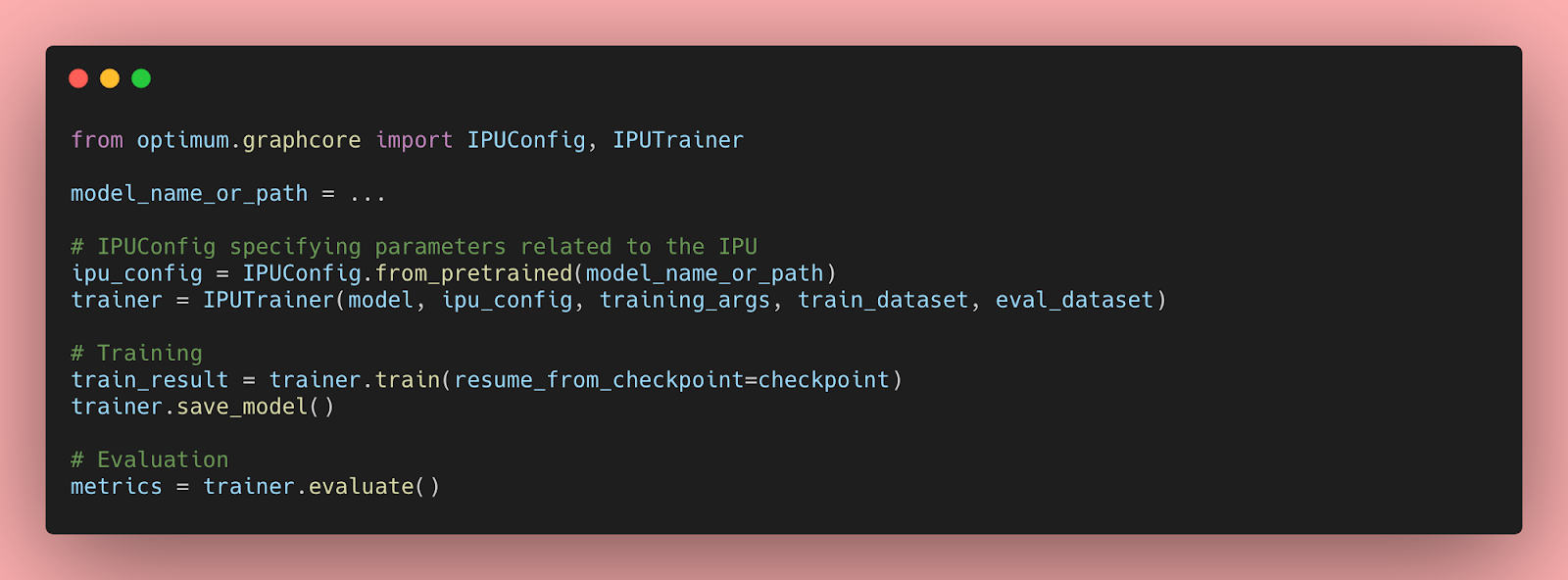

Graphcore 与 Hugging Face 显著扩展了 Hugging Face Optimum 中可用的机器学习模态和任务范围。Hugging Face Optimum 是一个用于 Transformer 性能优化的开源库。现在,开发人员可以方便地访问各种开箱即用的 Hugging Face Transformer 模型,这些模型经过优化,能够在 Graphcore 的 IPU 上提供最佳性能。

继 Optimum Graphcore 发布后不久推出的 BERT Transformer 模型之后,开发人员现在可以访问 10 种涵盖自然语言处理 (NLP)、语音和计算机视觉的模型。这些模型都附带了 IPU 配置文件以及可随时使用的预训练和微调模型权重。

全新 Optimum 模型

计算机视觉

ViT (Vision Transformer) 是图像识别领域的一项突破,它使用 Transformer 机制作为其主要组件。当图像输入 ViT 时,它们会被分成小块,类似于语言系统中处理单词的方式。每个小块都由 Transformer 编码 (嵌入),然后可以单独处理。

自然语言处理

GPT-2 (生成式预训练 Transformer 2) 是一个文本生成 Transformer 模型,它在一个非常大的英文语料库上以自监督方式进行了预训练。这意味着它仅在原始文本上进行预训练,没有任何人工标注 (这就是为什么它可以使用大量公开数据),并通过一个自动化过程从这些文本中生成输入和标签。更准确地说,它通过猜测句子中的下一个单词来从提示中生成文本。

RoBERTa (稳健优化的 BERT 方法) 是一个 Transformer 模型,它 (像 GPT-2 一样) 在一个大型英文语料库上以自监督方式进行了预训练。更准确地说,RoBERTa 是使用掩码语言建模 (MLM) 目标进行预训练的。给定一个句子,模型会随机掩盖输入中 15% 的单词,然后将整个被掩盖的句子输入模型,并必须预测被掩盖的单词。RoBERTa 可以用于掩码语言建模,但主要用于在下游任务上进行微调。

DeBERTa (使用解耦注意力的解码增强 BERT) 是一个用于自然语言处理任务的预训练神经语言模型。DeBERTa 采用了两种新技术——解耦注意力机制和增强型掩码解码器——来改进 2018 年的 BERT 和 2019 年的 RoBERTa 模型,从而显著提高了模型预训练的效率和下游任务的性能。

BART 是一个 Transformer 编码器-解码器 (seq2seq) 模型,具有一个双向 (类似 BERT) 的编码器和一个自回归 (类似 GPT) 的解码器。BART 的预训练方式是 (1) 用任意的噪声函数破坏文本,以及 (2) 学习一个模型来重建原始文本。BART 在针对文本生成 (例如摘要、翻译) 进行微调时特别有效,但在理解任务 (例如文本分类、问答) 方面也表现良好。

LXMERT (从 Transformer 中学习跨模态编码器表示) 是一个用于学习视觉和语言表示的多模态 Transformer 模型。它有三个编码器:一个对象关系编码器、一个语言编码器和一个跨模态编码器。它通过掩码语言建模、视觉-语言文本对齐、ROI 特征回归、掩码视觉属性建模、掩码视觉对象建模和视觉问答等目标的组合进行预训练。它在 VQA 和 GQA 视觉问答数据集上取得了业界最佳结果。

T5 (文本到文本迁移 Transformer) 是一个革命性的新模型,它可以将任何文本转换为用于翻译、问答或分类的机器学习格式。它引入了一个统一的框架,将所有基于文本的语言问题都转换为文本到文本的格式以进行迁移学习。通过这种方式,它简化了在各种自然语言处理任务中使用相同模型、目标函数、超参数和解码过程的方法。

语音

HuBERT (隐藏单元 BERT) 是一个在音频上预训练的自监督语音识别模型,它在连续输入上学习了一个组合的声学和语言模型。HuBERT 模型在 Librispeech (960h) 和 Libri-light (60,000h) 基准测试中,使用 10 分钟、1 小时、10 小时、100 小时和 960 小时微调子集,其性能与业界最先进的 wav2vec 2.0 相当或更好。

Wav2Vec2 是一个用于自动语音识别的预训练自监督模型。Wav2Vec2 使用一种新颖的对比性预训练目标,从大量未标记的语音数据中学习强大的语音表示,然后在少量转录的语音数据上进行微调,其性能优于最好的半监督方法,同时概念上更简单。

Hugging Face Optimum Graphcore:基于坚实合作关系的再深化

Graphcore 于 2021 年作为创始成员加入了 Hugging Face 硬件合作伙伴计划,两家公司都怀抱着一个共同目标:为希望利用机器智能力量的创新者们降低门槛。

自那时起,Graphcore 和 Hugging Face 广泛合作,旨在让在 IPU 上训练 Transformer 模型变得既快速又简单,首个 Optimum Graphcore 模型 (BERT) 已于去年推出。

Transformers 已被证明在广泛的功能中非常高效,包括特征提取、文本生成、情感分析、翻译等等。像 BERT 这样的模型被 Graphcore 的客户广泛用于各种应用,包括网络安全、语音通话自动化、药物发现和翻译。

在现实世界中优化它们的性能需要大量的时间、精力和技能,这超出了许多公司和组织的能力范围。通过提供一个开源的 Transformer 模型库,Hugging Face 直接解决了这些问题。将 IPU 与 Hugging Face 集成也让开发人员不仅可以利用模型,还可以利用 Hugging Face Hub 中可用的数据集。

现在,开发人员可以使用 Graphcore 系统来训练 10 种不同类型的业界领先 Transformer 模型,并以最少的编码复杂性访问数千个数据集。通过这次合作,我们为用户提供了工具和生态系统,以便他们轻松下载最先进的预训练模型,并将其微调到各种领域和下游任务。

Graphcore 最新硬件和软件齐上阵

虽然 Hugging Face 不断扩大的用户群已经能够从 IPU 技术的速度、性能以及功耗和成本效率中获益,但 Graphcore 最近发布的硬件和软件组合将释放更多潜力。

在硬件方面,于三月份发布并现已向客户发货的 Bow IPU 是世界上第一款使用晶圆堆叠晶圆 (Wafer-on-Wafer, WoW) 3D 堆叠技术的处理器,将 IPU 的诸多优势提升到了一个新的水平。凭借在计算架构、芯片实现、通信和内存方面的突破性进展,每个 Bow IPU 可提供高达 350 teraFLOPS 的 AI 计算能力——性能提升了令人瞩目的 40%——并且与上一代 IPU 相比,能效提高了多达 16%。重要的是,Hugging Face Optimum 用户可以从上一代 IPU 无缝切换到 Bow 处理器,因为无需更改任何代码。

软件在释放 IPU 的能力方面也起着至关重要的作用,因此 Optimum 自然而然地提供了与 Graphcore 易于使用的 Poplar SDK 的即插即用体验——该 SDK 本身也迎来了 2.5 版本的重大更新。Poplar 使在最先进的硬件上训练最先进的模型变得轻而易举,这要归功于它与标准机器学习框架 (包括 PyTorch、PyTorch Lightning 和 TensorFlow) 以及 Docker 和 Kubernetes 等编排和部署工具的完全集成。让 Poplar 与这些广泛使用的第三方系统兼容,使得开发人员可以轻松地将他们的模型从其他计算平台移植过来,并开始利用 IPU 先进的 AI 功能。

即刻开始体验 Hugging Face 的 Optimum Graphcore 模型

如果您有兴趣将 IPU 技术的优势与 Transformer 模型的强大功能相结合,您可以从 Hugging Face Hub 上的 Graphcore 组织下载最新的 Optimum Graphcore 模型系列,或从 Optimum GitHub 仓库获取代码。我们的入门博客文章将指导您完成每一步,开始体验 IPU。

此外,Graphcore 还建立了一个内容丰富的开发者资源页面,您可以在其中找到 IPU Model Garden——一个包含计算机视觉、自然语言处理、图网络等可随时部署的机器学习应用的仓库——以及大量的文档、教程、操作视频、网络研讨会等等。您还可以访问 Graphcore 的 GitHub 仓库获取更多代码参考和教程。

要了解更多关于在 Graphcore 上使用 Hugging Face 的信息,请访问我们的合作伙伴页面!