Llama-3.1-8b 在 AWS Inferentia2 上的性能(延迟 & 吞吐量)

Llama-3.1-8b 在 Inferentia2 上的速度有多快?让我们来了解一下!

对于这个基准测试,我们将使用以下配置

| 模型类型 | 批大小 | 序列长度 |

|---|---|---|

| Llama3.1 8b 批大小1 | 1 | 4096 |

| Llama3.1 8b 批大小4 | 4 | 4096 |

| Llama3.1 8b 批大小8 | 8 | 4096 |

| Llama3.1 8b 批大小16 | 16 | 4096 |

| Llama3.1 8b 批大小32 | 32 | 4096 |

注意:所有模型都编译为使用 4 个设备,对应于 inf2.48xlarge 实例上的 8 个核心。

注意:请参考 Inferentia2 产品页面 以了解可用实例的详细信息。

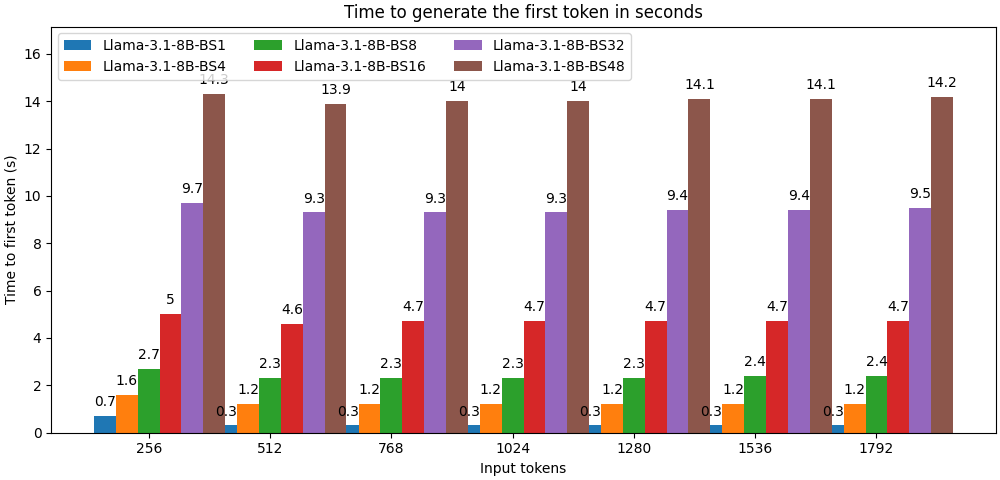

第一个token生成时间

第一个token生成时间是指处理输入token并生成第一个输出token所需的时间。这是一个非常重要的指标,因为它直接对应于用户在流式生成token时感知到的延迟。

我们测试了随着上下文大小增加的第一个token生成时间,从典型的问答使用到繁重的检索增强生成 (RAG) 使用场景。

第一个token生成时间以 **秒** 为单位表示。

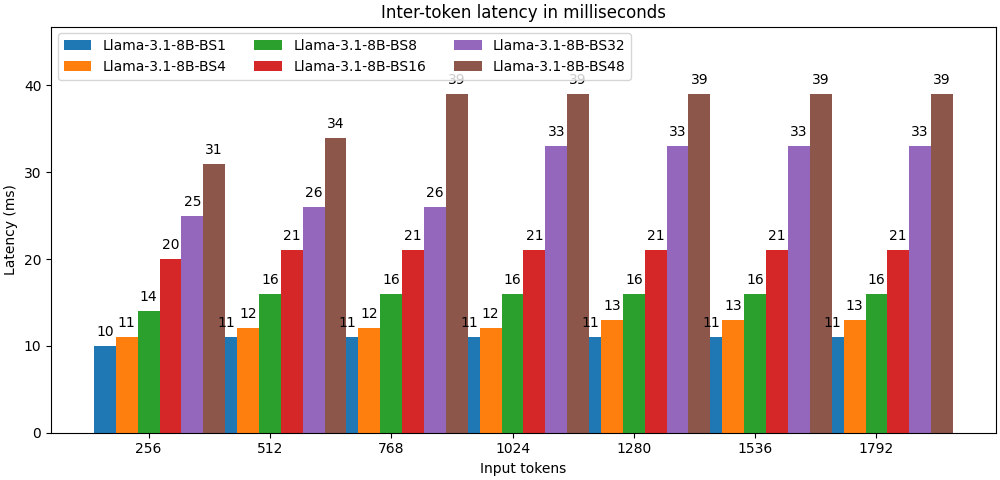

Token间延迟

Token间延迟对应于两个生成的token之间经过的平均时间。

它以 **毫秒** 为单位表示。

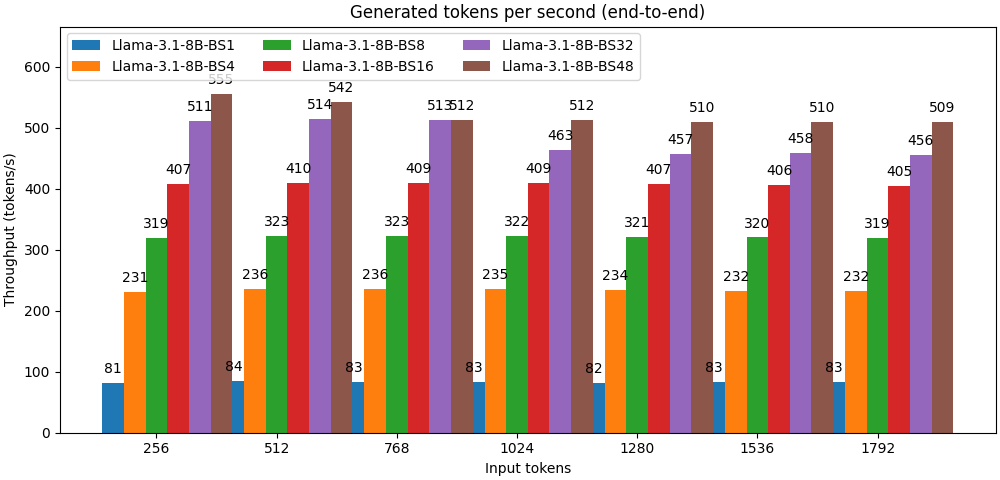

吞吐量

与其他一些基准测试不同,我们仅使用生成的token来评估吞吐量,方法是用生成的token数量除以端到端延迟。

吞吐量以 **token/秒** 为单位表示。