Llama-3-8b 在 AWS Inferentia2 上的性能(延迟和吞吐量)

Llama-3-8b 在 Inferentia2 上的速度如何?让我们来弄清楚!

对于这个基准测试,我们将使用以下配置

| 模型类型 | batch_size | sequence_length |

|---|---|---|

| Llama3 8b BS1 | 1 | 4096 |

| Llama3 8b BS4 | 4 | 4096 |

| Llama3 8b BS8 | 8 | 4096 |

| Llama3 8b BS16 | 16 | 4096 |

| Llama3 8b BS32 | 32 | 4096 |

注意:所有模型都编译为使用 4 个设备,对应于 inf2.48xlarge 实例上的 8 个核心。

注意:有关可用实例的详细信息,请参阅inferentia2 产品页面。

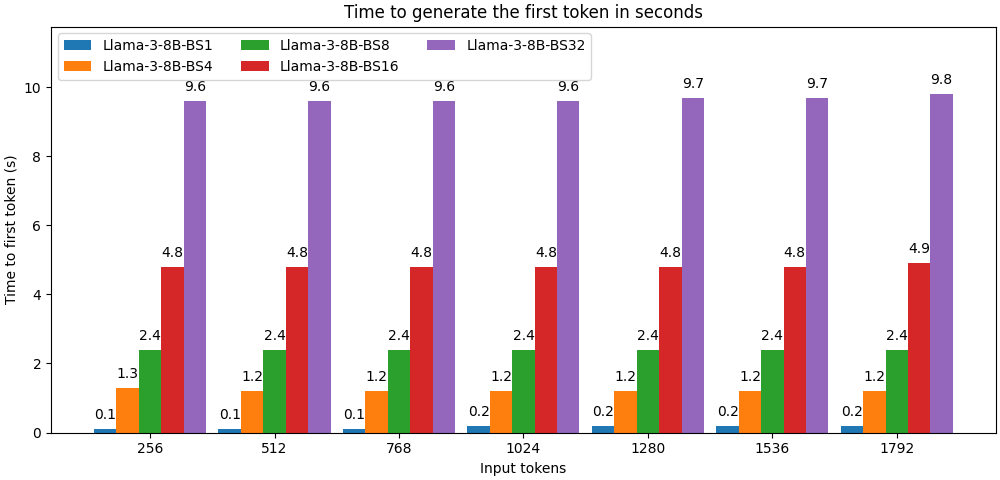

首个 token 的时间

首个 token 的时间是指处理输入 token 并生成第一个输出 token 所需的时间。这是一个非常重要的指标,因为它对应于用户在流式传输生成 token 时直接感知到的延迟。

我们测试了首个 token 的时间,以测试从典型的问答使用到沉重的检索增强生成 (RAG) 用例的不断增长的上下文大小。

首个 token 的时间以**秒**表示。

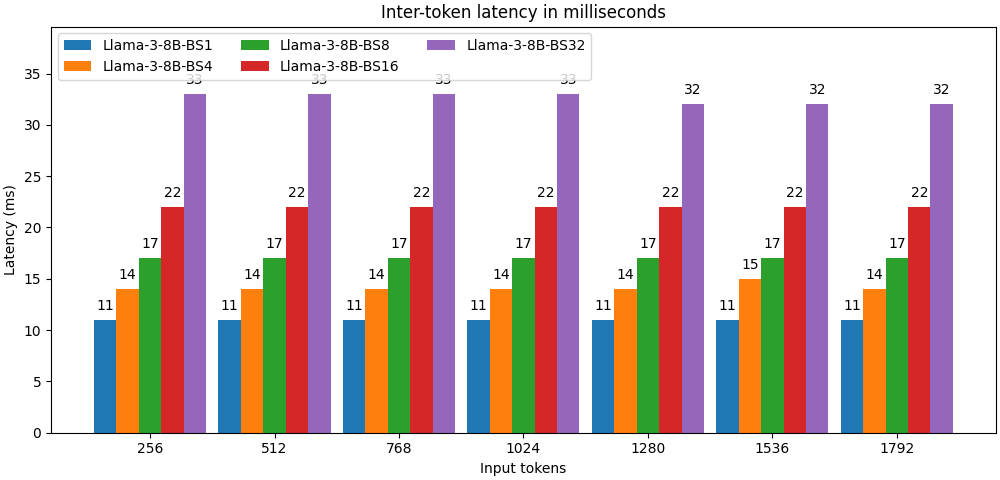

token 间延迟

token 间延迟对应于两个生成的 token 之间经过的平均时间。

它以**毫秒**表示。

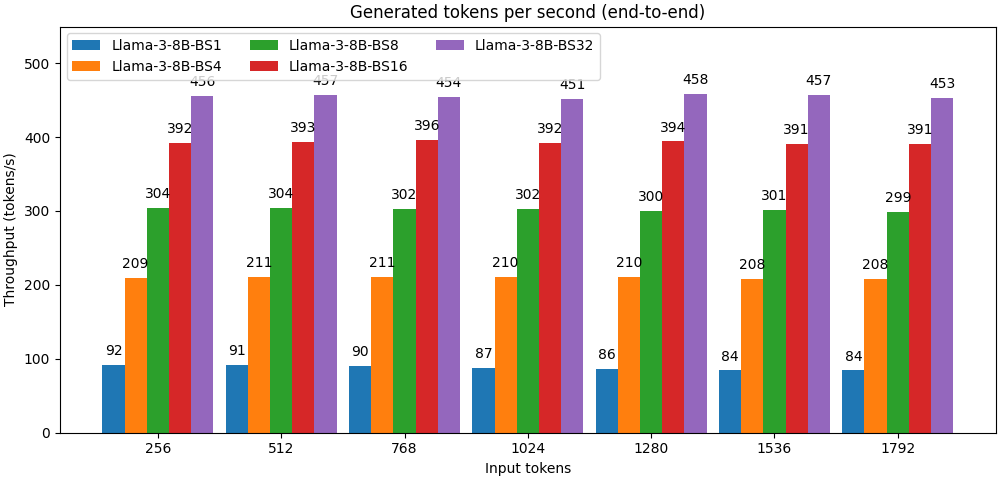

吞吐量

与其他一些基准测试不同,我们只使用生成的 token 来评估吞吐量,方法是将 token 的数量除以端到端延迟。

吞吐量以 **token/秒** 为单位。