TRL 文档

Liger 内核集成

加入 Hugging Face 社区

并获得增强的文档体验

开始使用

Liger 内核集成

此部分正在建设中。欢迎贡献!

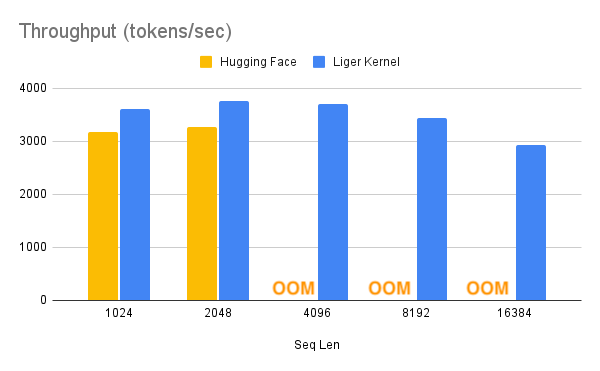

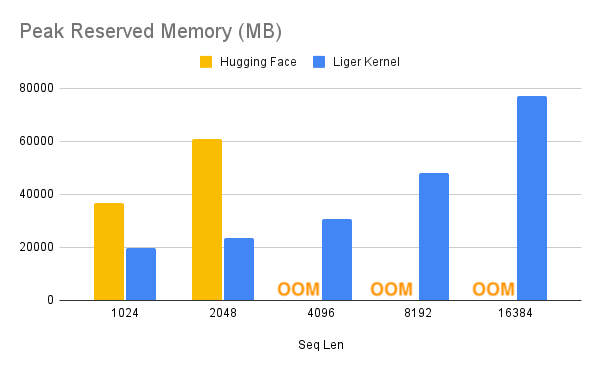

Liger Kernel 是专为 LLM 训练设计的一系列 Triton 内核。它可以有效将多 GPU 训练吞吐量提高 20%,并将内存使用量减少 60%。这样,我们就可以将上下文长度增加 4 倍,如下面的基准测试所述。他们已经实现了与 Hugging Face 兼容的 RMSNorm、RoPE、SwiGLU、CrossEntropy、FusedLinearCrossEntropy,未来还会有更多。该内核可以与 FlashAttention、PyTorch FSDP 和 Microsoft DeepSpeed 开箱即用。

通过这种内存减少,你可能可以关闭 cpu_offloading 或梯度检查点以进一步提升性能。

| 加速 | 内存减少 |

|---|---|

|  |

- 要在 SFTTrainer 中使用 Liger-Kernel,请先通过以下命令安装它

pip install liger-kernel

- 安装后,在 SFTConfig 中设置

use_liger_kernel。无需其他更改!

training_args = SFTConfig(

use_liger_kernel=True,

...

)要了解有关 Liger-Kernel 的更多信息,请访问其官方仓库。

< > 在 GitHub 上更新