推理端点(专用)文档

使用自定义容器镜像

加入 Hugging Face 社区

并获得增强的文档体验

开始使用

使用自定义容器镜像

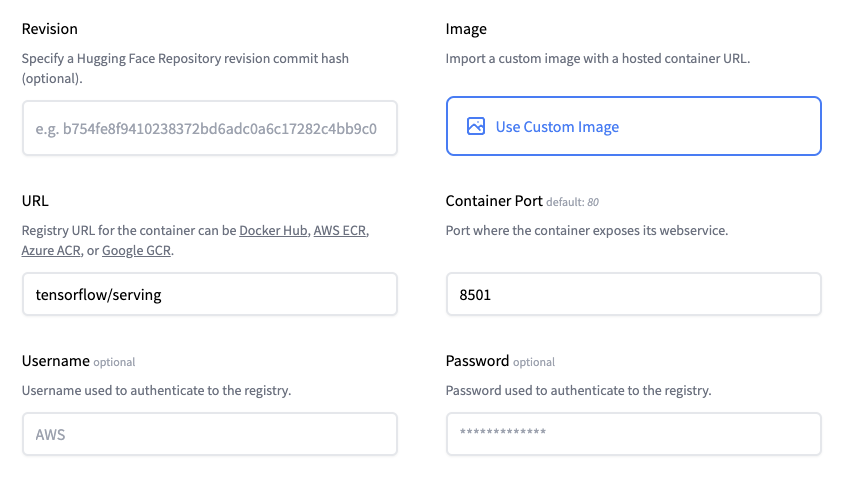

推理端点不仅允许你自定义你的推理处理程序,还允许你提供自定义容器镜像。这些镜像可以是公共镜像,例如 tensorflow/serving:2.7.3,也可以是托管在 Docker Hub、AWS ECR、Azure ACR 或 Google GCR 上的私有镜像。

从自定义镜像创建你的镜像工件的流程与基础镜像的流程相同。这意味着推理端点将从你提供的镜像派生出一个独特的镜像工件,其中包含所有模型工件。

模型工件(权重)存储在 /repository 目录下。例如,如果你使用 tensorflow/serving 作为自定义镜像,那么你必须设置 `model_base_path=“/repository”

tensorflow_model_server \

--rest_api_port=5000 \

--model_name=my_model \

--model_base_path="/repository"